Содержание

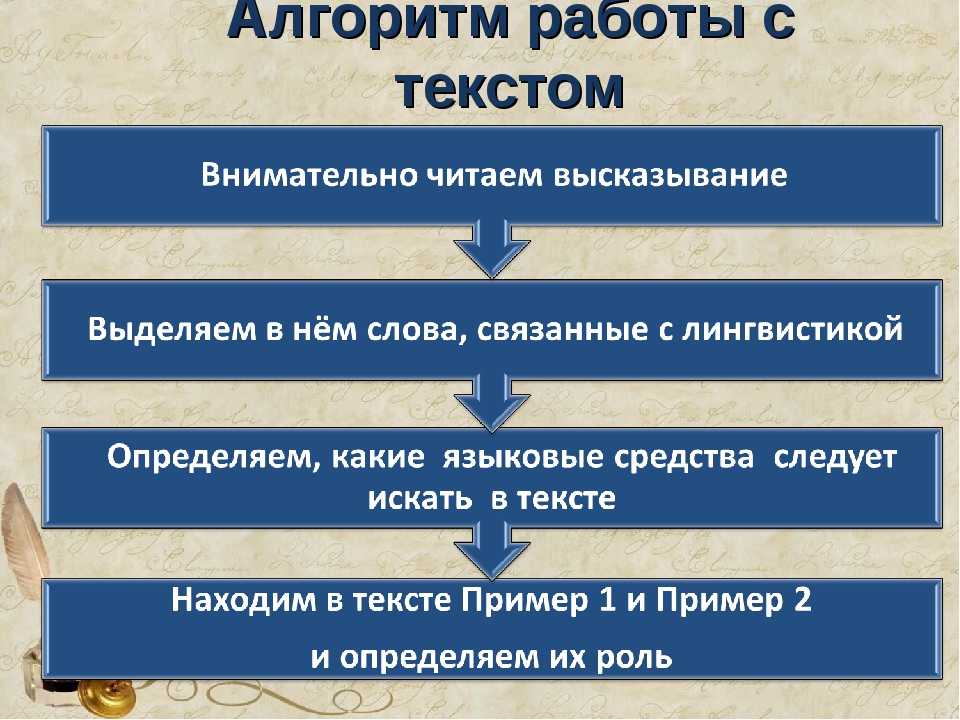

Алгоритм работы над текстом

Сегодня прошло дополнительное занятие трёхдневного курса. На этом занятии я дал те темы, которые мы не успели охватить 2, 3 и 4 марта.

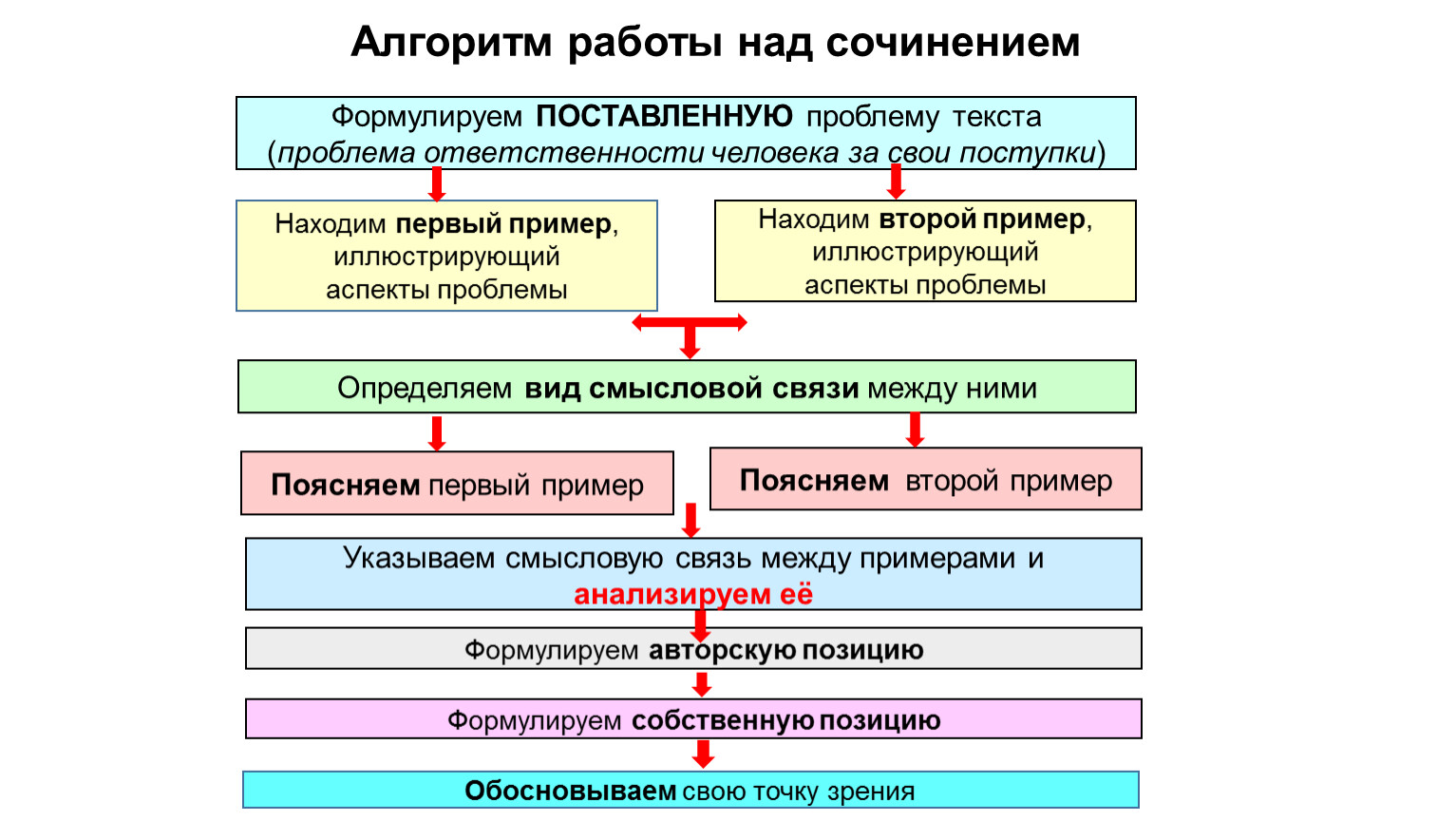

Последняя тема — алгоритм работы над текстом. Она резюмирует основные темы, которые мы проработали, и выстраивает их в систему. Что-то вроде шпаргалки по всему курсу.

Алгоритм новой статьи, рекламы, новости, рассылки, подсказки и заметки

Понять, нужно ли писать вообще

Может, это одна из ситуаций, когда писать не нужно?

Текст работает не всегда. Извиняться за большой промах или выяснять отношения лучше лично.

Изучить предмет под микроскопом

Иногда идея рождается из деталей и тонкостей, на которые никто никогда не смотрел.

Определить контекст

Как читатель столкнется с нашим текстом? Зачем его читать? Что читатель делал, когда вы его отвлекли? Где появился ваш текст?

Занять позицию

Где мы в мире клиента? Чем мы поможем? Можем ли помочь вообще?

Придумать большую идею

Что изменится в голове читателя? Что он поймет из того, чего не знал раньше?

Если это реклама — придумать позиционирование. Что продаем? Как мы это опишем?

Что продаем? Как мы это опишем?

Придумать годный заголовок

Если нужно — еще и подзаголовок. Убедиться, что заголовок подходит ситуации.

Составить примерный план. Отложить его и написать все, что есть в голове

Выложить на лист все «мясо», без ограничений. Сосредоточиться на том, чтобы за час выложить все свои знания по предмету. Пока что не редактировать.

Структурировать

Определить лучший вариант структуры, в зависимости от специфики текста. Это аргументация сложной идеи, история, описание ситуации? Какая здесь нужна структура?

Разложить «мясо» по полочкам. Определить, на каких полочках не хватает «мяса». Исследовать и дописать недостающее.

Жестко отредактировать

— Убрать все не по теме

— Вытравить кислотой заискивание, фальшь, ложь

— Отжать: стоп-слова, слабые глаголы, отглагольные существительные и остальную шелуху

— Насытить потерянные на отжиме моменты. Добавить фактов и цифр

— Исправить синтаксис: выправить абзацы по «правилу капрала», сбалансировать длину предложений и абзацев, добиться контраста, выверить порядок слов

— Отжать еще

— Отложить

— Отжать

— Повторить

Оформить

— Абзацы

— Поля и «воздух»

— Подзаголовки

— Буллиты через тире

— Многоколонники, врезки, цитаты

— Фактоиды

— Кодирование цветом

Полюбоваться

Дать тексту полежать без вашего участия. Спросить мнения коллег. Потестировать.

Спросить мнения коллег. Потестировать.

Отжать

Алгоритм чтения текста сюжетной арифметической задачи Текст научной статьи по специальности «Языкознание и литературоведение»

УДК 373.33:[372.881.161.1+372.851]

Алгоритм чтения текста сюжетной арифметической задачи

М. В. Басалаева

В статье предлагается эффективный для учащихся начальной школы алгоритм чтения текстовой арифметической задачи. Дано описание этапов чтения, составляющих алгоритм действий учащихся. Традиционно выделяемые виды чтения рассматриваются автором методики как части единого процесса, как последовательные этапы деятельности учащихся. На примерах показаны основные принципы работы с алгоритмом.

Ключевые слова: алгоритм чтения текстовой арифметической задачи; понимание учебного текста; интерпретация текста; этапы чтения текста.

Обучение решению задач является одной из центральных проблем для учителя начальной школы. Существует большое количество различных методик для работы над сюжетной арифметической задачей, но все они имеют один общий этап — семантический анализ текста, который представляет наибольшую сложность для детей. По мнению учителей, текст сюжетной задачи сложен для понимания: дети не могут решить задачу, как правило, потому, что не понимают прочитанный текст.

Тексты сюжетных задач были проанализированы нами с нескольких позиций: длина предложения; наличие синтаксических конструкций, сложных для понимания; структурные особенности текста и т. д. Исходя из результатов анализа, мы поставили перед собой задачу по-

иска ответа на вопрос о том, как учащимся начальной школы следует читать «трудный» текст, чтобы он стал понятен.

В разработке алгоритма чтения арифметической задачи мы учитывали традиционно выделяемые в зависимости от целевой установки виды чтения, которые называет, например, С. И. Львова. Применительно ко всей совокупности существующих текстов, без специального внимания к таким специфическим текстам, как тексты арифметических задач, различают 4 вида чтения: просмотровое, ознакомительное, изучающее и поисковое. Просмотровое чтение позволяет определить в общих чертах, о чем данный текст. Ознакомительное чтение направлено на извлечение основной информации: необходимо понять не только о чем текст, но и что именно говорится по тому или иному вопросу. Изучающее чтение — полное, точное и адекватное понимание всей содержащейся в тексте информации и критическое осмысление ее. Целью поискового чтения является нахождение в тексте конкретных данных [2, с. 204]. Эту концепцию мы взяли за основу при разработке эффективных методов работы над текстом арифметической задачи на уроке.

И. Львова. Применительно ко всей совокупности существующих текстов, без специального внимания к таким специфическим текстам, как тексты арифметических задач, различают 4 вида чтения: просмотровое, ознакомительное, изучающее и поисковое. Просмотровое чтение позволяет определить в общих чертах, о чем данный текст. Ознакомительное чтение направлено на извлечение основной информации: необходимо понять не только о чем текст, но и что именно говорится по тому или иному вопросу. Изучающее чтение — полное, точное и адекватное понимание всей содержащейся в тексте информации и критическое осмысление ее. Целью поискового чтения является нахождение в тексте конкретных данных [2, с. 204]. Эту концепцию мы взяли за основу при разработке эффективных методов работы над текстом арифметической задачи на уроке.

Текст любой арифметической задачи представляет собой «информационный клубок». В нем чаще всего сведения об объектах, связанных между собой по смыслу, находятся далеко друг от друга, а о несвязанных — близко. В одной из диагностических работ несколько учащихся, оценивая сложность текста арифметической задачи, отметили: «Текст сильно накручен, чтобы понять, надо долго распутывать». Практика работы на уроке показывает, что для адекватного понимания содержания текста арифметической задачи необходимо читать ее несколько раз.

В одной из диагностических работ несколько учащихся, оценивая сложность текста арифметической задачи, отметили: «Текст сильно накручен, чтобы понять, надо долго распутывать». Практика работы на уроке показывает, что для адекватного понимания содержания текста арифметической задачи необходимо читать ее несколько раз.

В связи с этим известные виды чтения будут рассматриваться нами как части единого процесса, как последовательные этапы деятельности учащихся, в то время как традиционно каждый из видов чтения

описывается изолированно от других, в противопоставлении другим, вне связи с ними.

Рассмотрим подробнее, в чем заключаются цели и результат каждого этапа чтения. Предварительно подчеркнем, что цель чтения на каждом этапе определяется, обсуждается учителем и учащимися до чтения.

1 этап — просмотровое чтение. Это первое чтение текста арифметической задачи. В связи с тем, что младшие школьники еще не являются опытными читателями, рекомендуем читать текст два раза подряд. Цель этого этапа чтения обозначается до чтения и заключается в том, чтобы определить в общих чертах, о чем текст. Учащимся можно обозначить эту цель с помощью таких вопросов: «Прочитайте текст задачи и скажите, где происходят события, описанные в задаче? Куда мы попадаем вместе с героями задачи?». Например: «Мы на складе, где конфеты раскладывают по пакетам» или «Мы на длинной улице, которую будут асфальтировать» и т. д. Если учащиеся смогли правильно сформулировать ответ на такие вопросы, можно переходить ко второму этапу.

Это первое чтение текста арифметической задачи. В связи с тем, что младшие школьники еще не являются опытными читателями, рекомендуем читать текст два раза подряд. Цель этого этапа чтения обозначается до чтения и заключается в том, чтобы определить в общих чертах, о чем текст. Учащимся можно обозначить эту цель с помощью таких вопросов: «Прочитайте текст задачи и скажите, где происходят события, описанные в задаче? Куда мы попадаем вместе с героями задачи?». Например: «Мы на складе, где конфеты раскладывают по пакетам» или «Мы на длинной улице, которую будут асфальтировать» и т. д. Если учащиеся смогли правильно сформулировать ответ на такие вопросы, можно переходить ко второму этапу.

2 этап — ознакомительное чтение. Главная цель этого этапа определить и назвать все субъекты (о ком / чем говорится в тексте задачи) и предикаты (что о них говорится). Если субъекты обозначены одушевленными существительными, то цель можно задать с помощью таких вопросов: «Прочитай внимательно текст и ответь на вопрос, кто является героем (героями) этого текста и какие события с ним происходят?» Если речь идет о неодушевленных предметах, то вопрос нужно формулировать с учетом этого. Отметим, что в ходе экспериментальной работы учащиеся называли героями и неодушевленные предметы: карандаши, которые раскладывают по коробкам; грузовики, которые развозят товар и т. д. Этот этап чтения можно завершить записью полученных выводов на доске в любом удобном для понимания виде.

Отметим, что в ходе экспериментальной работы учащиеся называли героями и неодушевленные предметы: карандаши, которые раскладывают по коробкам; грузовики, которые развозят товар и т. д. Этот этап чтения можно завершить записью полученных выводов на доске в любом удобном для понимания виде.

При этом следует учитывать пожелания, соображения детей. Иногда учащиеся предлагали нам выписать эту информацию в виде таблицы, так как было несколько субъектов, иногда в виде цепочки, когда субъект был один, а предикатов несколько. После этого можно переходить к следующему этапу.

3 этап — изучающее или выборочное чтение. Это один из ключевых этапов понимания текста. Именно при выборочном чтении «клубок информации» должен быть распутан. Целью прочтения текста задачи в этом случае является нахождение всех связей между субъектами, объектами. Путь к этой цели лежит через поиск различных средств связи между предложениями в тексте. Ср., например, использование родовидовых пар, когда в тексте говорится о стульях, столах, диванах, а в вопросе содержится слово мебель. Эту связь должны обнаружить учащиеся. Для того чтобы дать импульс к такому поиску, можно предложить детям вопрос о том, какие субъекты связаны между собой в этом тексте и как они связаны. После успешного прохождения этапа на доске можно отметить найденные связи. По окончании этой работы должно прийти понимание текста.

Ср., например, использование родовидовых пар, когда в тексте говорится о стульях, столах, диванах, а в вопросе содержится слово мебель. Эту связь должны обнаружить учащиеся. Для того чтобы дать импульс к такому поиску, можно предложить детям вопрос о том, какие субъекты связаны между собой в этом тексте и как они связаны. После успешного прохождения этапа на доске можно отметить найденные связи. По окончании этой работы должно прийти понимание текста.

4 этап — работа с прочитанным текстом. Это заключительный этап, на котором то, что понятно, будет выражено, как говорил А. А. Леонтьев, иначе. Цель этого этапа — создание собственной интерпретации исходного текста. Используя имеющиеся на доске записи, учащиеся описывают сами ту ситуацию, которая фигурирует в задаче — создают новый собственный текст. Цель можно сформулировать, например, так: «Теперь мы разобрались в событиях, которые описаны в задаче. Давайте расскажем эту историю сами так, чтобы события в ней описывались по порядку, а то, что раньше было спрятано, стало бы понятно». Интерпретацией исходного текста может быть пересказ, минитекст, концепт или любой другой вторичный текст. Важно, чтобы он был понятнее исходного. События в нем происходили последователь-

Интерпретацией исходного текста может быть пересказ, минитекст, концепт или любой другой вторичный текст. Важно, чтобы он был понятнее исходного. События в нем происходили последователь-

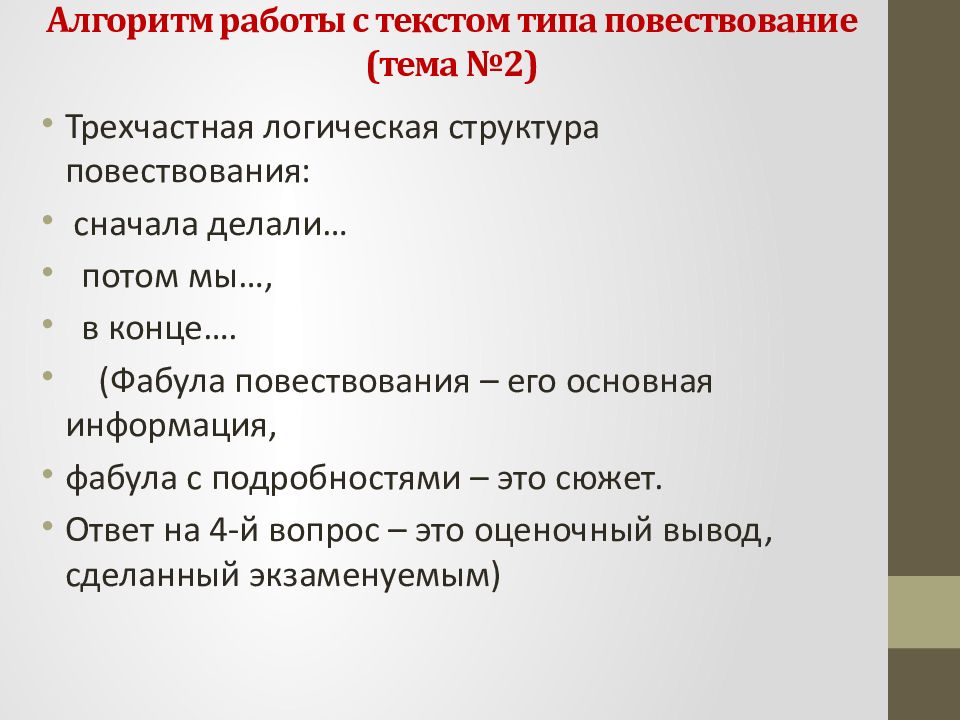

но, связанные между собой субъекты находились рядом, текст имел бы привычную трехчастную структуру. Отметим, что получившаяся интерпретация, скорее всего, будет длиннее исходного текста. Варианты интерпретаций можно писать на доске для сравнения с оригиналом. В процессе экспериментальной работы мы анализировали разные варианты интерпретаций одного текста и обсуждали с детьми их особенности. Важно, чтобы в результате обсуждения учащиеся поняли, что интерпретацию нельзя расценивать как текст, превосходящий по качеству исходный текст задачи. Новый текст просто другой, он более понятен, но это не значит, что исходный текст плохой. Он сложный, в нем «спрятана» информация, однако именно такие тексты помогают развивать речь и мышление.

Приведем описание работы с алгоритмом на примере конкретного текста: «Улицу длиной 672 м и шириной 13 м покрыли асфальтом, расходуя на каждый квадратный метр 39 кг асфальта. Сколько асфальта потребовалось?» [1, с. 58].

Сколько асфальта потребовалось?» [1, с. 58].

1 этап. Определение предмета речи. Учащиеся должны представить общую картину описанного в тексте события. Результат может быть сформулирован так: «Этот текст о том, как улицу покрывали асфальтом» или «Мы на улице, которую будут покрывать асфальтом».

2 этап. Нахождение всех субъектов и предикатов. На доске выписываем все информационные единицы, которые найдем в тексте задачи. Получается приблизительно следующая запись:

• улицу асфальтировали;

• длина улицы 672 метра;

• ширина улицы 13 метров;

• на каждый квадратный метр укладывали 39 кг асфальта.

3 этап. Установление связей между записанными на доске данными. Учащиеся должны провести связи между длиной улицы, ее шириной и информацией о «39 кг на квадратный метр асфальта». Обнаружива-

Учащиеся должны провести связи между длиной улицы, ее шириной и информацией о «39 кг на квадратный метр асфальта». Обнаружива-

ем «неявную информацию»: квадратные метры могут быть связаны с длиной и шириной через понятие площади: у улицы есть некоторая площадь, на которую укладывали асфальт. В тексте об этом понятии не упоминается — эта информация «скрыта».

4 этап. Интерпретация текста. Один из вариантов интерпретации может быть таким: «Улицу покрывали асфальтом. Длина улицы 672 метра, а ширина 13 метров. Всю площадь улицы покрывали асфальтом. На каждый квадратный метр площади укладывали 39 кг асфальта. Сколько всего кг асфальта понадобилось?» Предложения, выделенного курсивом, может не быть. Важно, что в данной интерпретации обозначена связь, которая была скрыта в исходном тексте.

В заключение отметим, что, прежде чем использовать алгоритм, необходимо объяснить учащимся, почему именно так следует читать текст арифметической задачи, убедить их в том, что это действительно необходимо. Такой шаг полезен для того, чтобы сформировать у детей серьезный настрой на работу над текстом задачи. На основе предложенного алгоритма в ходе его практической реализации можно разработать совместно с учащимися памятку, о том, как читать текст арифметической задачи. Например, в процессе экспериментальной работы учащиеся разработали такой вариант памятки:

Такой шаг полезен для того, чтобы сформировать у детей серьезный настрой на работу над текстом задачи. На основе предложенного алгоритма в ходе его практической реализации можно разработать совместно с учащимися памятку, о том, как читать текст арифметической задачи. Например, в процессе экспериментальной работы учащиеся разработали такой вариант памятки:

Как я читаю текст задачи

1. Я читаю текст два раза. Отвечаю коротко на вопрос, о чем этот текст.

2. Читаю еще раз. Нахожу всю информацию, которая есть в задаче. Выписываю или запоминаю.

3. Определяю, как связана между собой эта информация. Ищу доказательства в тексте.

4. Рассказываю текст по-своему снова так, чтобы он был последовательным и понятным.

Учащиеся под руководством учителя работали с помощью этого алгоритма над пониманием текстов арифметических задач на уроках русского языка. Школьники знали, что цель этой работы — точно понять текст, а не решить задачу. Однако многие отмечали: если текст понятен, то решить будет нетрудно. Применяя алгоритм, мы не ставили цель решить задачу. Наша цель состояла в том, чтобы школьники освоили прием «активного понимания» — понимания, которое происходит не само по себе при чтении, а в результате определенных действий. Работа с текстом, построенная таким образом, является одним из способов развития речи учащихся.

Литература

1. Рудницкая В. Н. Математика : учебник для учащихся 4 класса общеобразовательных учреждений / В. Н. Рудницкая, Т. В. Юдачева. — Москва : Вентана-Граф, 2005. — 160 с.

2. Львова С. И. Русский язык : сборник заданий : 9 класс / С. И. Львова. — Москва : Эксмо, 2009. — 304 с.

Львова С. И. Русский язык : сборник заданий : 9 класс / С. И. Львова. — Москва : Эксмо, 2009. — 304 с.

© Басалаева М. В., 2012

Algorithm for Reading Texts of Word Arithmetic Problems

M. Basalaeva

The article offers an algorithm for reading the text of a word arithmetic problem which is effective for elementary school pupils. The author describes all stages of reading that constitute the algorithm of pupils’ actions. The algorithm inventor considers the traditionally distinguished kinds of reading as parts of one process, as successive stages of pupils’ activity. Basic principles of work with the algorithm are shown by examples.

Key words: algorithm for reading a word arithmetic problem; academic text understanding; text interpretation; stages of text reading.

Басалаева Мария Владиславовна, аспирант, кафедра русского языка и методики преподавания, Красноярский государственный педагогический университет им. В. П. Астафьева (Красноярск), [email protected].

Basalaeva, M., post-graduate student, Department of Russian Language and Teaching Methods, Krasnoyarsk State Pedagogical University named after V P. Astafiev (Krasnoyarsk), m.basalaeva @ mail.ru.

Зачем нужны интегральный и дифференциальный алгоритмы чтения

Автор: Иpинa Oлeгoвнa Tюpинa, кандидат социологических наук, вeдущий научный сотpyдник Института социoлoгии Российской академии наук.

Чтение может быть представлено как следующие друг за другом действия мозга по обработке частей материала, содержащего информацию. Любое начинание требует определенного планирования, а следовательно, имеет алгоритмичную структуру.

В процессе своей деятельности человек соблюдает правила, без которых эта деятельность будет неразумной. Последовательность этих правил представляет собой алгоритм. Поэтому перед тем как приступить к знакомству с текстом, необходимо определить вариант чтения. В результате исследований выделены пять способов чтения:

- Углубленное чтение.

- Собственно быстрое чтение.

- Выборочное чтение.

- Чтение-просмотр.

- Чтение-сканирование.

Углубленное чтение — это такой процесс, когда читатель изучает все тонкости, содержащиеся в тексте, и анализирует их. Углубленное чтение наиболее подходит для изучения какого-либо предмета. Читатель, опираясь на ранее полученную информацию и собственный опыт, перерабатывает текст критически, что дает возможность лучшего понимания замысла автора. Такой вид чтения способствует также более глубокому запоминанию текста, так как у читателя формируются определения более близкими ему языковыми средствами.

Быстрое чтение характеризуется тем, что при достаточном уровне владения этим методом, оно обладает всеми достоинствами углубленного чтения при большой скорости обработки информации.

Выборочное чтение является вариантом быстрого чтения. Оно подразумевает чтение фрагментов текста, которые представляют непосредственную ценность для читателя. Он видит весь текст, но пропускает те места, которые либо были изучены ранее, либо не несут полезной на данный момент информации. Такое чтение по скорости превосходит быстрое, так как углубленно изучаются только отдельные части текста. Выборочное чтение уместно при повторном изучении материала.

Чтение-просмотр полезно при определении ценности текста. Читатель должен получить представление о содержании в сжатые сроки.

Сканирование представляет собой вид чтения-просмотра. Объем информации, извлекаемой при таком чтении, крайне невелик. Это может быть отдельное слово, дата или цифра.

Таким образом, эффективным и быстрым чтение становится в том случае, когда все его виды используются читателем в рациональном сочетании. Поэтому нельзя отождествлять быстрое чтение с выборочным, что часто ошибочно делается неопытными читателями.

Поэтому нельзя отождествлять быстрое чтение с выборочным, что часто ошибочно делается неопытными читателями.

Интегральным этот алгоритм назван потому, что он применяется ко всему тексту. Текст является продуктом мыслительной деятельности человека. Чтение означает процесс общения автора и читателя. При этом действуют законы языка, на котором создан текст, и у читателя начинают действовать психические процессы по распознаванию языковой системы.

Такие действия требуют определенной организации. Интегральный алгоритм помогает решить эту задачу. Он является единым способом усвоения информации.

Блок-схема интегрального алгоритма чтения выглядит так:

- Наименование (книги, статьи).

- Автор.

- Источник и его данные (год, №).

- Основное содержание, тема.

- Фактографические данные.

- Особенности излагаемого материала, которые кажутся спорными, критика.

- Новизна излагаемого материала и возможности его использования в практической работе.

Интегральный алгоритм чтения — это последовательные блоки, помогающие выстроить процесс чтения с максимальной эффективностью.

Сведения, содержащиеся в первых четырех блоках, не требуют комментариев. Пятый блок состоит из фактографических данных в письменном виде, фактов, распознавание их в тексте и понимание.

Шестой и седьмой блоки содержат понятия «спорные материалы, их критическое осмысление», «новая информация». В процессе чтения использование этих блоков подразумевает наличие у читателя определенной базы знаний. Читатели могут иметь разную степень подготовки и предварительный опыт. Более подготовленному человеку излагаемый материал может показаться лишним, так как он ему уже хорошо известен. Обладающий же глубокими знаниями в данной области читатель может и не согласиться с автором.

Таким образом, по мере усложнения обрабатываемых по рекомендациям блоков информации включаются дополнительные возможности головного мозга по ее осмыслению, и в этом состоит творческий процесс чтения.

Блоки интегрального алгоритма помогают организовать память в виде специальных отделов, в которые поступает на хранение информация после ее анализа на соответствие тому или иному блоку. Творчески подходя к освоению навыков быстрого чтения, читатель и сам может создать модель интегрального алгоритма в виде изображения.

Чтобы применять эту модель на практике, необходимо соблюдать некоторые правила. Перед тем как погрузиться в изучение текста, нужно вызвать в памяти блоки алгоритма. Этим действием программируется автоматическая способность использования алгоритма в процессе чтения.

Первые три блока схемы алгоритма воспроизводятся памятью без особых усилий, поскольку они наименее информативны. Дальнейшее знакомство с текстом может принести информацию, которая по результатам осмысления отправится в четвертый блок. Такие данные могут содержаться, например, в предисловии книги. Конкретные сведения (имена, даты, результаты статистических исследований) составят фактографический материал пятого блока.

При чтении большое значение имеет способность критически воспринимать изложенные автором соображения. Такая информация является содержанием шестого блока. Неизвестные ранее читателю сведения, которые воспринимаются им как необходимые для своей деятельности, отправляются в седьмой блок.

После прочтения всего текста вновь нужно обратиться к мысленному воспроизведению рисунка схемы интегрального алгоритма. Это прием своеобразного повторения пройденного материала. Происходит более глубокое понимание смысла текста и более стойкое отражение в памяти.

При традиционном чтении несистемная обработка текста приводит к неполному его пониманию: читатель вновь вынужден обращаться к ранее прочитанным фрагментам. Следование алгоритму активизирует мышление и способствует восприятию текста после первого прочтения. Применение метода интегрального алгоритма чтения способствует, таким образом, повышению скорости освоения текста в несколько раз.

Быстрый метод чтения подразумевает не только скорость изучения текста, но и полное понимание прочитанного. Необходимые в этом навыки приобретаются упражнениями, разработанными с помощью дифференциального алгоритма чтения.

Необходимые в этом навыки приобретаются упражнениями, разработанными с помощью дифференциального алгоритма чтения.

Интегральный алгоритм применяется ко всему тексту. Но для каждого фрагмента текста такой метод слишком громоздок, и потребуется слишком много времени, чтобы разработать свой алгоритм для каждой части.

Дифференциальный алгоритм решает эту задачу. Он представляет собой следующую парадигму:

выделение ключевых слов — выявление смысловых рядов — выявление цепи значений.

То есть его функция — разделение (дифференциация) текста на элементы.

Дифференциальный алгоритм имеет структуру, подобную структуре интегрального, но применяемую к значительно меньшему объему текста.

Применять его на практике можно следующим образом. Вначале внимание концентрируется на той части текста, которая представляется законченной по смыслу. В этом случае отмеченная часть может содержать в себе несколько абзацев. Затем происходит заполнение первого блока дифференциального алгоритма путем определения ключевых слов.

Выделенная лексическая единица описывает какой-либо предмет или явление, его характерные признаки. Служебные части речи не могут быть ключевыми словами. Также и местоимения употребляются только для обозначения уже выделенных в предыдущем тексте ключевых слов.

Выявленные ключевые слова помогают составить содержание второго блока, определяя смысловые ряды. Это такие ряды, которые образуются связанными друг с другом ключевыми словами и некоторыми второстепенными. Эти ряды являются золотым ядром печатного материала. В свою очередь, они делятся на именные, предикативные и фактографические.

Именные ряды несут номинативную функцию, то есть называют явление или объект. Вообще, смысловой ряд представляет собой сочетание двух слов. Примером именного ряда может служить сочетание «современный компьютер». Это сочетание может быть выделено из более сложной синтаксической единицы — «компьютер, обладающий в данное время наивысшими возможностями в скорости обработки информации и выдачи результата». Название описанному объекту дает вышеприведенный именной ряд.

Название описанному объекту дает вышеприведенный именной ряд.

Весь лексический материал текста преобразуется в смысловое ядро, занимающее гораздо меньший объем и, соответственно, требующий меньше времени для понимания.

Перед читателем стоит задача уяснить разницу между двумя вариантами сжатия текста. В одном случае в памяти фиксируются смысловые ряды в неизменной форме, в другом те же ряды представляют собой сочетания слов в нескольких синонимичных вариантах.

Таким образом, подготавливается основа не только для сжатия текста путем сокращения количества слов, но и для понимания прочитанного на качественно новом уровне. На этой стадии происходит заполнение третьего блока дифференциального алгоритма. Мыслительный процесс направлен на то, чтобы преобразовать полученную информацию в авторском изложении в свою привычную систему выделения значений слов.

Освоение метода дифференциального алгоритма подобно упражнениям с интегральным алгоритмом. Вначале в памяти должно быть закреплено содержание блоков и порядок их расположения друг за другом.

Затем нужно подобрать две страницы текста научно-популярного жанра и приступить к неторопливому чтению, отмечая части по алгоритму. Выделенные связанные значения образуют фрагменты текста, которые несут основной смысл, заложенный в него автором. Это то, что называется доминантой. Доминанта перекодируется читателем в привычную ему систему языковых единиц.

Таким образом, достигается конечная цель изучения текста в полном масштабе.

Научитесь наконец-то быстро читать изучив курс «Техники скорочтения»:

Техники скорочтения: практический интерактивный мультимедийный дистанционный курс

Алгоритм работы с текстом (составление плана

Просмотр содержимого документа

«Алгоритм работы с текстом (составление плана — конспекта)»

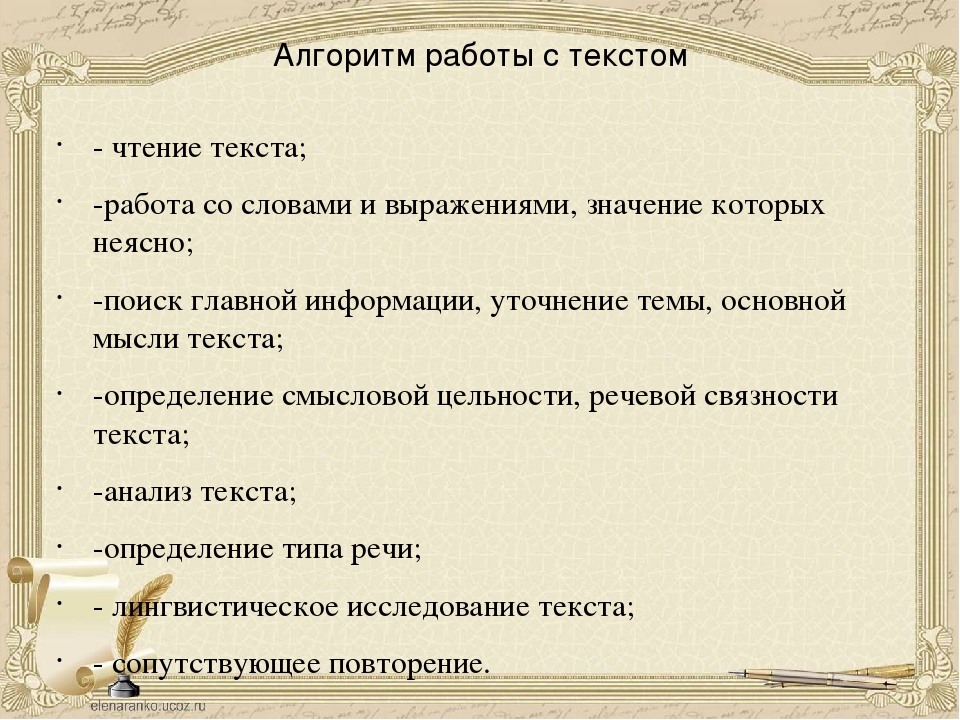

Составление плана — конспекта.

КОНСПЕКТ – это краткая запись содержания текста (устного или письменного)

ВИДЫ КОНСПЕКТОВ: план – конспект, цитатный, свободный, тематический, конспект – кластер (появился сравнительно недавно).

ОСНОВНЫЕ ТРЕБОВАНИЯ К КОНСПЕКТУ: логичность изложения материала, краткость, убедительность.

Тема – это то, о чём говорится в тексте.

Предмет речи – это то, что говорится об этом о чём.

Основная мысль – это то, что автор хочет сказать нам.

Например:

№ п/п | Тема (может быть одна) | Предмет речи (конкретизирует высказывание) | Основная мысль (как правило, выражает отношение автора к изображаемому, говорит о том, что тревожит автора и т.д.) |

Урок | Урок русского языка | Урок русского языка формирует навыки грамотного письма. | |

Урок | Урок литературы | Урок литературы формирует навыки связной речи. | |

Урок | Урок жизни | Урок жизни – это продолжительный и очень интересный урок. |

ПЛАН — КОНСПЕКТ – это сжатый пересказ прочитанного или услышанного в форме плана

ОСНОВНЫЕ ТРЕБОВАНИЯ К ПЛАНУ — КОНСПЕКТУ: логичность изложения материала, краткость, изложение только основных фактов, событий, мыслей и т.д., важных для понимания основной мысли.

ЭТАПЫ КОНСПЕКТИРОВАНИЯ:

1.Прочитайте текст, выписывая слова с непонятным для себя лексическим значением и неизвестные имена и даты.

2.Обращаясь к словарю и/или сети ИНТЕРНЕТ, найдите информацию о неизвестных людях и датах, найдите и дайте объяснение выписанным словам,

3.Прочитайте текст по абзацам, выделив тему, предмет речи и основную мысль.

4.Составьте план или воспользуйтесь готовым.

5.Разъсните кратко каждый пункт плана

6.Сформулируйте и запишите вывод

7.Прочитайте конспект ещё раз и проверьте, все ли части конспекта объединены одной темой, понятен ли вам ход рассуждения. Если да, то вы молодец, если нет – начните сначала!

Алгоритм письменного перевода

Как научиться переводить: алгоритм письменного перевода с английского на русский язык

Перевод текста с английского языка на русский, — на первый взгляд, простая задача. Во многих случаях для понимания сути текста, конечно, достаточно технического перевода — скопировать текст в Google или Yandex переводчик. Однако для полноценного перевода текста на неадаптированном английском, например, этого далеко недостаточно. В настоящем полноценном переводе нужно передать не только смысл, содержание текста, но и воспроизвести его особенности — тип, стиль, передать авторские метафоры, иронию и тому подобное.

Для того, чтобы научиться правильно переводить, рассмотрим алгоритм письменного перевода текста с английского на русский язык. Весь процесс перевода можно условно разделить на два этапа: осмысление и воспроизведение текста. Каким бы странным это не казалось, но сначала нужно поработать с текстом без словарей или онлайн переводчиков (или с их минимальным использованием).

The slovenliness of our language makes it easier for us to have foolish thoughts / George Orwell /

И только после этого приступать непосредственно к переводу.

Неряшливость нашего языка способствует появлению у нас глупых мыслей (Дж. Оруэлл)

Итак, обо всем подробнее.

Минимальные этапы перевода — план:

1. Осмысление текста.

Первое прочтение — знакомые слова — тема — стиль — тип.

Второе прочтение — образ текста

2. Воспроизведение текста.

Перевод — слово — предложение — абзац.

И третье прочтение.

ОСМЫСЛЕНИЕ ТЕКСТА

Первое прочтение. Специалисты в области перевода советуют: «Не думайте о том, что вы читаете на другом языке, постарайтесь абстрагироваться и просто понять смысл текста».

При этом опирайтесь на знакомые слова. Не спешите говорить, что не очень хорошо знаете английский. Даже те, кто никогда не сталкивался с английской речью, знают несколько сотен английских слов. Да, это правда. Это слова, которые пришли в русский из английского, например, бизнес, менеджер, мерчендайзер и интернациональные слова, которые пришли и в английский и в русский из латинского, греческого или французского языков, например, алгебра, география, музей, радио.

Также вы можете проверить свой словарный запас на специальных сайтах.

Знакомые слова свяжите в общую тему. Это облегчит перевод, ограничив словарь до узкого круга слов, например: home, sister, daddy, sweet… — тема текста очевидно «семья». Ограничение всех значений слов и фраз до определенной темы поможет вам на следующих этапах при выборе нужного значения из десятков возможных.

Затем определите тип текста:

повествование (рассказ о каких-либо событиях, действиях во времени),

описание (перечисление признаков или характеристик чего-либо — предмета, явления, места),

рассуждение (главным признаком которого будет доказательство чего-либо, указание причин, убеждение читателя или слушателя).

После этого узнайте стиль текста:

научный (который отличается наличием терминов, подчеркнутой логичностью изложения и отсутствием эмоций),

официально-деловой (в котором также важна информация, отсутствуют эмоции и оценка, но меньшее количество терминов),

публицистический стиль (его цель убеждение читателя, воздействие на него теперь уже всеми средствами — логикой и эмоциональностью),

художественный (где образность, метафоричность выходит на первый план, а логичность и последовательность отодвигаются на второй), и разговорный стиль текста (отличающийся простотой, непринужденностью и эмоциями).

Второе прочтение направлено на формирование мысленного образа текста — того, как все прочитанное на иностранном языке, можно сказать на своем. То есть знакомые слова связанные с темой, стилем и типом текста формируют его образ.

ВОСПРОИЗВЕДЕНИЕ ТЕКСТА

Далее переходим к воспроизведению текста — изложению того образа текста на английском, который сложился в нашем мозгу, на русский язык.

Перевод — слово. Найдите в словарях эквиваленты незнакомых слов или сочетаний, основываясь на сложившемся образе текста. самыми удобными и популярными словарями считаются:

lingvo-online.ru — удобный качественный поиск слов, устойчивые сочетания с ними и конкретные примеры, в которых встречается это слово.

dic.academic.ru, удобство которого в поиске значений по десяткам специализированных словарей, например, научный, экономический, политический и другие.

multitran.ru ценится за то, что варианты переводов редких слов и выражений здесь оставляют профессиональные переводчики, которые с этими словами уже сталкивались в практике. Здесь есть живой форум, где можно найти решения сложных ситуаций перевода.

Для еще более продвинутых переводов можно использовать толковые словари которые расшифровывают, объясняют значение английского слова или выражения более простыми английскими же словами: чаще других я использую urbandictionary.com — многие, в том числе самые свежие, сленговые выражения объясняются именно здесь.

Можно обратить внимание и на dictionary.cambridge.org, thefreedictionary.com.

На выбор значения слов и сочетаний влияют:

1) Контекст.

2) Метафоры, Идиомы.

3) Многозначность.

1) Контекст — окружение переводимого слова или фразы.

Например:

the theory of Einstein — теория Эйнштейна

the theory of Christ — учение Христа.

Одно слово переводится по-разному в разном окружении.

2) Метафоры, Идиомы. Слова и фразы в переносном значении переводятся эквивалентными — в словарях нужно искать целую фразу или пытаться понять тот переносный смысл, который вложил в него автор.

Например: I’ll move heaven and earth to achieve my goal — Я горы сверну за свою цель. Посмотрите: слова сворачивать в оригинале нет совсем, но мы видим, что предложение — «Я буду двигать небеса и землю чтобы достичь своей цели» — звучит не совсем по-русски и ищем то, что как бы выпадает из остального окружения — «буду двигать небеса и землю». Находим, что это идиома, фразеологизм и у нее есть конкретный словарный эквивалент «горы сверну».

3) Многозначность. Здесь нам и пригодится ограничение темы, которое мы сделали ранее на втором этапе, когда составляли мысленный образ текста. Опираясь на этот образ, мы и выбираем из десятков значений самое подходящее.

Например:

Some sort of religious thing? — Из религиозных соображений?

And then he did that odd thing. — И тут он сделал очень странную вещь.

Janey looked around the room for the nearest thing with which to hit her. — Джейни принялась оглядывать комнату в поисках тяжелого предмета.

Кстати, самым многозначным словом в английском является set у которого 127 значений.

Игнорирование этих трех показателей — контекста, переносного смысла и многозначности — можно легко посмотреть. Копируйте текст в онлайн переводчик и получите технический перевод — набор слов, не всегда связанный и часто бессмысленный. Почему? Подробности здесь.

Перевод — предложение. Переходим к следующему этапу и связываем знакомые слова и эквиваленты незнакомых (найденные в словарях только что) в предложения.

При этом помним, что в английском языке фиксированный порядок слов, в русском свободный.

Поэтому при выборе значения слова нужно смотреть на его место в предложении.

В русском: мама мыла раму — раму мыла мама — мыла раму мама.

В английском: mother washed frame, frame washed mother (от перемены порядка слов изменяется смысл).

Особое внимание — на глаголах. Глаголы в английском имеют ряд уникальных особенностей: существуют фразовые глаголы (get after — преследовать, take after — быть похожим и т.д.), которых нет в русском.

В английском 16 времен (простые, длительные, совершённые) — в русском три.

Затем переходим к составлению предложений в абзацы, чтобы выразить более крупную мысль в тексте. То, что не удалось сказать в одном предложении, например, шутку или авторскую метафору, можно перенести в другое место абзаца, сохранив оригинальную идею.

И наконец, третье прочтение — теперь уже своего перевода. Прочитайте получившийся текст, исправьте все ошибки (орфографические, грамматические, пунктуационные). Кроме встроенной в ворд функции проверки текста, существуют онлайн сервисы. Например text.ru.

В получившемся переводе обратите внимание на соответствие: смысла текста, общей тематики, типа, стиля, учтен ли контекст при переводе, правильно ли переданы авторские метафоры и идиомы и выбраны значения многозначных слов.

Очень важно. Перед прочтением получившегося перевода, нужно на время отвлечься от текста. В идеале выпить чашечку кофе или прогуляться. Третье прочтение должно быть «со стороны».

© Обжорин Алексей, 2015

подходы, алгоритмы, рекомендации и перспективы / Хабр

Ежедневно каждый из нас сталкивается с огромным информационным потоком. Нам часто необходимо изучить множество объемных текстов (статей, документов) в ограниченное время. Поэтому в области машинного обучения естественным образом родилась задача автоматического составления аннотации текста.

У нас в компании мы активно работаем над автореферированием документов, в эту статью не стал включать все подробности и код, но описал основные подходы и результаты на примере нейтрального датасета: 30 000 футбольных спортивных новостных статей, собранных с информационного портала «Спорт-Экспресс».

Итак, суммаризацию можно определить, как автоматическое создание краткого содержания (заголовка, резюме, аннотации) исходного текста. Существует 2 существенно отличающихся подхода к этой задаче: экстрактивный и абстрактивный.

Экстрактивная суммаризация

Экстрактивный подход заключается в извлечении из исходного текста наиболее «значимых» информационных блоков. В качестве блока могут выступать отдельные абзацы, предложения или ключевые слова.

Методы данного подхода характеризует наличие оценочной функции важности информационного блока. Ранжируя эти блоки по степени важности и выбирая ранее заданное их число, мы формируем итоговое резюме текста.

Перейдем же к описанию некоторых экстрактивных подходов.

Экстрактивная суммаризация на основе вхождения общих слов

Данный алгоритм очень прост как для понимания, так и дальнейшей реализации. Здесь мы работаем только с исходным текстом, и по большому счету у нас отсутствует потребность в обучении какой-либо модели извлечения. В моем случае извлекаемые информационные блоки будут представлять собой определенные предложения текста.

Итак, на первом шаге разбиваем входной текст на предложения и каждое предложение разбиваем на токены (отдельные слова), проводим для них лемматизацию (приведение слова к «канонической» форме). Этот шаг необходим для того, чтобы алгоритм объединял одинаковые по смыслу слова, но отличающиеся по словоформам.

Затем задаем функцию схожести для каждой пары предложений. Она будет рассчитываться как отношение числа общих слов, встречающихся в обоих предложениях, к их суммарной длине. В результате мы получим коэффициенты схожести для каждой пары предложений.

Предварительно отсеяв предложения, которые не имеют общих слов с другими, построим граф, где вершинами являются сами предложения, ребра между которыми показывают наличие в них общих слов.

Далее ранжируем все предложения по их значимости.

Выбирая несколько предложений с наибольшими коэффициентами и далее сортируя их по номеру появления в тексте, получаем итоговое резюме.

Экстрактивная суммаризация на основе обученных векторных представлений

При построении следующего алгоритма уже использовались ранее собранные данные полных текстов новостей.

Слова во всех текстах разбиваем на токены и объединяем в список. Всего в текстах оказалось 2 270 778 слов, среди которых уникальных — 114 247.

С помощью популярной модели Word2Vec для каждого уникального слова найдем его векторное представление. Модель присваивает каждому слову случайные вектора и далее на каждом шаге обучения, «изучая контекст», корректирует их значения. Размерность вектора, которая способна «запомнить» особенность слова можно задать любую. Исходя из объема имеющегося датасета, будем брать векторы, состоящие из 100 чисел. Также отмечу, что Word2Vec является дообучаемой моделью, что позволяет подать на вход новые данные и на их основе скорректировать уже имеющиеся векторные представления слов.

Для оценки качества модели применим метод понижения размерности T-SNE, который итеративно построит отображение векторов для 1000 самых употребляемых слов в двумерное пространство. Полученный график представляет собой расположение точек, каждая из которых соответствует определенному слову таким образом, что схожие по смыслу слова располагаются близко друг к другу, а различные наоборот. Так в левой части графика располагаются названия футбольных клубов, а точки в левом нижнем углу представляют собой имена и фамилии футболистов и тренеров:

После получения обученных векторных представлений слов можно переходить к самому алгоритму. Как и в предыдущем случае, на входе у нас текст, который мы разбиваем на предложения. Токенизируя каждое предложение, составляем для них векторные представления. Для этого берем отношение суммы векторов для каждого слова в предложении к длине самого предложения. Здесь нам помогают ранее обученные векторы слов. При отсутствии слова в словаре к текущему вектору предложения прибавляется нулевой вектор. Тем самым мы нивелируем влияние появления нового слова, отсутствующего в словаре, на общий вектор предложения.

Далее составляем матрицу схожести предложений, которая использует формулу косинусного сходства для каждой пары предложений.

На последнем этапе на основе матрицы схожести также создаем граф и выполняем ранжирование предложений по значимости. Как и в предыдущем алгоритме, получаем список отсортированных предложений по их значимости в тексте.

В конце изображу схематично и еще раз опишу основные этапы реализации алгоритма (для первого экстрактивного алгоритма последовательность действий абсолютно такая же, за исключением того, что нам не нужно находить векторные представления слов, а функция сходства для каждой пары предложений вычисляется на основе появления в них общих слов):

- Разбиение входного текста на отдельные предложения и их обработка.

- Поиск векторного представления для каждого предложения.

- Вычисление и сохранение в матрице подобия сходства между векторами предложений.

- Преобразование полученной матрицы в граф с предложениями в виде вершин и оценками подобия в виде ребер для вычисления ранга предложений.

- Выбор предложений с наивысшей оценкой для итогового резюме.

Сравнение экстрактивных алгоритмов

С помощью микрофреймворка Flask (инструмент для создания минималистичных веб-приложений) был разработан тестовый веб-сервис для наглядного сравнения результатов вывода экстрактивных моделей на примере множества исходных новостных текстов. Мною проанализировано краткое содержание, генерируемое обеими моделями (извлекалось 2 наиболее значимых предложения) для 100 различных спортивных новостных статей.

По результатам сравнения результатов определения обеими моделями наиболее релевантных предложений могу предложить следующие рекомендации по использованию алгоритмов:

- Первая модель больше подходит для формирования заголовков или различного рода вступлений. На рассмотренных статьях выделялись именно те предложения, которые могли бы привлечь внимание потенциального читателя новости. Поэтому использование данной модели оправдано при формировании заголовка спортивной статьи, блога или иной новости.

- Вторая модель качественнее отражала основную суть полного текста. За счет обученных векторов, которые учитывали похожесть слов даже если они отличаются в написании, этот алгоритм хорошо подходит для формирования аннотации, содержащей основные мысли исходного текста. Обучая модель на других данных, которые связаны с интересующей предметной областью, можно получить качественный результат передачи основного смысла новости, документа или другого текста.

Абстрактивная суммаризация

Абстрактивный подход существенно отличается от своего предшественника и заключается в генерации краткого содержания с порождением нового текста, содержательно обобщающего первичный документ.

Основная идея данного подхода состоит в том, что модель способна генерировать абсолютно уникальное резюме, которое может содержать слова, отсутствующие в исходном тексте. Вывод модели представляет собой некоторый пересказ текста, который более близок к ручному составлению краткого содержания текста людьми.

Этап обучения

Я не буду подробно останавливаться на математических обоснованиях работы алгоритма, все известные мне модели основаны на архитектуре «кодера-декодера», которая в свою очередь построена с помощью рекуррентных слоев LSTM (о принципе работе которых можно почитать здесь). Кратко опишу шаги для декодирования тестовой последовательности.

- Кодируем всю входную последовательность и инициализируем декодер внутренними состояниями кодера

- Передаем токен «start» в качестве входных данных для декодера

- Запускаем декодер с внутренними состояниями кодера на один временной шаг, в результате получаем вероятность следующего слова (слово с максимальной вероятностью)

- Передаем выбранное слово в качестве входных данных для декодера на следующем временном шаге и обновляем внутренние состояния

- Повторяем шаги 3 и 4, пока не сгенерируем токен «end»

Подробно с архитектурой «кодера-декодера» можно ознакомиться здесь.

Реализация абстрактивной суммаризации

Для построения более сложной абстрактивной модели извлечения краткого содержания потребуются как полные тексты новостей, так и их заголовки. В качестве резюме будет выступать именно заголовок новости, так как модель «плохо запоминает» длинные текстовые последовательностями.

При чистке данных используем перевод в нижний регистр и отбрасывание не русскоязычных символов. Лемматизация слов, удаление предлогов, частиц и других неинформативных частей речи окажет отрицательное воздействие на конечный вывод модели, так как потеряется взаимосвязь между словами в предложении.

Далее тексты и их заголовки разбиваем на обучающую и тестовую выборки в отношении 9 к 1, после чего преобразуем их в векторы (случайным образом).

На следующем шаге создаем саму модель, которая будет считывать переданные ей векторы слов и осуществлять их обработку с помощью 3 рекуррентных слоев LSTM кодера и 1 слоя декодера.

После инициализации модели обучаем ее с применением кросс-энтропийной функции потерь, которая показывает расхождения между реальным целевым заголовком и тем, который предсказывает наша модель.

Наконец, выводим результат модели для тренировочного множества. Как можно заметить в примерах, исходные тексты и резюме содержат неточности из-за отбрасывания перед построением модели редко встречающихся слов (отбрасываем для того, чтобы «упростить обучение»).

Вывод модели на данном этапе оставляет желать лучшего. Модель «успешно запоминает» некоторые названия клубов и фамилии футболистов, но сам контекст практически не уловила.

Несмотря на более современный подход к извлечению резюме, пока данный алгоритм сильно уступает созданным ранее экстрактивным моделям. Тем не менее, для того, чтобы улучшить качество модели, можно обучать модель на более объемном датасете, но, на мой взгляд, для получения действительного хорошего вывода модели необходимо изменить или, возможно, полностью сменить саму архитектуру используемых нейросетей.

Так какой же подход лучше?

Подытоживая данную статью, перечислю основные плюсы и минусы рассмотренных подходов извлечения краткого содержания:

1. Экстрактивный подход:

Преимущества:

- Интуитивно понятна суть алгоритма

- Относительная простота реализации

Недостатки:

- Качество содержания во многих случаях может быть хуже, чем написанное вручную человеком

2. Абстрактивный подход:

Преимущества:

- Качественно реализованный алгоритм способен выдать результат наиболее близкий к ручному составлению резюме

Недостатки:

- Сложности при восприятии основных теоретических идей алгоритма

- Большие трудозатраты при реализации алгоритма

Однозначного ответа на вопрос, какой же подход лучше сформирует итоговое резюме, не существует. Всё зависит от конкретной задачи и целей пользователя. К примеру, экстрактивный алгоритм скорее всего лучше подойдет для формирования содержания многостраничных документов, где извлечение релевантных предложений действительно сможет корректно передать идею объемного текста.

На мой взгляд, будущее все-таки за абстрактивными алгоритмами. Несмотря на то, что на данных момент они развиты слабо и на определенном уровне качества вывода могут использоваться только для генерации небольших резюме (1-2 предложения), стоит ждать прорыв именно от нейросетевых методов. В перспективе они способны формировать содержание для абсолютно любых по размеру текстов и, что самое главное, само содержание будет максимально соответствовать ручному составлению резюме экспертом в той или иной области.

Векленко Влад, системный аналитик,

Консорциум «Кодекс»

Алгоритм выполнения заданий ReACT | Учим учиться

Для правильного выполнения заданий информационного тренинга необходимо выстроить последовательность элементарных учебных действий, своего рода алгоритм работы с информационным источниками. Эту когнитивную цепочку мы называем ReACT.

Расшифруем:

Re (read) – читаем

Этот шаг последовательности подразумевает считывание исходной информации с предлагаемого источника. Эта информация может быть представлена в различных форматах. Это может быть в буквальном смысле чтение текста, но мы также можем говорить и о считывании сведений с карты, со схемы, из таблицы, о восприятии информации на слух и т.п. Исходная информация может быть статичной или динамически меняться. В любом случае мы говорим о чтении, понимая этот термин в расширительном его смысле.

A (analyse) – анализируем

Если первая фаза предполагает непосредственное восприятие информации из конкретного источника (с учетом его формата), то второе звено цепочки предполагает соотнесение между собой сведений, которые представлены в этом источнике с формулировкой задания, содержанием вопроса, на который нужно ответить, с другими источниками данных, представленными в других форматах и т.п. Иногда необходимо повторное прочтение формулировки задания (или вопроса), так как после изучения информационного источника (или источников) она может восприниматься в ином или более определенном смысловом контексте.

C (compress) – “сжимаем” информацию, выделяем значимое

Сведения, предлагаемые в информационных источниках, почти всегда избыточны, если рассматривать их с точки зрения выполнения конкретного задания. Важно научиться уменьшать объем исходной информации, “сжимать” ее, выделяя только те данные, которые требуются для выполнения задания (и даже конкретного шага задания). То есть необходимо научиться отбрасывать все несущественное в заданном контексте и работать только с частью исходных данных; это облегчает и ускоряет процесс выполнения задания.

T (transform) – преобразуем (в тот формат, который требуется в задании).

Как правило, в задании требуется преобразовать исходную информацию и дать ответ в какой-то форме, отличной от исходного представления. Например, на основании текста нужно заполнить таблицу. Или на основе данных, представленных на карте, нужно составить корректное высказывание по текстовому шаблону. Эти активные действия, завершающие алгоритм выполнения задания, могут рассматриваться как расширительное толкование письма (письменной речи), то есть тренинг создания собственных информационных объектов.

Таким образом образуется цепочка “чтение” – ”преобразование” – “письмо”, характерная и для компьютерного алгоритма, и для когнитивного процесса.

Давайте попробуем на примере конкретного задания разобраться, как действует данный алгоритм.

В примере ниже мы имеем дело со следующим набором информационных объектов:

– исходная информация задана в формате карты Балтийского моря, на которую нанесено множество текстовых надписей;

– “рабочий” текст – это текст, в котором оставлены пропуски, которые должны быть заполнены на основе исходной информации, представленной в графическом формате (с учетом содержания самого «рабочего» текста).

– формулировка задания, которая акцентирует внимание на том, что пропуски в «рабочем» тексте заполняются не выбором из предложенных вариантов, а вписыванием сведений, представленных на карте.

Особо следует подчеркнуть, что сведения, необходимые для выполнения задания, представлены внутри самого задания; не требуется ничего вспоминать или искать в Интернете.

Re

Чтение карты требует особого умения, так как информация представлена в виде сочетания различных средств: надписей, линий, цветовых пятен и т.д. Кроме того, данная информация не структурирована для удобства визуального просмотра, как, например, таблица. Поэтому для поиска и считывания необходимых сведений с географической карты может потребоваться довольно много времени. Однако, без полноценного ознакомления с исходным информационным ресурсом последующие фазы могут быть непродуктивными и привести к ошибкам.

A

Фаза анализа предполагает изучение информации, представленной в источнике, в контексте решаемой задачи. В данном примере нужно ознакомиться с рабочим текстом и соотнести его содержание с данными карты. Не стоит торопиться выполнять какие-либо действия, даже если они кажутся очевидными. Следует сначала разобраться, на основе какой именно информации, представленной на карте, могут быть заполнены пропуски в тексте. В предлагаемом примере требуется заполнить семь пропусков. Во всех случаях требуется ввести в свободное текстовое поле географическое название города или страны. Для этого необходимо найти соответствующие объекты (город или страну) на карте и аккуратно списать их названия.

C

Во всех заданиях информация, представленная на экране, является избыточной. В фазе компрессии (сжатия) нужно определить, какие данные потребуются для выполнения задания, а какие – нет. Прочитав рабочий текст, можно сделать вывод, что вся информация, необходимая для заполнения пропусков, относится к Финскому заливу и его побережьям. Значит, на карте необходимо найти именно Финский залив, то есть сосредоточить свое внимание только на этой части Балтийского моря. Это позволяет сразу же исключить из рассмотрения значительную часть предлагаемой информации. Можно даже изменить масштаб карты и приблизить к себе нужную часть изображения, чтобы лучше читались требуемые для вписывания названия.

T

Заключительная фаза выполнения задания – представление информации в заданном формате. В задании требуется написать, то есть набрать на клавиатуре соответствующие географические названия. “Написать” в данном случае означает “списать”, так как все города и страны, о которых идет речь, подписаны на карте. Естественно, что компьютерная операция копирования здесь отключена. Нужно именно написать названия, причем сделать это в соответствии с правилами русского языка. Это, казалось бы, несложное действие требует внимания, чтобы не допустить ошибок при списывании.

Когда все пропуски в тексте заполнены, нужно проверить решение, нажав кнопку “Готово”.

Характерные ошибки

Ошибки “чтения” — учащийся неправильно считывает информацию с карты. Например, не понимает, что столицы обозначены на карте специальным символом – звездочкой. Другая возможная ошибка — неумение соотносить расположение городов и границы стран.

Ошибки, связанные с неверным определением сторон света. На карте нет надписей, прямо указывающих направления, карта дана в стандартной ориентации — “север сверху”. Кроме того, в нижнем правом углу предлагается «роза ветров», которая указывает все стороны света. Если учащийся не ориентируется в том, как определить по карте стороны света, это ведет к ошибочным ответам.

Ошибки “списывания” — для многих учащихся процесс написания незнакомых (а порой и знакомых) географических терминов представляет собой трудную задачу. От ошибок может спасти тщательная проверка набранного на клавиатуре слова до нажатия кнопки “Готово”, но сам по себе навык проверки сформирован далеко не у всех учащихся.

Найдите похожие тексты с помощью собственного алгоритма машинного обучения | by Günter Röhrich

4. Алгоритм TF-IDF

Поскольку мы использовали вышеупомянутую функцию для очистки и фильтрации данных, а также для настройки наших счетчиков, мы продолжим реализацию основных функций нашего эксперимента, tf- Алгоритм idf:

TF IDF в основном использует словари

Воспользовавшись нашим алгоритмом tf-idf, мы теперь можем решить рассматривать только ограниченное количество слов, только n слов с наивысшей оценкой, рассчитанной для каждого документа [3].Это n произвольно, чем больше n, тем более разреженной будет наша матрица сходства — имейте это в виду.

Чтобы вычислить сходство, нам нужен опорный вектор. Выполняя итерацию по всем документам, очищая их и подсчитывая слова, мы будем

- вычислить оценки tf_idf, а

- создадим опорный вектор — вектор, состоящий из набора всех релевантных слов (n слов на документ). Естественно, чем больше похожих документов, тем меньше будет наш вектор. Ожидайте, что он будет большим.

5. Вычислить сходство

Что мы сделаем дальше, так это вычислим сходство мешков, где мешок представлен своими n верхними словами. Все главные слова собраны в единый вектор слов. Мы создадим векторы для каждого пакета (итеративный процесс), а на следующем шаге мы сложим все векторы вместе в одну матрицу.

6. Правильное хранение данных

Мы уже проделали значительную работу по обработке и организации данных таким образом, чтобы мы могли значительно приблизиться к нашим заключительным этапам нашего анализа.После сложения наших векторов мы находим разреженную матрицу, которая плотна только вокруг своей диагонали (что имеет смысл, но больше, чем 7. Вычислить сходства ). Давайте сначала проверим здравомыслие.

# для нашей матрицы m

np.where (m.toarray () [0]> 0)

# n верхних значений:

(array ([52, 803, 1151, 1778, 1993], dtype = int64), )

Давайте проверим наши матрицы для Reuters и IMDB (график ограничен 25000 обзорами):

Matrix m , как он выглядит по данным Reuters — широкий из-за огромного количества главных слов Matrix m , как он выглядит по данным IMDB [: 25,000] —плотный

7.Вычислить сходства

Вычислить сходство — увлекательная задача, линейная алгебра предоставляет очень простой способ вычисления подобия: нас интересует косинусный угол между двумя векторами A и B, чем ближе эти две точки к одному направлению, тем ближе их значения к единице:

Косинусное сходство — первое изображение, появившееся в Google;) [5]

На нашем последнем шаге мы умножим наши значения матрицы на все другие значения в матрице (сходство равно 1, если мы умножим вектор с самим собой), мы называем эту матрицу подобия m_d_m .Как мы видим, существует четкая закономерность, в которой мы можем найти очевидные сходства — если бы нам нужно было сопоставить их вместе, это была бы идеальная задача кластеризации.

На следующем рисунке мы проверим данные Reuters по простой причине: данные Reuters — это ежедневные новости. Это означает, что мы, конечно, ожидаем определенных шаблонов сходства, однако новости охватывают множество разных областей, которые, естественно, имеют более широкий набор слов. Если бы мы использовали тот же сюжет для обзоров фильмов, мы бы в основном получили огромный синий квадрат (из-за плотности).

Наша матрица Reuters m_d_m , содержащая ненулевые значения

8. Анализ

В нашей задаче мы стремились найти документ, похожий на тот, который мы выбрали. Мы используем простую итерацию, чтобы найти все связанные документы, которые как минимум на x% похожи, где x снова определяется произвольно. Я пришел к выводу, что сходства вокруг .5 работают неплохо.

Руководство по классификации текста с машинным обучением и NLP

Текст может быть чрезвычайно богатым источником информации, но извлечение из него понимания может быть трудным и трудоемким из-за его неструктурированной природы.

Но благодаря достижениям в области обработки естественного языка и машинного обучения, которые подпадают под обширную область искусственного интеллекта, сортировка текстовых данных становится проще.

Тег настроения и темы в тексте с NLP

Он работает, автоматически анализируя и структурируя текст, быстро и экономично, так что предприятия могут автоматизировать процессы и обнаруживать идеи, которые приводят к более эффективному принятию решений.

Прочтите, чтобы узнать больше о классификации текста, о том, как она работает, и о том, как легко начать работу с инструментами классификации текста без кода, такими как анализатор тональности MonkeyLearn.

- Что такое классификация текста?

- Как работает классификация текста?

- Примеры классификации текста

- Ресурсы

Что такое классификация текста?

Классификация текста — это метод машинного обучения, который назначает набор предопределенных категорий открытому тексту. Текстовые классификаторы можно использовать для организации, структурирования и категоризации практически любого текста — от документов, медицинских исследований и файлов, а также по всему Интернету.

Например, новые статьи могут быть организованы по темам; билеты поддержки могут быть организованы в срочном порядке; чаты могут быть организованы по языку; упоминания бренда могут быть организованы по настроениям; и так далее.

Классификация текста — одна из фундаментальных задач обработки естественного языка с широкими приложениями, такими как анализ тональности, маркировка тем, обнаружение спама и обнаружение намерений.

Вот пример того, как это работает:

«Пользовательский интерфейс довольно прост и удобен.”

Классификатор текста может использовать эту фразу в качестве входных данных, анализировать ее содержимое, а затем автоматически назначать соответствующие теги, такие как UI и Easy To Use .

Почему важна классификация текста?

По оценкам, около 80% всей информации является неструктурированной, причем текст является одним из наиболее распространенных типов неструктурированных данных. Из-за беспорядочного характера текста анализ, понимание, организация и сортировка текстовых данных трудны и требуют много времени, поэтому большинству компаний не удается использовать их в полной мере.

Здесь на помощь приходит классификация текста с помощью машинного обучения. Используя текстовые классификаторы, компании могут автоматически структурировать любой релевантный текст: электронные письма, юридические документы, социальные сети, чат-боты, опросы и т. Д. Быстрым и экономичным способом. . Это позволяет компаниям экономить время на анализе текстовых данных, автоматизировать бизнес-процессы и принимать бизнес-решения на основе данных.

Зачем нужна классификация текста машинного обучения? Некоторые из основных причин:

Ручной анализ и систематизация медленные и гораздо менее точные.. Машинное обучение может автоматически анализировать миллионы опросов, комментариев, электронных писем и т. Д. За небольшую часть стоимости, часто всего за несколько минут. Инструменты классификации текста масштабируются для любых бизнес-потребностей, больших или малых.

Существуют критические ситуации, которые компаниям необходимо выявлять как можно скорее и принимать немедленные меры (например, PR-кризисы в социальных сетях). Классификация текста с помощью машинного обучения может отслеживать упоминания вашего бренда постоянно и в режиме реального времени, поэтому вы сможете определить важную информацию и сразу же принять меры.

Люди-аннотаторы делают ошибки при классификации текстовых данных из-за отвлекающих факторов, усталости и скуки, а человеческая субъективность создает противоречивые критерии. С другой стороны, машинное обучение применяет одни и те же критерии и критерии ко всем данным и результатам. Как только модель классификации текста обучена должным образом, она работает с непревзойденной точностью.

Как работает классификация текста?

Вы можете выполнить классификацию текста двумя способами: вручную или автоматически.

Ручная классификация текста включает человека-комментатора, который интерпретирует содержание текста и соответствующим образом классифицирует его. Этот метод может дать хорошие результаты, но требует много времени и средств.

Автоматическая классификация текста использует машинное обучение, обработку естественного языка (NLP) и другие методы на основе искусственного интеллекта, чтобы автоматически классифицировать текст быстрее, экономичнее и точнее.

В этом руководстве мы сосредоточимся на автоматической классификации текста.

Существует много подходов к автоматической классификации текста, но все они относятся к трем типам систем:

- Системы на основе правил

- Системы на основе машинного обучения

- Гибридные системы

Системы на основе правил

Правило- Основанные на подходе подходы классифицируют текст на организованные группы с использованием набора вручную созданных лингвистических правил. Эти правила предписывают системе использовать семантически релевантные элементы текста для определения релевантных категорий на основе его содержимого.Каждое правило состоит из антецедента или шаблона и прогнозируемой категории.

Предположим, вы хотите разделить новостные статьи на две группы: Спорт и Политика . Во-первых, вам нужно определить два списка слов, которые характеризуют каждую группу (например, слова, относящиеся к спорту, такие как футбол , баскетбол , LeBron James и т. Д., И слова, относящиеся к политике, например Дональд Трамп , Хиллари Клинтон , Путин и т. Д.).

Затем, когда вы хотите классифицировать новый входящий текст, вам нужно будет подсчитать количество слов, связанных со спортом, которые появляются в тексте, и сделать то же самое для слов, связанных с политикой. Если количество слов, связанных со спортом, превышает количество слов, связанных с политикой, тогда текст классифицируется как спорт и наоборот.

Например, эта основанная на правилах система классифицирует заголовок «Когда состоится первая игра Леброна Джеймса с« Лейкерс »?» как Sports , потому что в нем учитывался один термин, связанный со спортом (Леброн Джеймс), и не учитывались термины, связанные с политикой.

Системы, основанные на правилах, понятны человеку и со временем могут быть улучшены. Но у этого подхода есть недостатки. Для начала, эти системы требуют глубокого знания предметной области. Они также отнимают много времени, поскольку создание правил для сложной системы может быть довольно сложной задачей и обычно требует большого анализа и тестирования. Системы, основанные на правилах, также сложно поддерживать, и они плохо масштабируются, учитывая, что добавление новых правил может повлиять на результаты уже существующих правил.

Системы на основе машинного обучения

Вместо того, чтобы полагаться на правила, созданные вручную, классификация текста машинного обучения учится делать классификации на основе прошлых наблюдений.Используя предварительно размеченные примеры в качестве обучающих данных, алгоритмы машинного обучения могут изучать различные ассоциации между частями текста и то, что конкретный результат (то есть теги) ожидается для определенного ввода (то есть текста). «Тег» — это заранее определенная классификация или категория, в которую может попасть любой данный текст.

Первым шагом на пути к обучению классификатора НЛП машинного обучения является извлечение признаков: метод используется для преобразования каждого текста в числовое представление в виде вектора.Один из наиболее часто используемых подходов — это набор слов, где вектор представляет частоту слова в заранее определенном словаре слов.

Например, если мы определили наш словарь, чтобы он содержал следующие слова { This, is, the, not, awesome, bad, Basketball }, и мы хотели векторизовать текст «This is awesome», we будет иметь следующее векторное представление этого текста: (1, 1, 0, 0, 1, 0, 0).

Затем в алгоритм машинного обучения поступают обучающие данные, которые состоят из пар наборов функций (векторов для каждого примера текста) и тегов (например.грамм. спорт , политика ) для создания классификационной модели:

После обучения с использованием достаточного количества обучающих выборок модель машинного обучения может начать делать точные прогнозы. Тот же самый экстрактор признаков используется для преобразования невидимого текста в наборы признаков, которые могут быть введены в модель классификации для получения прогнозов по тегам (например, спорт , политика ):

Классификация текста с помощью машинного обучения обычно намного точнее, чем система правил, созданная человеком, особенно в сложных задачах классификации НЛП.Кроме того, классификаторы с машинным обучением легче поддерживать, и вы всегда можете пометить новые примеры, чтобы изучить новые задачи.

Алгоритмы классификации текста машинного обучения

Некоторые из наиболее популярных алгоритмов классификации текста включают семейство алгоритмов Наивного Байеса, вспомогательные векторные машины (SVM) и глубокое обучение.

Наивный Байес

Семейство статистических алгоритмов Наивного Байеса — одни из наиболее часто используемых алгоритмов классификации и анализа текста в целом.

Одним из членов этого семейства является Multinomial Naive Bayes (MNB) с огромным преимуществом, заключающимся в том, что вы можете получить действительно хорошие результаты, даже когда ваш набор данных не очень велик (~ пара тысяч помеченных образцов) и вычислительные ресурсы дефицитный.

Наивный Байес основан на теореме Байеса, которая помогает нам вычислить условные вероятности возникновения двух событий на основе вероятностей наступления каждого отдельного события. Таким образом, мы вычисляем вероятность каждого тега для данного текста, а затем выводим тег с наибольшей вероятностью.

Вероятность A, если B истинно, равна вероятности B, если A истинно, умноженной на вероятность того, что A истинно, деленная на вероятность того, что B истинно.

Это означает, что любой вектор, представляющий текст, должен содержать информацию о вероятностях появления определенных слов в текстах данной категории, чтобы алгоритм мог вычислить вероятность того, что этот текст принадлежит к категории.

Прочтите это сообщение в блоге, чтобы узнать больше о Наивном Байесе.

Машины опорных векторов

Машины опорных векторов (SVM) — еще один мощный алгоритм машинного обучения классификации текста, потому что, как и наивный Байес, SVM не требует большого количества обучающих данных, чтобы начать предоставлять точные результаты. Однако SVM требует больше вычислительных ресурсов, чем наивный байесовский метод, но результаты еще быстрее и точнее.

Короче говоря, SVM рисует линию или «гиперплоскость», разделяющую пространство на два подпространства. Одно подпространство содержит векторы (теги), которые принадлежат группе, а другое подпространство содержит векторы, которые не принадлежат этой группе.

Оптимальная гиперплоскость — это гиперплоскость с наибольшим расстоянием между тегами. В двух измерениях это выглядит так:

Эти векторы представляют собой ваши учебные тексты, а группа — это тег, которым вы пометили свои тексты.

По мере того, как данные становятся более сложными, может оказаться невозможным классифицировать векторы / теги только по двум категориям. Итак, это выглядит так:

Но что самое замечательное в алгоритмах SVM — они «многомерны.«Таким образом, чем сложнее данные, тем точнее будут результаты. Представьте вышеупомянутое в трех измерениях с добавленной осью Z, чтобы создать круг.

В двух измерениях идеальная гиперплоскость выглядит так:

Глубокое обучение

Глубокое обучение — это набор алгоритмов и методов, основанных на том, как работает человеческий мозг, называемых нейронными сетями. Архитектуры глубокого обучения предлагают огромные преимущества для классификации текста, поскольку они работают со сверхвысокой точностью при проектировании и вычислениях нижнего уровня.

Двумя основными архитектурами глубокого обучения для классификации текста являются сверточные нейронные сети (CNN) и рекуррентные нейронные сети (RNN).

Глубокое обучение — это иерархическое машинное обучение с использованием нескольких алгоритмов в последовательной цепочке событий. Это похоже на то, как человеческий мозг принимает решения, используя одновременно разные методы для обработки огромных объемов данных.

Алгоритмы глубокого обучения требуют гораздо больше обучающих данных, чем традиционные алгоритмы машинного обучения (по крайней мере, миллионы помеченных примеров).Тем не менее, у них нет порога для обучения на основе обучающих данных, так как традиционные алгоритмы машинного обучения, такие как обучающие классификаторы SVM и NBeep, продолжают улучшаться, чем больше данных вы их вводите:

Алгоритмы глубокого обучения, такие как Word2Vec или GloVe, также используются для получения лучшего векторного представления слов и повышения точности классификаторов, обученных с помощью традиционных алгоритмов машинного обучения.

Гибридные системы

Гибридные системы сочетают в себе базовый классификатор, обученный машинному обучению, с системой на основе правил, которая используется для дальнейшего улучшения результатов.Эти гибридные системы можно легко настроить, добавив специальные правила для тех конфликтующих тегов, которые не были правильно смоделированы базовым классификатором.

Метрики и оценка

Перекрестная проверка — это распространенный метод оценки производительности текстового классификатора. Он работает путем разделения набора обучающих данных на случайные наборы примеров равной длины (например, 4 набора с 25% данных). Для каждого набора текстовый классификатор обучается с оставшимися выборками (например, 75% выборок).Затем классификаторы делают прогнозы для своих соответствующих наборов, и результаты сравниваются с тегами, аннотированными людьми. Это позволит определить, когда прогноз был верным (истинные положительные и истинные отрицательные), а когда был ошибочным (ложные срабатывания, ложные отрицания).

С этими результатами вы можете построить метрики производительности, которые полезны для быстрой оценки того, насколько хорошо работает классификатор:

- Точность: процент текстов, которые были отнесены к категории с правильным тегом.

- Точность: процент примеров, которые классификатор получил прямо из общего числа примеров, которые он спрогнозировал для данного тега.

- Напомним: процент примеров, предсказанных классификатором для данного тега, из общего числа примеров, которые он должен был спрогнозировать для данного тега.

- Оценка F1: среднее гармоническое значение точности и отзывчивости.

Почему важна классификация текста?

По оценкам, около 80% всей информации является неструктурированной, причем текст является одним из наиболее распространенных типов неструктурированных данных.Из-за беспорядочного характера текста анализ, понимание, организация и сортировка текстовых данных трудны и требуют много времени, поэтому большинству компаний не удается использовать их в полной мере.

Здесь на помощь приходит классификация текста с помощью машинного обучения. Используя текстовые классификаторы, компании могут автоматически структурировать любой релевантный текст: электронные письма, юридические документы, социальные сети, чат-боты, опросы и т. Д. Быстрым и экономичным способом. . Это позволяет компаниям экономить время на анализе текстовых данных, автоматизировать бизнес-процессы и принимать бизнес-решения на основе данных.

Зачем нужна классификация текста машинного обучения? Некоторые из основных причин:

Анализ и организация вручную медленные и гораздо менее точные. Машинное обучение может автоматически анализировать миллионы опросов, комментариев, электронных писем и т. Д. За небольшую часть стоимости, часто всего за несколько минут. Инструменты классификации текста масштабируются для любых бизнес-потребностей, больших или малых.