Содержание

Мой извилистый путь от охранника до backend-разработчика

24 Июля, 2017,

12:00

6292

Научиться программировать может каждый. Даже испанский охранник, учивший в колледже горное дело. Свою историю пути от охранника к backend-разработчику и основателю локального opensource-сообщества в блоге на Medium рассказал Хосе Мануэль Галлего. Редакция AIN.UA приводит полный перевод его истории.

В детстве мне страшно нравились компьютеры. Но на вступительных экзаменах в колледж я не набрал достаточно баллов, чтобы попасть в IT-сферу. Потому я занялся горным делом.

Но на вступительных экзаменах в колледж я не набрал достаточно баллов, чтобы попасть в IT-сферу. Потому я занялся горным делом.

После особенно плохого семестра, когда завалил несколько предметов, летом я решил подработать охранником. В итоге, подработка стала моей карьерой. Вам не надо обладать особым умом, чтобы работать охранником в Испании. Люди, окружающие вас, начинают испытывать пониженные ожидания от вас, а через некоторое время их чувствуете и вы сами. Вы перестаете работать над собой как личностью. Но с охранником в моем случае произошло нечто иное.

Я работал на своем 400 событии на Campus Madrid Google после года карьеры в качестве охранника. Несколькими месяцами ранее моя жена родила сына. На кампусе меня окружили амбициозные предприниматели. Я видел как они делают важные шаги и идут на риск. Но я чувствовал себя в ловушке безнадежной работы, пытающийся свести концы с концами и обеспечить свою растущую семью.

На сцену поднялся спикер. Я стоял рядом и слушал каждое слово. Тогда он произнес предложение, которое изменило мою жизнь навсегда:

Любой может научиться программировать и работать разработчиком.

Сперва это заявление вызвало у меня скепсис: ивент имел отношение к дорогому буткемпу для разработчиков. К тому же, в Испании профессии, требующие интеллектуального труда, отведены людям с университетским дипломом. Но спикер сказал, что из-за высокого спроса работодатели идут на исключения. Он утверждал, что все, что необходимо для работы в разработке ПО, — пробиться через заграждение задач по программированию и интервью в процессе собеседования.

Я помню тот конкретный момент, когда закончил изучать все его заявления. Для меня стало откровением, что его слова не были просто маркетингом, а имели корни в экономике нашего времени. Тогда я принял решение. Я собирался стать разработчиком. Чего бы мне это не стоило.

В поиске курсов

У меня не было времени бездельничать, поэтому я решил воспользоваться лучшим способом обучения программированию. Я начал с расспрашивания друзей-разработчиков в Campus Madrid вроде Карлоса Эрнандеза, СЕО Gamify. Он порекомендовал начать с сайтов вроде Codecademy, а затем ставить конкретные цели и достигать их в его приложении. Я продолжал поиски онлайн, прыгая с одного ресурса на другой. День за днем я пробовал каждый из курсов, который находил.

Затем я поговорил с Даниелем Мери, основателем локального митапа по Haskell. Он был уверен, что я могу научиться программировать бесплатно, использую opensource-ресурсы. Я послушался его совета — попробовал freeCodeCamp. И мне понравилось.

Вкратце, магия freeCodeCamp это:

- у вас есть четкий пошаговый путь;

- проблемы достаточно сложные. Здесь вас не держат за ручку, как на многих других ресурсах. Они дают вам пространство, чтобы совершать свои ошибки;

- у вас есть доступ к глобальному сообществу, которое готово поддержать вас 24/7;

- вы создаете реальные проекты быстро и последовательно;

- вы можете писать код, который помогает реальным общественным организациям.

Мои ошибки

Я бы хотел сказать, что с этого момента я принимал лучшие решения и воспользовался кратчайшим путем к должности разработчика. Но, правда в том, что я совершал ошибки. Главной из них было то, что я не заканчивал то, что начинал.

Когда я начал учиться программировать, я продвигался очень быстро. Начало медового месяца с программированием было прекрасным. Я чувствовал себя царем горы. Поэтому, когда я сталкивался с проблемой, которую не мог быстро решить в голове, я не старался найти для нее программное решение. Я хотел продолжать двигаться быстрее, поэтому я шел дальше, изучая все больше и больше. Как результат, у меня было множество наполовину решенных проблем и незавершенных проектов.

В конце концов я понял горькую правду: эти нерешенные проблемы не исчезнут, а будут только возвращаться, чтобы кусать меня. Мне нужно было научиться «ползать» прежде, чем «учиться» ходить. Реальность в том, что лучше иметь один завершенный проект, чем тысячи неготовых.

Еще одна ошибка — я постоянно терял ФОКУС. Когда я искал решение своей проблемы, я мог заинтересоваться какой-то другой темой. А потом еще одной и еще одной… и прежде чем я успевал опомниться, день подходил к концу, а моя изначальная проблема оставалась нерешенной. Годом позже я услышал, как Пабло Альмуние описывал этот феномен как «охоту за белками». Вспоминайте эту сцену каждый раз, когда отвлекаетесь:

Следующий шаг

Мое внимание переключалось каждый день. Я позволял интернету искушать меня все новыми и новыми блестящими курсами, яркими языками и невероятными фреймворками. Я начал чувствовать, что никогда не стану достаточно квалифицированным, чтобы получить работу разработчика. Возможно, программирование было для меня слишком глубоким озером и я мог в нем утонуть.

Но я подумал про своего сына. Я подумал о будущем, которое хочу для него. О примере, который хотел ему показать, не сдавшись.

Тогда я встретил разработчика по имени Улис Гаскон. Он посоветовал закончить проекты, которые я начал. Он даже предложил помощь. Поэтому, я вернулся к «легким» вещам, которые забросил. Сделав это, я начал задавать новые вопросы и сталкиваться с новыми вызовами.

Советы Гаскона и Эрнандеса сыграли ключевую роль в моем обучении. Поэтому, я с уверенностью могу сказать, что следующим шагом для меня стало то, что я попросил помощи у друзей.

Вхождение в сообщество

Мое обучение ускорялось. Я заканчивал все больше проектов и хотел строить новые, но понятия не имел над чем поработать.

Кто-то посоветовал пойти на мероприятия сообщества и искать вдохновения там. Но большинство событий в моем городе были лекциями, нацеленными на крутых разработчиков и фокусировались на суперсовременных технологиях.

Я же хотел создавать вещи с профессионалами всех уровней, но подходящего сообщества не было. Именно в этот момент я начал размышлять как настоящий программист. Если у тебя нет подходящего инструмента… сделай его сам! Поэтому я поговорил с друзьями, помогавшими мне ранее, и вместе мы основали Open Source Weekends.

После долгих недель тяжелой работы, спонсоров, которые отказывались от участия в последний момент, множества вложенных времени и денег, мы смогли сделать наш первый ивент. Спустя семь месяцев Open Source Weekends выиграл Open Award за лучшее открытое сообщество. В итоге, участие в жизни сообщества стало для меня критичным шагом. Это помогло мне улучшить социальные навыки и стать не просто «парнем, который учиться программировать».

Автор текста (третий слева) с наградой Open Award

Первая работа

После 11 месяцев обучения программированию, множества провалов и все новых попыток, основания opensource-комьюнити, я получил письмо через рассылку нашего Open Source Weekends.

Компания Kubide искала backend-разработчика. Я решил сфокусироваться именно на back-end всего пару месяцев назад. Мне не слишком понравилась frontend-разработка, но я с удовольствием проводил часы за решением проблем в back-end. Kubide прислали мне тестовое задание: клон Twitter API. Это было сложно, но не катастрофически.

Затем я попал на собеседование с СЕО компании. Его больше интересовали мои навыки в обучении, чем успехи в разработке. Он также хотел нанять человека, с которым познакомился через сферу стартапов, а я для него ассоциировался с Campus Madrid (хоть я и был просто охранником).

Спустя три дня после встречи я получил звонок с предложением работы. Не могу передать свои чувства в тот момент. Все вокруг были так рады за меня. Наконец вся тяжелая работа, которую я вложил в обучение, была вознаграждена.

Мои первые впечатления от работы

Обычно такого рода истории заканчиваются на этапе хэппиэнда. Но я хочу рассказать вам о том, как это, когда вы попали на свою первую работу разработчика. Уверен, это поможет вдохновить вас на успех.

Вначале всегда страшно. Но это начало было и захватывающим. Вы проходите через эмоциональные русские горки. Сперва чувствуете себя изгоем. Кажется, что у вас нет необходимых навыков, чтобы писать новый код с нуля. Но вы стараетесь изо всех сил.

Пробуйте, пробуйте и снова пробуйте. Когда вам кажется, что вы испробовали все, продолжайте пытаться. После, можно обратиться за помощью к более опытным коллегам, которые смогут направить вас на верный путь. В этот момент вы начнете чувствовать себя лучше, потому что будете заканчивать некоторые из задач.

Однажды вы увидите кого-то, решающего проблему, на которую вам требовался день, за минуту. Вы снова почувствуете себя изгоем. Но через некоторое время вы сами поможете кому-то решить проблему и снова почувствуете себя лучше. В конце концов, вы поймете сами или вам скажет руководитель, что вас наняли не за навыки, которые у вас были. Вас взяли на работу за навыки, которым вы могли научиться. Потому что лучшая стратегия — нанимать людей, которые умеют учиться и страстно хотят этого.

«Самое опасное препятствие — вы сами», — Анхель Луис Кесада.

Как только вы поймете это, вы почувствуете себя лучше. Вы станете быстрее развиваться. Вы будете расти вместе с партнерами. Вы будете любить работу сильнее и сильнее и вы будете счастливы.

Автор в компании счастливых коллег

В заключение:

- Помните, зачем вы начали учиться программированию.

- Не гоняйтесь за белками.

- Заканчивайте проекты.

- Будьте упорны.

az network lb rule | Microsoft Docs

Управление правилами балансировки нагрузки.

В этой статье

Команды

az network lb rule create

Создайте правило балансировки нагрузки.

az network lb rule create --backend-port

--frontend-port

--lb-name

--name

--protocol {All, Tcp, Udp}

--resource-group

[--backend-pool-name]

[--backend-pools-name]

[--disable-outbound-snat {false, true}]

[--enable-tcp-reset {false, true}]

[--floating-ip {false, true}]

[--frontend-ip-name]

[--idle-timeout]

[--load-distribution {Default, SourceIP, SourceIPProtocol}]

[--probe-name]

[--subscription]Примеры

Создайте правило балансировки нагрузки, которое назначает интерфейсную IP-конфигурацию и порт для пула адресов и порта.

az network lb rule create -g MyResourceGroup --lb-name MyLb -n MyLbRule --protocol Tcp \

--frontend-ip-name MyFrontEndIp --frontend-port 80 \

--backend-pool-name MyAddressPool --backend-port 80Создайте правило балансировки нагрузки, которое назначает интерфейсную IP-конфигурацию и порт для пула адресов и порта с помощью функции плавающего IP-адреса.

az network lb rule create -g MyResourceGroup --lb-name MyLb -n MyLbRule --protocol Tcp \

--frontend-ip-name MyFrontEndIp --backend-pool-name MyAddressPool \

--floating-ip true --frontend-port 80 --backend-port 80Создайте правило балансировки нагрузки портов с высоким уровнем доступности, которое назначает интерфейсный IP-адрес и порт для использования всех доступных серверных адресов в пуле в том же порте.

az network lb rule create -g MyResourceGroup --lb-name MyLb -n MyHAPortsRule \

--protocol All --frontend-port 0 --backend-port 0 --frontend-ip-name MyFrontendIp \

--backend-pool-name MyAddressPoolОбязательные параметры

—backend-port

—frontend-port

—lb-name

Имя подсистемы балансировки нагрузки.

—name -n

Имя правила балансировки нагрузки.

—protocol

Протокол сетевого транспорта.

допустимые значения: All, Tcp, Udp

—resource-group -g

Имя группы ресурсов. Вы можете настроить расположение по умолчанию с помощью az configure --defaults group=<name>.

Необязательные параметры

—backend-pool-name

Имя серверного пула адресов. Если существует только один параметр, не используйте его в качестве значения по умолчанию.

—backend-pools-name

Список имен серверного пула адресов.

—disable-outbound-snat

Настраивает SNAT для виртуальных машин в внутреннем пуле для использования адреса publicIP, указанного на интерфейсном сервере правила балансировки нагрузки.

допустимые значения: false, true

—enable-tcp-reset

Получение двунаправленного сброса TCP на время ожидания простоя потока TCP или непредвиденное завершение соединения. Используется, только если для параметра Протокол задано значение TCP.

допустимые значения: false, true

—floating-ip

Включить плавающий IP-адрес.

допустимые значения: false, true

—frontend-ip-name

Имя внешней IP-конфигурации. Если существует только один параметр, не используйте его в качестве значения по умолчанию.

—idle-timeout

Время ожидания простоя в минутах.

—load-distribution

Параметры правил сходства.

допустимые значения: Default, SourceIP, SourceIPProtocol

значение по умолчанию: default

—probe-name

Имя существующей проверки, связываемой с этим правилом.

—subscription

Имя или идентификатор подписки Вы можете настроить подписку по умолчанию с помощью az account set -s NAME_OR_ID .

Глобальные параметры

—debug

Повышение уровня детализации журнала для включения всех журналов отладки.

—help -h

Отображение этого справочного сообщения и выход.

—only-show-errors

Показывать только ошибки, блокируя предупреждения.

—output -o

Формат вывода.

—query

Строка запроса JMESPath. Дополнительные сведения и примеры см. в разделе http://jmespath.org/.

—verbose

Повышение уровня детализации журнала. Чтобы включить полные журналы отладки, используйте параметр —debug.

az network lb rule delete

Удаление правила балансировки нагрузки.

az network lb rule delete --lb-name

--name

--resource-group

[--subscription]Примеры

Удаление правила балансировки нагрузки.

az network lb rule delete -g MyResourceGroup --lb-name MyLb -n MyLbRuleОбязательные параметры

—lb-name

Имя подсистемы балансировки нагрузки.

—name -n

Имя правила балансировки нагрузки.

—resource-group -g

Имя группы ресурсов. Вы можете настроить расположение по умолчанию с помощью az configure --defaults group=<name>.

Необязательные параметры

—subscription

Имя или идентификатор подписки Вы можете настроить подписку по умолчанию с помощью az account set -s NAME_OR_ID .

Глобальные параметры

—debug

Повышение уровня детализации журнала для включения всех журналов отладки.

—help -h

Отображение этого справочного сообщения и выход.

—only-show-errors

Показывать только ошибки, блокируя предупреждения.

—output -o

Формат вывода.

—query

Строка запроса JMESPath. Дополнительные сведения и примеры см. в разделе http://jmespath.org/.

—verbose

Повышение уровня детализации журнала. Чтобы включить полные журналы отладки, используйте параметр —debug.

Перечисление правил балансировки нагрузки.

az network lb rule list --lb-name

--resource-group

[--query-examples]

[--subscription]Примеры

Перечисление правил балансировки нагрузки.

az network lb rule list -g MyResourceGroup --lb-name MyLb -o tableОбязательные параметры

—lb-name

Имя подсистемы балансировки нагрузки.

—resource-group -g

Имя группы ресурсов. Вы можете настроить расположение по умолчанию с помощью az configure --defaults group=<name>.

Необязательные параметры

—query-examples

Рекомендуемая строка JMESPath. Можно скопировать один из запросов и вставить его после параметра—query в двойных кавычках, чтобы увидеть результаты. Можно добавить одно или несколько позиций ключевых слов, чтобы мы могли предоставлять предложения на основе этих ключевых слов.

—subscription

Имя или идентификатор подписки Вы можете настроить подписку по умолчанию с помощью az account set -s NAME_OR_ID .

Глобальные параметры

—debug

Повышение уровня детализации журнала для включения всех журналов отладки.

—help -h

Отображение этого справочного сообщения и выход.

—only-show-errors

Показывать только ошибки, блокируя предупреждения.

—output -o

Формат вывода.

—query

Строка запроса JMESPath. Дополнительные сведения и примеры см. в разделе http://jmespath.org/.

—verbose

Повышение уровня детализации журнала. Чтобы включить полные журналы отладки, используйте параметр —debug.

Получение сведений о правиле балансировки нагрузки.

az network lb rule show --lb-name

--name

--resource-group

[--query-examples]

[--subscription]Примеры

Получение сведений о правиле балансировки нагрузки.

az network lb rule show -g MyResourceGroup --lb-name MyLb -n MyLbRuleОбязательные параметры

—lb-name

Имя подсистемы балансировки нагрузки.

—name -n

Имя правила балансировки нагрузки.

—resource-group -g

Имя группы ресурсов. Вы можете настроить расположение по умолчанию с помощью az configure --defaults group=<name>.

Необязательные параметры

—query-examples

Рекомендуемая строка JMESPath. Можно скопировать один из запросов и вставить его после параметра—query в двойных кавычках, чтобы увидеть результаты. Можно добавить одно или несколько позиций ключевых слов, чтобы мы могли предоставлять предложения на основе этих ключевых слов.

—subscription

Имя или идентификатор подписки Вы можете настроить подписку по умолчанию с помощью az account set -s NAME_OR_ID .

Глобальные параметры

—debug

Повышение уровня детализации журнала для включения всех журналов отладки.

—help -h

Отображение этого справочного сообщения и выход.

—only-show-errors

Показывать только ошибки, блокируя предупреждения.

—output -o

Формат вывода.

—query

Строка запроса JMESPath. Дополнительные сведения и примеры см. в разделе http://jmespath.org/.

—verbose

Повышение уровня детализации журнала. Чтобы включить полные журналы отладки, используйте параметр —debug.

az network lb rule update

Обновите правило балансировки нагрузки.

az network lb rule update [--add]

[--backend-pool-name]

[--backend-pools-name]

[--backend-port]

[--disable-outbound-snat {false, true}]

[--enable-tcp-reset {false, true}]

[--floating-ip {false, true}]

[--force-string]

[--frontend-ip-name]

[--frontend-port]

[--idle-timeout]

[--ids]

[--lb-name]

[--load-distribution {Default, SourceIP, SourceIPProtocol}]

[--name]

[--probe-name]

[--protocol {All, Tcp, Udp}]

[--remove]

[--resource-group]

[--set]

[--subscription]Примеры

Обновите правило балансировки нагрузки, чтобы изменить протокол на UDP.

az network lb rule update -g MyResourceGroup --lb-name MyLb -n MyLbRule --protocol UdpОбновите правило балансировки нагрузки для поддержки портов высокой доступности.

az network lb rule update -g MyResourceGroup --lb-name MyLb -n MyLbRule \ --protocol All --frontend-port 0 --backend-port 0Обновите правило балансировки нагрузки. автоматически сформированный

az network lb rule update --disable-outbound-snat true --lb-name MyLb --name MyLbRule --resource-group MyResourceGroupОбновите правило балансировки нагрузки. автоматически сформированный

az network lb rule update --idle-timeout 5 --lb-name MyLb --name MyLbRule --resource-group MyResourceGroupНеобязательные параметры

—add

Добавьте объект в список объектов, указав путь и пары «ключ-значение». Пример:—добавить свойство. Листпроперти <ключ = значение, строка или строка JSON>.

—backend-pool-name

Имя серверного пула адресов.

—backend-pools-name

Список имен серверного пула адресов.

—backend-port

—disable-outbound-snat

Настраивает SNAT для виртуальных машин в внутреннем пуле для использования адреса publicIP, указанного на интерфейсном сервере правила балансировки нагрузки.

допустимые значения: false, true

—enable-tcp-reset

Получение двунаправленного сброса TCP на время ожидания простоя потока TCP или непредвиденное завершение соединения. Используется, только если для параметра Протокол задано значение TCP.

допустимые значения: false, true

—floating-ip

Включить плавающий IP-адрес.

допустимые значения: false, true

—force-string

При использовании «Set» или «Add» сохраните строковые литералы вместо того, чтобы пытаться преобразовать их в JSON.

—frontend-ip-name

Имя внешней IP-конфигурации.

—frontend-port

—idle-timeout

Время ожидания простоя в минутах.

—ids

Один или несколько идентификаторов ресурсов (с разделителями-пробелами). Это должен быть полный идентификатор ресурса, содержащий все сведения об аргументах «Resource id». Необходимо указать идентификаторы или другие аргументы «Resource id».

—lb-name

Имя подсистемы балансировки нагрузки.

—load-distribution

Параметры правил сходства.

допустимые значения: Default, SourceIP, SourceIPProtocol

значение по умолчанию: default

—name -n

Имя правила балансировки нагрузки.

—probe-name

Имя существующей проверки, связываемой с этим правилом.

—protocol

Протокол сетевого транспорта.

допустимые значения: All, Tcp, Udp

—remove

Удаление свойства или элемента из списка. Пример:—Remove Property. List или—Remove пропертиторемове.

—resource-group -g

Имя группы ресурсов. Вы можете настроить расположение по умолчанию с помощью az configure --defaults group=<name>.

—set

Обновите объект, указав путь к свойству и значение, которое необходимо задать. Пример:—Set свойство1. свойство2 =.

—subscription

Имя или идентификатор подписки Вы можете настроить подписку по умолчанию с помощью az account set -s NAME_OR_ID .

Глобальные параметры

—debug

Повышение уровня детализации журнала для включения всех журналов отладки.

—help -h

Отображение этого справочного сообщения и выход.

—only-show-errors

Показывать только ошибки, блокируя предупреждения.

—output -o

Формат вывода.

—query

Строка запроса JMESPath. Дополнительные сведения и примеры см. в разделе http://jmespath.org/.

—verbose

Повышение уровня детализации журнала. Чтобы включить полные журналы отладки, используйте параметр —debug.

Приглашаем Вас на работу в Angry

Молодая и очень активно развивающаяся компания Angry занимается сбором, анализом и обработкой обращений клиентов из открытых источников, социальных сетей, СМИ и блогосферы. Нам требуются специалисты по машинному обучению на очень, очень и очень интересные

задачи по созданию крутого продукта!

Какие задачи нужно будет решать:

- эмоциональная оценка коротких и длинных текстов, написанных с использование сленга и специфичной лексики (sentiment analysis)

- классификация текстов по категориям (конечное множество)

- выделение в тексте различных данных

- в режиме реального времени в потоке текстовых сообщений находить популярные тренды (темы)

- специфичный антиспам (определять релевантность текста заданной теме)

Необходимые навыки и знания:

- системы машинного обучения включая распознавание, классификацию, выделение признаков, нейросети, обучение без учителя

- обработка естественного языка, компьютерная лингвистика, синтаксический анализ текстов на русском языке

- Python, scikit-learn и другие библиотеки для машинного обучения

Что мы предлагаем:

- работа над нетривиальным проектом

- офис 5 минут от м. Шаболовская

- оформление по ТК РФ, белая заработная плата

- дружный коллектив

- возможность развиваться профессионально, получая бесценный опыт.

Ключевые навыки:

Машинное обучениеPythonBig Data

Разработчик front-end

Компания «Перспективный мониторинг» 10 лет работает на рынке информационной безопасности. Мы активно развиваем продуктовое направление и ищем фронтендера в команду разработки киберполигона Ampire.

Благодаря учебно-тренировочной платформе Ampire сотрудники служб информационной безопасности и ИТ-служб могут в изолированной среде отработать навыки выявления и противодействия хакерским атакам, не переживая за сервисы на проде.

Ampire — это виртуализированная информационная инфраструктура офиса, завода, телеком-компании, энергокомпании или банка. В каждой такой инфраструктуре десятки виртуальных машин, специфичных сервисов и пользователей.

Вся инфраструктура, которую моделирует Ampire, очень динамична. Нужно будет сделать интерактивную страницу с наглядным отображением состояния инфраструктуры, сервисов и возможностей подключиться к серверам или АРМ виртуального предприятия.

Во время киберучений Ampire собирает много статистической информации — кто и какие ресурсы атаковал, логи виртуальных машин и сервисов, действия и оценки обучающихся. Нужно будет сделать так, чтобы со всеми этими данными было удобно работать в веб-интерфейсе и преподавателям, и студентам.

Задачи:

-

проектирование и разработка веб-интерфейсов -

рефакторинг имеющегося проекта, поддержка и развитие кодовой базы -

взаимодействие с backend разработчиками -

наставничество младших разработчиков

Ожидания от квалификации:

- уверенное знание JavaScript (ES5+), умение писать структурированный и читаемый код

- уверенные знания HTML, CSS, SCSS

- знание Vue\React\Angular

- опыт проектирования клиентской части

Будет плюсом следующий опыт:

- проектирование UI\UX

- оптимизация клиентской стороны веб-приложения

- опыт в роли наставника

Условия работы:

- Работа в офисе в Технопарке «Отрадное», метро Отрадное.

- полное соблюдение трудового законодательства РФ, оплачиваемые отпуска и больничные листы, «белая» заработная плата.

- начало работы с 8.00 до 11.00, продолжительность рабочего дня 8 часов + 1 час на обед.

- оплачиваемое работодателем питание в офисе или кафе.

- ДМС (добровольное медицинское страхование) — различные варианты программ, страховка от несчастных случаев.

- изучение английского в офисе.

- возможность получения профессиональных сертификатов и прохождения курсов повышения квалификации за счёт компании.

Из сисадминов в бэкенд-программисты. Долгий путь к новой работе

Всем привет! Меня зовут Дмитрий, мне 31 год, и я начинающий бэкенд-разработчик. Я расскажу историю о том, как новые знания меняют цели в карьере, как перейти в новую профессию, когда тебе 31, у тебя есть семья и нет финансовой подушки, чтобы всё бросить и искать новую работу.

Кем работал

Моим первым и единственным местом работы была небольшая компания, занимающаяся обслуживанием оргтехники и локальных сетей. Там я работал на должности системного администратора, где занимался всем — от ремонта компьютеров и ноутбуков, до настройки СУБД и веб-серверов для 1С.

Всё шло хорошо. У нас сложился дружный коллектив, работать было комфортно, я старался развиваться этой сфере. Иногда мне попадались простые задачи, связанные с вебом: подкорректировать главную страницу на сайте клиентов, перенести сайт на другой хостинг, добавить счётчик «Яндекс.Метрики». Временами мой товарищ, который был веб-разработчиком, просил помочь ему с наполнением или вёрсткой. На тот момент я знал немного про вёрстку, заглядывал на сайт Htmlbook, пытался изучать программирование по редким на тот момент курсам или книгам. Самообразование мне давалось туго, я думал, что это просто не моё — и меня это устраивало.

Мое знакомство с веб-разработкой

Через пару лет нашей компании понадобилось переделать сайт. Был давно готов макет, оставалось только найти разработчика и сделать. Мне стало интересно попробовать сверстать настоящий макет самостоятельно — и я взялся. Тем более, что по срокам меня никто не ограничивал. А в качестве «движка» я выбрал CMS, написанную моим знакомым. Прошло немного времени, и всё было готово и размещено на хостинге. Мне понравилось, что я самостоятельно сверстал и запустил сайт, пусть и самый примитивный. Это придало уверенности, что научиться разработке вполне возможно, и я начал подыскивать курсы по программированию. К тому времени их стало немного больше.

Попытки учиться

Первым мне попался сайт Html Academy, где я ознакомился с HTML и CSS. Но интерес к нему быстро остыл, потому что программирование по-прежнему казалось чем-то далеким, а знание HTML/CSS уверенности не придавало. Насколько я помню, на тот момент там ещё не было уроков по программированию.

Следующим ресурсом был Itvdn. Здесь я купил и успешно прошел курс по HTML/CSS, но учиться там дальше не захотел — было сложно высидеть двухчасовой урок, а затем выполнять задание, вспоминая, на какой же минуте видео рассказывалась нужная информация. В общем, такой формат мне не зашел.

Обучение на Хекслете

Примерно в это же время коллега по работе рассказал о неплохих курсах по программированию Hexlet. Заинтересовавшись, я прошел пару бесплатных уроков. Прохождение не вызывало желания закрыть урок, приглянулась подача материала — короткое видео о чем-то конкретном с тестами в конце. Так я прошел бесплатный курс по введению в программирование, и, поняв в процессе, что мне это подходит, оформил подписку. К этому шагу располагала цена в 24$, что было очень даже приемлемо за такой материал. Ещё одним из решающих факторов для меня было то, что здесь учат фундаментальным вещам, которые применимы к другим языкам, а не только к тому, на котором учишься. Одним словом, здесь учат программированию, а не только синтаксису языка. В начале обучения я начал проходить профессию «PHP-разработчик», так как мой кругозор был ограничен тем, что PHP — на бэкенде, а JavaScript — на фронтенде.

Проходил курсы по вечерам, когда засыпал ребенок, и иногда на работе, когда было свободное время. Руководитель был не против, что я занимаюсь саморазвитием в IT.

Трудности

Первым моим камнем преткновения стал курс «PHP: Построение абстракций», такой СИКП на PHP. Вообще, если учишься на Хекслете, то эту аббревиатуру услышишь ещё не раз. Мозг кипел, было много непонятного. В комментариях к урокам встречались сообщения о том, что это очень сложно. Там же отвечали, что этот же материал дан в курсе по JS более понятно, и стоит пройти его там, если не понятно. Так я и сделал.

Читайте и другие истории успеха:

Как благодаря Хекслету я устроился в EPAM, стал сеньором и уехал в США.

Действительно, мне удалось пройти этот курс на JS. В процессе я узнал про применение Javascript на сервере, Node.JS для бэкенда, и решил продолжить изучение этого языка. Тем более, что я был уверен — не важно, какой язык первым изучаешь на Хекслете.

Далее ещё были сложности в обучении — в основном связанные с тем, когда ты что-то не усвоил в одном уроке, подсмотрел решение учителя в практике, ничего не понял и пошёл дальше. Дальше это незнание накапливается, и ты не понимаешь вообще ничего. Это очень деморализовало, и на пару недель обучение забрасывалось. Позже я научился с этим справляться — заново прошёл все курсы и закрыл пробелы в знаниях, старался не подсматривать решения, а разбираться с задачей самому, иногда возвращаясь к предыдущим темам.

Продолжительность обучения

В моём обучении был большой перерыв в 3-4 месяца, связанный с бытовыми делами, и пара небольших, связанных как раз с неумением справиться со сложностью. В итоге прохождение профессии без проектов заняло у меня примерно полтора года.

Проекты я начал проходить после пары собеседований, когда понял, что в них смогу получить начальный опыт. Прохождение проектов заняло больше года. Первые три шли по плану — по одному проект в месяц. Четвертый затянулся почти на год в связи болезнями, рабочими проблемами во время пандемии и устройством на новую работу. Сейчас, когда на работе всё более менее устаканилось, я возобновил работу над проектом и надеюсь в скором времени его сдать.

Поиск работы

К окончанию обучения мои планы насчет работы изменились — я уже не собирался подрабатывать «допиливанием» сайтов на вордпресс, а хотел работать в команде разработчиков, выполнять сложные и интересные задачи. У моего начальства не было планов по организации отдела разработки, а заниматься этим самостоятельно казалось невозможным — не было знаний и практики в построении приложений, в настройке необходимых для этого библиотек и фреймворков. Кроме того, мне надоело заниматься тем, чем я занимался на работе, и захотелось сменить деятельность. В общем, я приступил к поиску новой работы, сделал резюме и начал его рассылать.

В Краснодаре найти оплачиваемую работу новичку оказалось достаточно сложно, везде требуется опыт работы, в том числе «в коммерческой разработке». Но я отправлял резюме даже в компании с такими требованиями. За время поисков я прошёл четыре собеседования и выполнил одно тестовое задание.

Первая попытка

Первое собеседование состоялось у одного зеленого мобильного оператора. В вакансии указывалось, что требуется «Джуниор JavaScript-разработчик». Тестового задания не было. На собеседовании были пара ребят из местного офиса, HR и разработчик из другого города на удалёнке. По технической части вопросов было мало, в основном про жизнь, почему меняешь работу и так далее. Затем объяснили, чем придется заниматься: это оказалась техподдержка в B2B-кабинете, в которой программирование занимало 10%, и то в какой-то своей системе. После собеседования сказали, что перезвонят, но мне уже самому не хотелось, чтобы перезванивали.

Вторая попытка

Знакомый разработчик скинул мне контакты руководителя местной IT-компании, занимающейся разного рода разработкой. Я связался, меня пригласили пообщаться. Там требовались разработчики по двум направлениям: бэкенд на PHP и фронтенд. В PHP я практически не разбирался, с фронтом было получше, но все же недостаточно, чтобы начать работать. Вообще получилась интересная ситуация — JS-разработчик, который не умеет во фронтенд. После беседы предложили месяц неоплачиваемой стажировки, за время которой я должен был подтянуть HTML/CSS и прочие дела, которые происходят во фронтенде, а после стажировки зарплату раза в два меньше моих ожиданий. Надо заметить, что мои зарплатные ожидания были немного завышены, и связано это было с необходимостью получать определенный минимум для содержания семьи. Поэтому я поблагодарил ребят за предложение и продолжил свои поиски.

После второй попытки стало понятно, что мне не хватает практического опыта, поэтому я решил пройти проекты на Хекслете.

Третья попытка

Ещё одна попытка попасть во фронтенд. Это была местная компания, которая занимается разработкой пары популярных медицинских сайтов с рейтингами докторов и клиник. Отправил им резюме, получил тестовое задание. Требовалось сделать страницу, где нужно делать запросы к тестовому API, получать данные и изображения, и выводить их в определенном порядке. Из библиотек предлагалось использовать JQuery. Задание оказалось несложным, и я выполнил его без особых проблем. После него меня пригласили на собеседование.

На собеседовании присутствовали фронтенд-разработчик и кто-то из технического руководства. Разработчик давал задачи на программирование, а руководитель спрашивал «за жизнь». С задачами на алгоритмы я справился без проблем, с вопросами по верстке немного посыпался.

Через несколько дней HR мне ответила, что они не готовы взять меня на работу. Возможно, не стоило на собеседовании на фронтенд спрашивать: «Нельзя ли в дальнейшем перейти в бэкенд?».

Четвертая попытка

HR следующей компании сама меня нашла на hh.ru и предложила прийти на собеседование. Компания занимается рекламой в интернете и в соцсетях, у неё есть большой отдел разработчиков. В Краснодаре как раз открывался филиал, куда меня и пригласили.

Тестового задания не было — они обратили внимание на мой недоделанный четвертый проект Хекслета, который лежал на Github. На собеседовании общался с бекенд-разработчиком. Были вопросы по работе NodeJS, асинхронности, SQL. На вопросах про SQL я начал немного «плавать», потому что прошло много времени после прохождения курса, а я не подумал повторить. Затем открыли мой четвертый проект и по нему я быстро рассказал, что там происходит.

После моего провала с SQL, я подумал, что со мной вежливо попрощаются, но интервьюер пообщался с руководством, и мне сразу предложили пройти месяц оплачиваемой стажировки. Я согласился. Когда выходил из офиса, то не мог поверить, что меня берут на работу бэкенд-разработчиком на стек, который я знаю. Мое удивление было связано с тем, что я выбрал не слишком популярное направление для Краснодара. Куда проще было устроиться «PHP разработчиком на Битрикс».

Как работается

Через две недели после собеседования я вышел на новую работу, получил достаточно мощный компьютер с парой мониторов. Я сам поставил на него привычный дистрибутив линукс и начал осваиваться на рабочем месте. Меня практически сразу отправили «в бой» — поручили работать с одним из партнеров компании над поддержкой и доработкой внутреннего сервиса средних размеров. Сначала я довольно сильно переживал, что на меня свалилась такая большая ответственность, но коллектив оказывал моральную поддержку. Бороться с переживаниями помогли рассуждения Кирилла на одном из вебинаров по поводу софт-скиллов — о том, что нужно не бояться задавать вопросы, но при этом сначала пробовать делать что-то самому. Также помогал метод «выяснить, что делать дальше» из популярной книги по GTD.

В целом, я довольно уверенно справлялся с поставленными задачами с самого начала работы. В этом определенно заслуга проектов, потому что все инструменты и технологии мне уже знакомы. Полученных теоретических знаний вполне достаточно, чтобы разбираться в легаси коде и отлаживать его. В свободное время с коллегой по проекту разбираемся с его задачами.

Планы

В первую очередь — доделать четвертый проект, выполнение которого я затянул. Понемногу осваиваю Python, чтобы не зацикливаться на JS. Интересный и очевидный факт — второй язык на Хекслете осваивать в разы проще. Это говорит о фундаментальных знаниях, которые получаешь здесь. Также хочется поучаствовать в опенсорс-проектах Хекслета. Вообще, много планов про изучение языков или технологий, ребята на Хекслете вдохновляют меня своими статьями и вебинарами, за что им огромное спасибо!

Выводы

— Изучать можно любой язык, который нравится. Или пробовать несколько, а потом выбирать. На Хекслете всему учат хорошо.

— Умение правильно задавать вопросы — это навык, который вы тоже здесь получите, поэтому не замыкайтесь с нерешенными задачами и мыслью «это не мое, это слишком сложно для меня».

— Проекты — это важно, не экономьте на этом.

Ещё

Хочется отметить крутую атмосферу, которая царит вокруг Хекслета:

- Полезные обсуждения в слаке — от программирования до трудоустройства;

- Помощь с обучением в том же слаке или в обсуждениях к заданиям;

- Вдохновляющие вебинары на Youtube. Я не знаю как, но у Кирилла получается мотивировать, просто рассказывая «что нового на Хекслете»;

- Шикарные статьи и гайды по разным технологиям и языкам программирования.

Логика фильтров должна быть на frontend или backend?

Я создаю веб-приложение

Frontend-reactjs и backend-java.

Frontend и backend общаются друг с другом через rest.

В пользовательском интерфейсе я показываю список элементов. И мне нужно отфильтровать их по некоторым параметрам.

Вариант 1: логика фильтра находится на переднем конце

В этом случае мне просто нужно сделать вызов get в бэкэнд и получить все элементы.

После того, как пользователь выбирает какой-то параметр фильтра, фильтрация происходит в пользовательском интерфейсе.

Плюсы : для этого мне не нужно отправлять данные в бэк-энд и ждать ответа. Скорость обновления списка должна быть быстрее.

Минусы: Если мне понадобится несколько фронтенд-клиентов. Скажем, мобильное приложение. Чем мне нужно снова создавать фильтры в этом приложении.

Вариант 2: логика фильтра находится на заднем конце

В этом случае я получаю все элементы списка при загрузке приложения. После того, как пользователь изменит параметры фильтра, мне нужно отправить запрос get с параметрами фильтров и дождаться ответа.

После этого обновите список элементов на UI.

Плюсы: логика фильтра пишется только один раз.

Минусы: скорость, вероятно, будет намного медленнее. Потому что требуется время, чтобы отправить запрос и получить результат обратно.

Вопрос: где должна быть логика фильтра? В frontend или в backend? Или, может быть, что является лучшей практикой?

java

reactjs

rest

Поделиться

Источник

Alex Belke

15 сентября 2018 в 16:32

4 ответа

- Вызовите BackEnd-метод из FrontEnd, написанный в бэкэнде

это немного сложно объяснить, но я надеюсь, что смогу прояснить ситуацию: В моем BackEnd у меня есть StringBuilder, в котором я пишу HTML-код для FrontEnd и назначаю его Div.InnerHTML, чтобы показать. Теперь в этом коде у меня должна быть возможность вызвать BackEnd-метод, как я обычно делаю с…

- FrontEnd или шифрование BackEnd?

Я создаю систему, требующую пароля. Мой вопрос в том, должен ли я зашифровать его frontend или backend? Если я сделаю это frontend (вероятно, с javascript), то каждый сможет взломать шифрование = большая проблема безопасности. Но если я сделаю это бэкендом, то простой пароль должен быть каким-то…

28

Фильтр и ограничение на заднем конце. Если бы у вас был миллион записей и сто тысяч пользователей, пытающихся получить доступ к этим записям одновременно, вы действительно хотели бы отправить миллион записей пользователю EVERY? Это убило бы ваш сервер и пользовательский опыт (ожидание распространения миллиона записей с заднего конца для каждого пользователя AND, а затем распространение на переднем конце заняло бы целую вечность по сравнению с простым получением 20-100 записей, а затем нажатием кнопки (разбиение на страницы) для получения следующего 20-100). Кроме того, чтобы отфильтровать миллион записей на интерфейсе, опять же, потребуется очень много времени и, в конечном счете, не очень практично.

С точки зрения реального мира, большинство веб-сайтов имеют какой-то лимит записей: Ebay = 50-200 записи, Amazon = ~20, Цель = ~20… и т. Д. Это обеспечивает быстрые ответы сервера и плавный пользовательский интерфейс для каждого пользователя.

Поделиться

Matt Carlotta

15 сентября 2018 в 16:49

11

Это зависит от размера ваших данных.

Например: Если у вас большой объем данных, лучше реализовать логику фильтра на бэкэнде и позволить бд выполнять операции.

В случае, если у вас меньше данных, вы можете выполнить логику фильтрации на переднем конце после получения данных.

Давайте разберемся в этом на примере.

Предположим, у вас есть сущность, имеющая 1 000 000 записей, и вы хотите показать ее в сетке.

В этом случае лучше получить 10 записей о каждом вызове и показать их в сетке.

Если вы хотите выполнить какую-либо операцию фильтрации, лучше сделать запрос к БД на бэкэнде и получить результаты

В случае, если у вас есть только 1000 записей в вашей сущности, будет полезно получить все данные и выполнить все операции фильтрации на интерфейсе.

Поделиться

Sagar Chaudhary

15 сентября 2018 в 16:52

8

Это зависит от конкретных требований вашего приложения, но, на мой взгляд, более безопасной ставкой будет бэк-энд.

Учитывая, что вам в первую очередь нужна фильтрация, я предполагаю, что у вас достаточно данных, чтобы их можно было просматривать. В этом случае вам необходимо иметь фильтрацию на внутреннем сервере.

Допустим, у вас размер страницы 20. После применения фильтра вы ожидаете, что в UI появится страница из 20 сущностей, соответствующих этим конкретным критериям фильтрации. Этого невозможно достичь, если вы извлекаете 20 объектов, сохраняете их в интерфейсе и затем применяете к ним фильтр.

Кроме того, если у вас достаточно данных, извлечение всех из них в интерфейсе будет невозможно из-за ограничений памяти.

Поделиться

Unknown

15 сентября 2018 в 16:49

- Frontend и Backend с express

В настоящее время я работаю над веб-приложением с express.js. Я хочу иметь интерфейс и бэкэнд. Интерфейс должен показывать некоторое содержимое из базы данных, в бэкэнде я хочу создать это содержимое (аналогично cms). Я начал с этой структуры папок: app/ ├── frontend/ │ ├── public //Javascript,…

- разделение symfony на frontend и backend серверы

В настоящее время у меня есть приложение symfony, которое работает на одном сервере (frontend, backend, database) Теперь мне нужно реализовать это приложение на крупном клиенте, но он не позволяет мне подключиться к базе данных из DMZ. Мне нужно реализовать сервер внутри сети, который будет…

3

Скорее всего, начните с внешнего интерфейса (если только вы не имеете дело с огромными объемами данных):

- Реализуйте фильтрацию на интерфейсе (если только по какой-то причине это не проще сделать на бэкэнде, что я нахожу маловероятным).

- Повторяйте до тех пор, пока функциональность фильтрации не станет несколько стабильной.

- Проанализируйте свой трафик, посмотрите, есть ли смысл вкладывать усилия в реализацию внутренней фильтрации. Посмотрите, какой процент запросов на самом деле фильтруется и какую экономию вы получите от внутренней фильтрации.

- Реализовать (или нет) бэкенд-фильтрацию в зависимости от результатов #3.

Как личное замечание, принятый ответ-ужасный совет:

- «Если бы у вас был миллион записей и сто тысяч пользователей, пытающихся получить доступ к этим записям одновременно»; ничто не заставляет сто тысяч пользователей использовать фильтрацию, ваша система должна быть в состоянии справиться с этим сценарием конца света. Бэкэнд-фильтрация должна быть просто оптимизацией, а не решением.

- как только вы сделаете фильтрацию на бэкэнде, вы, вероятно, захотите также сделать разбиение на страницы; это не тривиальная функция, если вы хотите получить последовательные результаты.

- выполнение бэкэнд-фильтрации, скорее всего, станет намного сложнее, чем просто фронтэнд-фильтрация; вы должны знать, что потратите значительное количество времени (не только на первоначальную реализацию, но и на текущее обслуживание), и спросить себя, не является ли это преждевременной оптимизацией.

TL/DR: делайте то, что вам проще, и не беспокойтесь об этом, пока не появится смысл начать оптимизацию.

Поделиться

Tom

08 декабря 2019 в 11:20

Похожие вопросы:

Как создать файл cookie, с помощью frontend или backend?

Насколько я понимаю, cookie-это какой-то способ сделать наше веб-приложение статусным. Поскольку файлы cookie могут быть созданы как в javascript (frontend), так и из http response (by backend),…

Magento запрос-Frontend, Backend или API?

Хорошо — я прочитал и мне нравится обсуждение Magento frontend/backend и согласен с ответом Бена в запросе Magento-Frontend или Backend? А теперь давайте поднимемся на ступеньку выше. У нас есть…

Архитектура Frontend

На данный момент у нас есть очень тяжелый frontend (frontend+backend в одном приложении на самом деле). Frontend содержит всю логику: UI, бизнес-логику, логику персистентности и так далее. Это очень…

Вызовите BackEnd-метод из FrontEnd, написанный в бэкэнде

это немного сложно объяснить, но я надеюсь, что смогу прояснить ситуацию: В моем BackEnd у меня есть StringBuilder, в котором я пишу HTML-код для FrontEnd и назначаю его Div.InnerHTML, чтобы…

FrontEnd или шифрование BackEnd?

Я создаю систему, требующую пароля. Мой вопрос в том, должен ли я зашифровать его frontend или backend? Если я сделаю это frontend (вероятно, с javascript), то каждый сможет взломать шифрование =…

Frontend и Backend с express

В настоящее время я работаю над веб-приложением с express.js. Я хочу иметь интерфейс и бэкэнд. Интерфейс должен показывать некоторое содержимое из базы данных, в бэкэнде я хочу создать это…

разделение symfony на frontend и backend серверы

В настоящее время у меня есть приложение symfony, которое работает на одном сервере (frontend, backend, database) Теперь мне нужно реализовать это приложение на крупном клиенте, но он не позволяет…

Typescript сборка интерфейса и бэкенда с общей папкой

Я подумываю о переходе на typescript, но борюсь с тем, как сделать общую папку между интерфейсом и бэкендом? Я придумал эту структуру проекта: frontend — src — server.ts — functions — dist -…

Масштабирование конструирование с frontend и backend экземпляров

Я разрабатываю серию микросервисов с использованием Spring Boot и планирую развернуть их на Kubernetes. Некоторые микросервисы состоят из API, который записывает сообщения в очередь Кафки, и…

Reactify Django или разделенные frontend и backend

Я хотел бы знать, почему sould reactify Django или почему мы должны использовать разделенный django backend и react frontend. какая реализация более масштабируема Я надеюсь, что вы могли бы мне…

HighLoad Junior Блог

Андрей Смирнов

Я попытаюсь залезть в «потроха» и «кишки» бэкенда веб-сервиса и расскажу, как это внутреннее устройство влияет на эффективность сервиса, а также на продукт, его характеристики, и как бы мы могли этим воспользоваться, чтобы наше приложение выдерживало большую нагрузку или работало бы быстрее.

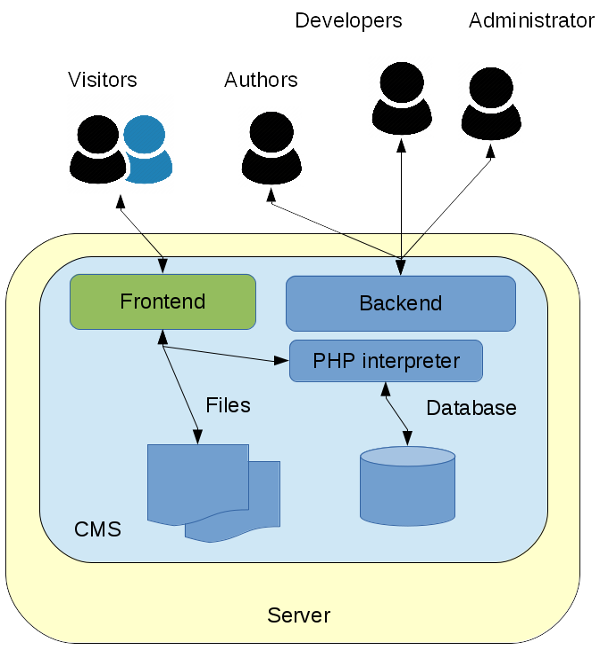

Какую часть я называю веб-сервисом, бэкендом, application-сервером? В классической архитектуре это то, что стоит за http rеverse proxy или load-балансировщиком, а с другой стороны у него находятся БД, memcashed и др. Вот только об этом бэкенде и будет идти речь.

Чем занят бэкенд?

Если посмотреть на соотношение скорости процессора и возможности сетевых соединений, то отличия – на пару порядков. Например, на этом слайде сжатие 1 Кб

данных занимает 3 мкс, в то время как round trip в одну сторону даже внутри одного дата-центра – это уже 0,5 мс. Любое сетевое взаимодействие, которое

нужно бэкенду (например, отправка запроса в БД), потребует, как минимум 2х round trip-ов и по сравнению с тем процессорным временем, которое он тратит на

обработку данных, – это совершенно незначительно. Большую часть времени обработки запроса бэкенд ничего не делает, ждет. Почему он ждет? Существенную часть

относительно сложной работы берет на себя rеverse proxy или load-балансировщик, который стоит перед ним. Это и буферизация запросов и ответов, и валидация

http, «борьба» с медленными клиентами, шифрование https. До бэкенда доходит чисто http-валидный запрос, уже буферизованный, буквально в паре tcp-пакетов.

Ответ также proxy готов буферизовать за бэкенд, ему нет необходимости этим заниматься.

Бэкенд – один из самых больших бездельников в веб-архитектуре. У него есть всего 2 задачи:

- сетевой ввод-вывод – это общение с одной стороны с proxy – прием http-запроса и ответ на него, а с другой стороны общение со всевозможными сервисами,

которые хранят данные – это могут быть БД, очереди, memcaсhed и т.п. - склеивание строк – стерилизовать данные в JSON, сформировать шаблон на основе html, посчитать sh2 или md5? выполнить сжатие данных.

А что такое бизнес-логика в бэкенде? Это проверки наподобие «если значение переменных больше 3-х, делай это», «если пользователь авторизован, покажи одно,

если не авторизован – покажи другое». Бывают, конечно, отдельные задачи, например, по изменению размера картинки, переконвертации видео, но чаще всего

такие задачи решаются вне бэкенда с использованием очередей, воркеров и т.д.

Параллелизм запросов

Если мы говорим о бэкенде, а его производительность во многом будет определять производительность в целом нашего продукта, то у нас может быть 2 цели по

оптимизации:

- заставить его «переваривать» все большее количество запросов в секунду, т.е. увеличить его производительность,

- вторая цель – продуктовая – это уменьшение времени отклика, т.е., чтобы каждый запрос выполнялся намного быстрее, для пользователя результат появлялся

быстрее и т.п.

Если мы вспомним, что бэкенд – бездельник и большую часть времени он ждет, то с точки зрения, чтобы бэкенд мог выдержать как можно большую нагрузку,

совершенно логично, что мы должны в рамках одного ядра процессора обрабатывать не один запрос, а несколько, т.к. процессорное время тратится совсем

небольшое, между ними расположены интервалы ожидания, мы можем обработку нескольких запросов выполнять на одном ядре, переключаясь между ними по мере того,

как обработка блокируется на ожидание какого-то сетевого ввода-вывода.

С другой стороны, если мы хотим оптимизировать время отклика, то что влияет на время отклика? Это то, чем занимается бэкенд – склеиванием строк и сетевым

вводом-выводом. Сетевой ввод-вывод занимает на порядок больше времени, поэтому нужно оптимизировать его. Для этого можно все время ожидания распараллелить

– отправить все запросы одновременно, дождаться всех ответов, сформировать блок для клиента и отправить обратно. Тем самым значительно сокращается время

отклика, если, конечно, бизнес-логика нам позволяет какие-то запросы отправлять одновременно.

Сетевой ввод-вывод

Начнем с сетевого ввода-вывода. Существует 3 варианта организации ввода-вывода: блокирующийся, неблокирующийся и асинхронный. Последний с сетевыми не

работает, остается 2 варианта – блокирующийся, неблокирующийся.

Рассмотрим их на примере API-сокетов, BSD-сокетов, которые есть в UNIX-e, в Windows все то же самое – будут по-другому называться вызовы, но логика та же

самая. Как выглядит API низкоуровневый для работы с tcp-сокетом? Это некий набор вызовов. Если мы говорим о сервере, то он должен создать сокет, должен его

забиндить к некоему адресу, на котором он слушает, сделать listen и сообщить об ожидании входящих соединений. Далее есть вызов accept, который отдает нам

новый сокет, новое соединение с конкретным клиентом, в рамках этого соединения мы можем писать и читать данные из этого сокета, т.е. получать запрос,

отправлять ответ и, в конце концов, мы этот сокет закрываем.

Если у нас ввод-вывод блокирующийся, то большинство важных операций заблокируется до тех пор, пока не появятся данные, новые соединения, или до тех пор,

пока не будет свободен для записи системный сетевой буфер. Наш поток исполнения будет ждать окончания выполнения какой-то операции. Из этого следует

простейший вывод: в рамках одного потока мы не можем обслуживать более одного соединения.

С другой стороны, этот вариант самый простой с точки зрения разработки.

Но существует второй вариант – неблокирующийся ввод-вывод. На поверхности отличия элементарны – вместо того, чтобы заблокироваться, любая операция

завершается немедленно. Если данные не готовы, возвращается специальный код ошибки, по которому понятно, что следует попробовать вызов позднее. При таком

варианте мы можем из одного потока выполнять несколько сетевых операций одновременно. Но, т.к. неизвестно, готов ли сокет к вводу-выводу, пришлось бы

обращаться к каждому сокету по очереди с соответствующими запросами и, по сути, крутиться в вечном цикле, что неэффективно. Необходим механизм опроса

готовности, в который мы могли бы запустить все сокеты, а он бы сообщал нам, которые из них готовы к вводу-выводу. С готовыми мы провели бы все нужные

операции, после чего могли бы заблокироваться, ожидая сокетов, снова готовых к вводу-выводу. Таких механизмов опроса готовности несколько, они отличаются

производительностью, деталями, но обычно он находится «под капотом» и нам не виден.

Как сделать неблокирующийся ввод-вывод? Мы соединяем опрос готовности и операции ввода-вывода с теми и только теми сокетами, которые сегодня готовы. Опрос

готовности у нас блокируется до тех пор, пока не появятся какие-то данные хотя бы в одном сокете.

Второй вопрос по поводу того, что расположено «под капотом» – это вопрос многозадачности. Как мы можем обеспечить одновременную обработку нескольких

запросов (мы договорились, что нам это необходимо)?

Есть 3 базовых варианта:

Отдельные процессы

Самый простой и исторически первый – это на обработку каждого запроса мы запускаем отдельный процесс. Это хорошо, потому что мы можем использовать

блокирующийся ввод-вывод. Если процесс вдруг упадет, это повлияет только на тот запрос, который он обрабатывал, но ни на какие другие.

Из минусов – достаточно сложная коммуникация. Между процессами формально почти нет ничего общего, и любой механизм нетривиальной коммуникации, который мы

хотим организовать, требует дополнительных усилий по синхронизации доступа и т.д. Как эта схема выглядит – вариантов несколько, но обычно запускается 1й

процесс, он делает, например, listen, далее порождает какой-то набор процессов у воркеров, каждый из которых делает accept на том же самом сокете и ожидает

входящих соединений.

Как только появляется входящее соединение, один из процессов разблокируется, получает это соединение, обрабатывает его от начала до конца, закрывает сокет

и снова готов выполнять следующий запрос. Возможны вариации – процесс может порождаться на каждое входящее соединение или они все запущены заранее и т.п.

Это может влиять на характеристики производительности, но это не так принципиально для нас.

Примеры таких систем: FastCGI для тех, кто чаще всего запускает PHP, Phusion Passenger для тех, кто пишет на «рельсах», из БД – это PostgresSQL. На каждое

соединение выделяется отдельный процесс.

Нити операционной системы

В рамках одного процесса мы порождаем несколько потоков, также может быть использован блокирующийся ввод-вывод, потому что будет заблокирован только 1

поток. О нитях знает ОС, она умеет разбрасывать их между процессорами. Нити более легковесны, чем процессы. По сути это означает, что мы можем больше нитей

породить на той же самой системе. Мы вряд ли сможем запустить 10 тыс. процессов, а вот 10 тыс. нитей может быть. Не факт, что это будет эффективно с 10

тысячами, но, тем не менее, они несколько более легковесны.

С другой стороны, отсутствует изоляция, т.е. если происходит какой-то краш, он закрашит весь процесс целиком, а не отдельную нить. И самая большая

сложность – если мы, все-таки, имеем какие-то общие данные в процессе, который обрабатывается в бэкенде, то между нитями отсутствует изоляция. Общая

память, а это означает, что к ней нужно будет синхронизировать доступ. И вопрос синхронизации доступа к общей памяти – это в самом простом случае,

например, может быть соединение с БД, или пул соединений с БД, который общий для всех потоков внутри бэкенда, который обрабатывает входящие соединения.

Синхронизацию доступа сложно провести корректно.

Есть 2 класса сложности:

- если потенциальная проблема – это deadlock-и в процессе синхронизации, когда у нас какая-то часть блокируется намертво и невозможно продолжить

исполнение; -

недостаточная синхронизация, когда у нас происходит конкурентный доступ к общим данным и, грубо говоря, 2 потока эти данные изменяют одновременно и

портят их. Такие программы отлаживать сложнее, не все баги проявляются сразу. Например, знаменитый GIL – Global Interpreter Lock – это один из простейших

способов сделать многопоточное приложение. Мы говорим, что все структуры данных, вся наша память защищена всего одной блокировкой на весь процесс. Казалось

бы, это означает, что многопоточное исполнение невозможно, ведь может выполняться только 1 поток, есть только одна блокировка, и кто-то ее захватил, все

остальные не могут сработать. Да, это так, но вспомним, что мы большую часть времени не работаем на процессы, а ожидаем сетевого ввода-вывода, поэтому в

момент, когда происходит обращение к какой-то блокирующейся операции ввода-вывода, GIL опускается, поток сбрасывает и по сути происходит переключение на

другой поток, который готов к выполнению. Поэтому с точки зрения бэкенда использование GIL может быть не так страшно.

Использование GIL страшно, когда вы пытаетесь в несколько потоков перемножить матрицу – это бессмысленно, потому что будет выполняться только один поток

одновременно.

Примеры. Из БД это MySQL, где на обработку запроса выделяется отдельный поток. Еще Varnish HTTP Cache, в котором воркерами являются нити, обрабатывающие

отдельные запросы.

Кооперативная многозадачность

Третий вариант самый сложный. Здесь мы говорим о том, что ОС, конечно, классная, у нее есть там sсheduler-ы, она умеет обрабатывать процессы, потоки,

организовать между ними приключения, обрабатывать блокировку и т.д., но она все-таки знает хуже о том, как устроено приложение, чем знаем мы. Мы знаем, что

у нас есть короткие моменты, когда совершаются какие-то операции на процессоре, а большую часть времени мы ожидаем сетевого ввода-вывода, и мы лучше знаем,

когда переключаться между обработкой отдельных запросов.

С точки зрения ОС кооперативная многозадачность – это просто один поток выполнения, но внутри него само приложение переключается между обработкой отдельных

запросов. Как только пришли какие-то данные, я их прочитал, разобрал http-запрос, подумал, что мне надо сделать, отправил запрос memcached, а это

блокирующаяся операция, я буду ждать, пока придет ответ от memcached, и вместо того, чтобы ждать, я начинаю обрабатывать другой запрос.

Сложность написания таких программ заключается в том, что вот этот процесс переключения, поддержания контекста, как такового, что я сейчас делаю с каждым

конкретным запросом, ложится на разработчиков. С другой стороны, мы выигрываем в эффективности, потому что нет лишних переключений, нет проблем

переключения, скажем, контекста процессора при переключении между нитями и процессами.

Есть два способа реализовать кооперативную многозадачность.

Один – это способ явный, его отличает большое количество callback-ов. Так как у нас все блокирующие операции приводят к тому, что действие произойдет

когда-нибудь и когда-нибудь управление должно вернуться, когда будет результат, нам приходится постоянно регистрировать callback – когда запрос выполнится,

сделает то, если он будет не успешно, сделает это. Callback-и – это явный вариант, а многие боятся этого, потому что это может быть действительно сложно на

практике.

Второй вариант – неявный, когда мы пишем программу так, что, вроде бы, никакой кооперативной многозадачности нет. Мы делаем блокирующуюся операцию, как мы

ее и делали, и ожидаем результата прямо здесь. На самом деле, существует где-то «черная магия под капотом» – уже нашел framework языка программирования,

runtime, который в этот момент блокирующуюся операцию превращают в неблокирующуюся и передает управление некоему другому потоку исполнения, но не в смысле

нити ОС, а логическому потоку исполнения, который есть внутри. Такой вариант называется грин треды (green threads).

Внутри кооперативной многозадачности всегда есть такое центральное звено, которое отвечает за всю обработку ввода-вывода. Оно называется реактор. Это некий

паттерн разработки. Интерфейс реактора выглядит следующим образом: он говорит: «Дай мне кучу своих сокетов и свои callback-и, и когда этот сокет будет

готов к вводу-выводу, я тебя вызову».

Второй сервис, который предоставляет реактор, это таймер – » Вызови менять через столько-то миллисекунд, вот мой callback, который надо вызвать». Эта штука

будет встречаться везде, где будет кооперативная многозадачность в явном виде или в неявном.

Внутри обычно реактор устроен довольно просто. У него есть отсортированный по времени срабатывания список таймеров. Соответственно, он берет список

сокетов, который ему дали, отправляет их в механизм опроса готовности. А у механизма опроса готовности всегда есть еще один параметр – он говорит, сколько

времени можно заблокироваться, если нет никакой сетевой активности. В качестве времени блокировки он указывает время срабатывания ближайшего таймера.

Соответственно, либо будет какая-то сетевая активность, какой-то из сокетов будет готов к вводу-выводу, либо мы дождемся срабатывания ближайшего таймера,

разблокируемся и передадим управление в тот или иной callback, по сути в логический поток выполнения.

Вот как выглядит кооперативная многозадачность с явными callback-ами.

Пример на node.js, где мы выполняем какую-то блокирующуюся операцию – на самом деле net.connect. «Под капотом» она неблокирующаяся, все хорошо и

регистрируем callback-и. Если все будет успешно, делай то, а если будет неуспешно, делай это.

Проблема callback-ов в том, что в конечном итоге они превращаются в «лапшу», но мы к этому вопросу еще вернемся.

Второй пример.

Здесь тоже кооперативная многозадачность, хотя никаких следов ее в программе не видно.

Здесь мы видим, что запускаются несколько потоков, которые одновременно параллельно? Хотя, на самом деле, кооперативная многозадачность друг за другом

выполняет блокирующуюся операцию – они скачивают некоторые url-ы. Это функция urlopen на самом деле блокирующаяся, но gevent делает некую «черную магию» и

все эти блокирующиеся сетевые операции становятся неблокирующимися, кооперативная многозадачность, переключение контекстов – этого всего мы не видим,

пишем, вроде бы, обычный совершенно последовательный код, но внутри все работает достаточно эффективно.

Примеры систем с кооперативной многозадачностью: Redis, memcached (он не совсем чисто кооперативная многозадачность, хотя многие думают, что это так). В

чем их особенность, почему они себе могут это позволить сделать? Это хранилища данных, но все операции, все данные находятся в памяти, поэтому они, как и

бэкенд – их процессорное время, которое они тратят на обработку одного запроса крайне маленькое. Т.е. в простейшем случае, чтобы обработать get запрос,

надо найти ключ к внутренним хэшам, найти блок данных и вернуть его – просто записать его в сокет в качестве ответа. Поэтому кооперативная многозадачность

для них эффективна.

Если бы Redis или memcached использовали диск для ввода-вывода, все было бы, но это не работало бы просто, потому что, если наш единственный поток

заблокируется на вводе-выводе, это означает, что мы перестанем обслуживать запросы всех клиентов, т.к. поток выполнения один, нигде заблокироваться мы себе

позволить не можем, все операции должны выполняться быстро.

Если кто-то помнит Redis 3-4 года, может, чуть больше лет назад, там была попытка у автора сделать некую виртуальную память, возможность хранить часть

данных на диске. Это называлось virtual memory. Он попробовал это сделать, но быстро понял, что это не работает, потому что как только начинается дисковый

ввод-вывод, время отклика Redis-а сразу уходит на несколько порядков вниз, и это означает, что смысл в нем теряется.

Но на самом деле ни один из этих трех вариантов не является идеальным. Лучше всего работает комбинированный вариант, потому что выигрывает обычно

кооперативная многозадачность, особенно в той ситуации, если ваши соединения долго висят. Например, веб-сокет – соединение долгоживущее, может жить час.

Если вы на обработку одного веб-сокета выделяете один процесс или одну нить, вы существенно ограничиваете то, сколько всего соединений вы можете на одном

бэкенде держать одновременно. А так как соединение живет долго, держать много одновременных соединений важно, в то время, как работы по каждому соединению

будет немного.

Недостаток кооперативной многозадачности в том, что такая программа может использовать только одно ядро процессора. Можно, конечно, запустить несколько

экземпляров бэкендов на одной машине, это не всегда удобно и имеет свои недостатки, поэтому хорошо бы сделать так, чтоб мы запустили несколько процессов

или несколько нитей и внутри каждого процесса или нити использовали кооперативную многозадачность. Такая комбинация позволяет с одной стороны использовать

все доступные ядра процессоров в нашей системе, а с другой стороны мы внутри каждого ядра работаем эффективно, не выделяя больших ресурсов на обработку

каждого отдельного соединения.

2 классических примера – это nginx, в котором вы настраиваете количество воркеров, имеет смысл увеличивать количество воркеров до числа ядер в вашей

системе, это отдельные процессы. Внутри воркера каждый воркер использует неблокирующийся ввод-вывод и кооперативную многозадачность, чтобы обслужить

большое количество одновременных соединений. Воркеры нужны только для того, чтобы распараллелиться между отдельными процессорами.

Второй пример – это memcached, который я уже приводил. У него есть опция запуститься на несколько потоков, несколько нитей ОС. Тогда у нас запускается

несколько нитей, внутри каждой из них крутится реактор, обеспечивающий неблокирующийся ввод-вывод и кооперативную многозадачность, а несколько потоков

позволяют использовать эффективно несколько ядер процессора. Ну, а общей памятью memcached является ведь кэш, который собственно он и обслуживает. Все эти

потоки читают и пишут из того же самого кэша.

Еще один вопрос. Мы все время сейчас говорили о том, как бэкенд обрабатывает, ну большую часть времени, по крайней мере, входящие http-соединения на те

запросы, которые поступают на вход. Но бэкенд делает и исходящие запросы, и таких запросов может быть множество – в сервис-ориентированной архитектуре к

другим сервисам по http, к БД, к Redis-у, к memcached, очередям… И это тот самый сетевой ввод-вывод, который будет сильно влиять на характеристики

бэкенда, как мы об этом договорились изначально.

Посмотрим, как может быть устроен этот драйвер (условно!) базы данных, и как его сделать эффективнее. Во-первых, такая картинка для начала архитектурная:

Предполагаем, что у нас есть несколько серверов, на каждом из них запущен один или несколько экземпляров нашего бэкенда, и существуют какие-то хранилища

данных, которые здесь условно обозначены DB, к которым идут соединения от наших application-серверов. Первый вопрос, если вы используете соединения на один

запрос, т.е. на 1 входящий http-запрос вы открываете соединения с вашей БД с чем угодно и т.д., вы теряете огромное количество времени.

Здесь нарисованы квадратики, соответствующим каким-то отдельным фазам. Они нарисованы совершенно не в масштабе, любая сетевая деятельность занимает больше

времени, чем любая деятельность на процессоре. Т.е. если мы делаем соединения на один запрос, мы теряем огромное количество времени вначале на установление

соединения, в конце на его закрытие, если необходима еще какая-то авторизация доступа, в БД, к примеру, потеряем еще больше времени. Мы за то же самое

время астрономическое, если бы у нас соединение было постоянным, могли бы отправить и получить ответ на два запроса, чем то, что мы сделали с соединением,

которое устанавливается каждый раз. Держать постоянное соединение эффективнее на порядок.

Второй вопрос – а почему надо ждать ответа на запрос, прежде чем отправить следующий? Если между запросами нет логической связи и, по сути, поток запросов

состоит из отдельных, никак не связанных между собой запросов, почему бы нам не отправлять их сразу, не дожидаясь ответа, а потом ждать всех ответов?

Мы, конечно, можем. Это называется pipelining.

Так, например, PostgreSQL умеет делать pipelining.

Вы можете существенно сократить время отклика от БД, а значит уменьшить время отклика бэкенда в целом.

Еще одна вещь. Можно между вашим бэкендом и БД поставить proxy.

Здесь нарисована такая немножко утрированная ситуация, здесь две штуки proxy на пути – одна расположена на хосте с application-сервером, другая – перед БД.

Это не обязательно так, я просто попытался на одной картинке нарисовать два случая.

Зачем нужен, вообще говоря, proxy? Если у вас хороший драйвер базы данных, то есть вы делаете все эффективно, у вас постоянное соединение, pipelining и

т.д., то proxy, вообще говоря, для производительности не нужен, более того, с точки зрения производительности он вреден, потому что он ухудшает время

отклика.

С другой стороны, если у вас плохой драйвер базы данных, то proxy, который умнее, и, например, делает pipelining и постоянное соединение, может уменьшить

время отклика.

С третьей стороны, proxy может использоваться еще для кучи других вещей, например, с помощью proxy можно сделать единую точку входа в БД, в memcached,

можно сделать шардинг, переконфигурацию, переключение без участия приложений. Приложение работает с proxy-сервером, оно не знает, что там за ним, а proxy

можно перенастраивать произвольным образом.

Но существуют proxy-сервера, которые нужны. Вот, например, если вы используете PostgreSQL, вы везде прочитаете, что необходимо перед ним запустить

PgBouncer, и жизнь будет ваша гораздо лучше. Почему? Причина простая – как мы уже говорили, PostgreSQL на обслуживание каждого соединения запускает

отдельный процесс, форкается, это достаточно дорогостоящая операция. Много процессов, много инстансов на каждое соединение держать тоже невыгодно и

неудобно, и proxy, расположенный перед PostgreSQL, позволяет это дело оптимизировать. Он на себя принимает сколько угодно соединений, сколько бы ни было

application-серверов, и их отображает на меньшее количество соединений к PostgreSQL, примерно на 100.

Если у вас сервис-ориентированная архитектура, то все проблемы, о которых мы говорили, они умножаются на некий коэффициент К, у вас становится больше

сетевых хопов, вы должны сделать больше запросов, для того чтобы ответить на один и тот же запрос клиента, и чем эффективнее вы сможете это дело

реализовать, тем эффективнее будет ваш бэкенд в конечном итоге.

Реальный мир

Мы подбираемся к той части доклада, которой я боюсь, поэтому я одеваю каску, чтобы в меня не полетели гнилые помидоры или какие-то еще нехорошие фрукты.

Я буду говорить о ваших любимых языках программирования, и как в них устроена многозадачность, сетевой ввод-вывод, и что вы можете от них добиться.

Итак, если вы пишете на JavaScript. JavaScript однопоточный, кроме веб-воркеров, но они являются изолированной сущностью. Он однопоточный

с точки зрения модели вычислений, в нем асинхронный ввод-вывод, не блокирующийся, в нем есть некий реактор, в котором вы регистрируете таймеры с

callback-ами и т.д. Что бы вы ни делали, если вы просто будете писать код на JavaScript, в конечном итоге у вас получится «лапша» из callback-ов. К

счастью, в последнее время JavaScript-мир узнал о такой штуке как Deferred или Promise, узнал, что это круто, и она активно внедряется. Это некая

абстракциия, она может быть полезна в любом языке программирования, где у вас кооперативная многозадачность в явном виде с callback-ами, которая позволяет

развязать эту «лапшу» и сделать ее более стройной. Deferred или Promise – это концепция отложенного результата, т.е. это обещание вернуть результат в

пустой блок, когда результат придет. Я могу на этом пустом блоке регистрировать обработчики ошибочных или успешных ситуаций, выстраивать их в цепочки,

связывать одни Promise-ы с другими и, по сути, моделировать те самые паттерны программирования обычного синхронного и существенно упрощать себе жизнь.

PHP

. Он формально поддерживает многопоточный режим выполнения, но на практике это не работает в силу тех или иных причин исторических. В большинстве случаев,

если вы запускаете PHP, его существенным недостатком является то, что на каждый входящий запрос мы очищаем все и начинаем все сначала. Поэтому есть всякие

PHP-акселераторы, кэширование и т.п. и т.д. Чаще всего, соответственно, это многопроцессное выполнение запросов, внутри блокирующийся ввод-вывод,

постоянное соединение, скажем, с БД в виде какой-то отдельной «нашлепки», как некоего состояния, которое может сохраняться между обработкой отдельных

запросов и т.д. и.т.д.

Ruby on Rails

– некая вещь, больше имеющая воздействие на мир. До Ruby 1.9, если я не ошибаюсь, потоки внутри Ruby были грин тредами, т.е. на самом деле были

кооперативной многозадачностью. это честные потоки ОС. Есть различные варианты. Самый базовый – это многопроцессный и блокирующийся ввод-вывод. Есть

framework EventMachine, который был списан с Python-овского framework-а Twisted, позволяющий сделать кооперативную многозадачность. У него есть свои плюсы

и минусы, есть реализации, использующие EventMachine.

Есть Python. Python счастлив тем, что на нем можно написать любой вариант. Можно написать многопроцессный сервер, можно многопоточный,

можно с кооперативной многозадачностью, с callback-ами или с грин тредами. Все доступно в различных вариантах и комбинациях, но в принципе все опять

довольно скучно, все то же самое.

Есть Java со своей виртуальной машиной и все, соответственно, языки которые работают на JVM, потоки ОС уже давно, когда-то тоже в самом

начале были грин треды. Есть возможность делать блокирующий и неблокирующий ввод-вывод, и как в любом мире enterprise есть какой-нибудь framework, который

я могу воткнуть в середину, и он для меня вообще все это дело абстрагирует. Мне все равно, я ему просто сказал, что делать, а моя задача – только писать

что то сверху.

Есть .NET, который все то же самое – потоки ОС и т.д., некое отступление, есть конструкция языка async/await, которая напоминает чем-то

Deferred или Promise – такое движение к чему-то более светлому. Почему более светлому? Потому что до этого все очень одинаковое и грустное.

Есть Go, который появился относительно недавно, поэтому смог уже на старте оторваться от преследователей и сделать сразу что-то

интересное. В Go есть горутины, которые являются по сути своей грин тредами, т.е. не являются потоками ОС, но с другой стороны внутренний механизм

выполнения основан на том, что может быть запущено несколько потоков ОС, на которые будут шедулиться горутины, т.е. это комбинация кооперативной

многозадачности и многопоточности. Внутри «под капотом» всегда неблокирующийся ввод-вывод. Из моей горутины я делаю операции, как будто бы они

блокирующиеся, но на самом деле происходит переключение между горутинами, как только я заблокировался, будет выполняться другая горутина. В Go много всего