Содержание

Как закрыть сайт от индексации в robots.txt

Время прочтения: 4 минуты

О чем статья?

- Каким страницам и сайтам не нужно индексирование

- Когда нужно скрыть весь сайт, а когда — только часть его

- Как выбирать теги, закрывающие индексацию

Кому полезна эта статья?

- Контент-редакторам

- Администраторам сайтов

- Владельцам сайтов

Итак, в то время как все ресурсы мира гонятся за вниманием поисковых роботов ради вхождения в ТОП, вы решили скрыться от индексирования. На самом деле для этого может быть масса объективных причин. Например, сайт в разработке или проводится редизайн интерфейса.

Когда закрывать сайт целиком, а когда — его отдельные части?

Маленькие сайты-визитки обычно не требуют сокрытия отдельных страниц. Если ресурс имеет большое количество служебной информации, делайте закрытый портал или закрывайте страницы и целые разделы.

Если ресурс имеет большое количество служебной информации, делайте закрытый портал или закрывайте страницы и целые разделы.

Желательно запрещать индексацию так называемых мусорных страниц. Это старые новости, события и мероприятия в календаре. Если у вас интернет-магазин, проверьте, чтобы в поиске не оказались устаревшие акции, скидки и информация о товарах, снятых с продажи. На информационных сайтах закрывайте статьи с устаревшей информацией. Иначе ресурс будет восприниматься неактуальным. Чтобы не закрывать статьи и материалы, регулярно обновляйте данные в них.

Лучше скрыть также всплывающие окна и баннеры, скрипты, размещенные на сайте файлы, особенно если последние много весят. Это уменьшит время индексации в целом, что положительно воспринимается поиском, и снизит нагрузку на сервер.

Как узнать, закрыт ресурс или нет?

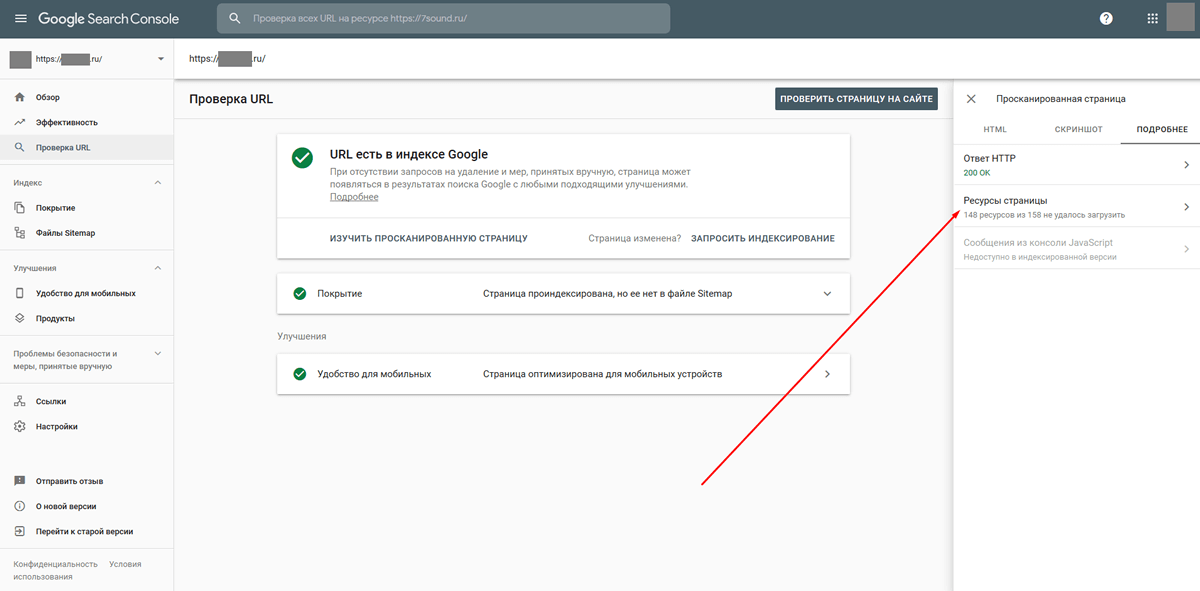

Чтобы точно знать, идет ли индексация robots txt, сначала проверьте: возможно, закрытие сайта или отдельных страниц уже осуществлено? В этом помогут сервисы поисковиков Яндекс. Вебмастер и Google Search Console. Они покажут, какие url вашего сайта индексируются. Если сайт не добавлен в сервисы поисковиков, можно использовать бесплатный инструмент «Определение возраста документа в Яндексе» от Пиксел Тулс.

Вебмастер и Google Search Console. Они покажут, какие url вашего сайта индексируются. Если сайт не добавлен в сервисы поисковиков, можно использовать бесплатный инструмент «Определение возраста документа в Яндексе» от Пиксел Тулс.

Закрываем сайт и его части: пошаговая инструкция.

- Для начала найдите в корневой папке сайта файл robots.txt. Для этого используйте поиск.

- Если ничего не нашли — создайте в Блокноте или другом текстовом редакторе документ с названием robots расширением .txt. Позже его надо будет загрузить в корневую папку сайта.

- Теперь в этом файле HTML-тегами детально распишите, куда заходить роботу, а куда не стоит.

Как полностью закрыть сайт в роботс?

Приведем пример закрытия сайта для основных роботов. Все вместе они обозначаются значком *.

Файл robots.txt позволяет закрывать папки на сайте, файлы, скрипты, utm-метки. Их можно скрыть полностью или выборочно. При этом также указывайте запрет для индексации всем роботам или тем из них, кто ищет картинки, видео и т.п. Например, указание Яндексу не засылать к вам поиск картинок будет выглядеть как

Здесь YandexImages — название робота Яндекса, который ищет изображения. Полные списки роботов можно посмотреть в справке поисковых систем.

Как закрыть отдельные разделы/страницы или типы контента?

Выше мы показали, как запрещать основным или вспомогательным роботам заходить на сайт. Можно сделать немного по-другому: не искать имена роботов, отвечающих за поиск картинок, а запретить всем роботам искать на сайте определенный тип контента. В этом случае в директиве Disallow: / указываете либо тип файлов по модели *.расширениефайлов, либо относительный адрес страницы или раздела.

Прячем ненужные ссылки

Иногда скрыть от индексирования нужно ссылку на странице. Для этого у вас есть два варианта.

- В HTML-коде самой этой страницы укажите метатег robots с директивой nofollow. Тогда поисковые роботы не будут переходить по ссылкам на странице, но на них может вести другой материал вашего или сторонних сайтов.

- В саму ссылку добавьте атрибут rel=»nofollow».

Данный атрибут рекомендует роботу не принимать ссылку во внимание. В этом случае запрет индексации работает и тогда, когда поисковая система находит ссылку не через страницу, где переход закрыт в HTML-коде.

Как закрыть сайт через мета-теги

Альтернативой файлу robots.txt являются теги, закрывающие индексации сайта или видов контента. Это мета-тег robots. Прописывайте его в исходный код сайта в файле index.html и размещайте в контейнере <head>.

Существуют два варианта записи мета-тега.

Указывайте, для каких краулеров сайт закрыт от индексации. Если для всех, напишите robots. Если для одного робота, укажите его название: Googlebot, Яндекс.

Поле “content” из 1 варианта может иметь следующие значения:

- none — индексация запрещена, включая noindex и nofollow;

- noindex — запрещена индексация содержимого;

- nofollow — запрещена индексация ссылок;

- follow — разрешена индексация ссылок;

- index — разрешена индексация;

- all — разрешена индексация содержимого и ссылок.

Таким образом, можно запретить индексацию содержимого сайта независимо от файла robots.txt при помощи content=”noindex, follow”. Или разрешить ее частично: например, вы хотите не индексировать текст, а ссылки — пожалуйста. Используйте для разных случаев сочетания значений.

Если закрыть сайт от индексации через мета-теги, создавать robots.txt отдельно не нужно.

Какие встречаются ошибки

Логические ошибки означают, что правила противоречат друг другу. Выявляйте логические ошибки через проверку файла robots.txt в панелях инструментах Яндекс.Вебмастер и Google, прежде чем загрузить его на сайт..

Синтаксические — неправильно записаны правила в файле.

Выводы

- Запрет на индексирование — весьма полезная возможность. Убирая служебные, повторяющиеся и устаревшие блоки на страницах, вы повысите уникальность контента и экспертность сайта.

- Для проверки того, какие страницы индексируются, проще всего использовать службы поисковиков, но можно воспользоваться сторонними сервисами.

- Вы можете использовать 2 варианта: закрытие страницы через файл robots.txt или же мета-тег robots в файле index.html. Оба файла находятся в корневом каталоге.

- Закрывая служебную информацию, устаревающие данные, скрипты, сессии и utm-метки, для каждого запрета создавайте отдельное правило в файле robots.txt или отдельный мета-тег.

- Разнообразие настроек позволяет точно отобрать и закрыть те части контента, которые, будучи в поиске, не ведут к конверсии, и при этом не могут быть удалены с сайта.

Материал подготовила Светлана Сирвида-Льорентэ.

Как запретить индексацию страницы с помощью robots.txt?

От автора: У вас на сайте есть страницы, которые вы бы не хотели показывать поисковым системам? Из этой статье вы узнаете подробно о том, как запретить индексацию страницы в robots.txt, правильно ли это и как вообще правильно закрывать доступ к страницам.

Итак, вам нужно не допустить индексацию каких-то определенных страниц. Проще всего это будет сделать в самом файле robots.txt, добавив в него необходимые строчки. Хочу отметить, что адреса папок мы прописывали относительно, url-адреса конкретных страниц указывать таким же образом, а можно прописать абсолютный путь.

Допустим, на моем блоге есть пару страниц: контакты, обо мне и мои услуги. Я бы не хотел, чтобы они индексировались. Соответственно, пишем:

User-agent: *

Disallow: /kontakty/

Disallow: /about/

Disallow: /uslugi/

User-agent: * Disallow: /kontakty/ Disallow: /about/ Disallow: /uslugi/ |

Практический курс по верстке адаптивного сайта с нуля!

Изучите курс и узнайте, как верстать современные сайты на HTML5 и CSS3

Узнать подробнее

Естественно, указываем настоящие url-адреса. Если же вам необходимо не индексировать страничку //blog.ru/about-me, то в robots.txt нужно прописать так:

Другой вариант

Отлично, но это не единственный способ закрыть роботу доступ к определенным страничкам. Второй – это разместить в html-коде специальный мета-тег. Естественно, разместить только в тех записях, которые нужно закрыть. Выглядит он так:

<meta name = «robots» content = «noindex,nofollow»>

<meta name = «robots» content = «noindex,nofollow»> |

Тег должен быть помещен в контейнер head в html-документе для корректной работы. Как видите, у него два параметры. Name указывается как робот и определяет, что эти указания предназначены для поисковых роботов.

Параметр же content обязательно должен иметь два значения, которые вписываются через запятую. Первое – запрет или разрешение на индексацию текстовой информации на странице, второе – указание насчет того, индексировать ли ссылки на странице.

Таким образом, если вы хотите, чтобы странице вообще не индексировалась, укажите значения noindex, nofollow, то есть не индексировать текст и запретить переход по ссылкам, если они имеются. Есть такое правило, что если текста на странице нет, то она проиндексирована не будет. То есть если весь текст закрыт в noindex, то индексироваться нечему, поэтому ничего и не будет попадать в индекс.

Кроме этого есть такие значения:

noindex, follow – запрет на индексацию текста, но разрешение на переход по ссылкам;

index, nofollow – можно использовать, когда контент должен быть взят в индекс, но все ссылки в нем должны быть закрыты.

index, follow – значение по умолчанию. Все разрешается.

Запрещается использовать более двух значений. Например:

<meta name = «robots» content = «noindex,nofollow, follow»>

<meta name = «robots» content = «noindex,nofollow, follow»> |

И любые другие. В этом случае мы видим противоречие.

Итог

Наиболее удобным способом закрытия страницы для поискового робота я вижу использование мета-тега. В таком случае вам не нужно будет постоянно, сотни раз редактировать файл robots.txt, чтобы открыть или закрыть очередной url, а это решение принимается непосредственно при создании новых страниц.

Практический курс по верстке адаптивного сайта с нуля!

Изучите курс и узнайте, как верстать современные сайты на HTML5 и CSS3

Узнать подробнее

Хотите узнать, что необходимо для создания сайта?

Посмотрите видео и узнайте пошаговый план по созданию сайта с нуля!

Смотреть

Как закрыть сайт или его страницы от индексации: подробная инструкция

Что нужно закрывать от индексации

Важно, чтобы в поисковой выдаче были исключительно целевые страницы, соответствующие запросам пользователей. Поэтому от индексации в обязательном порядке нужно закрывать:

1. Бесполезные для посетителей страницы или контент, который не нужно индексировать. В зависимости от CMS, это могут быть:

- страницы административной части сайта;

- страницы с личной информацией пользователей, например, аккаунты в блогах и на форумах;

- дубли страниц;

- формы регистрации, заказа, страница корзины;

- страницы с неактуальной информацией;

- версии страниц для печати;

- RSS-лента;

- медиа-контент;

- страницы поиска и т.д.

2. Страницы с нерелевантным контентом на сайте, который находится в процессе разработки.

3. Страницы с информацией, предназначенной для определенного круга лиц, например, корпоративные ресурсы для взаимодействий между сотрудниками одной компании.

4. Сайты-аффилиаты.

Если вы закроете эти страницы, процесс индексации других, наиболее важных для продвижения страниц сайта ускорится.

Способы закрытия сайта от индексации

Закрыть сайт или страницы сайта от поисковых краулеров можно следующими способами:

- С помощью файла robots.txt и специальных директив.

- Добавив метатеги в HTML-код отдельной страницы.

- С помощью специального кода, который нужно добавить в файл .htaccess.

- Воспользовавшись специальными плагинами (если сайт сделан на популярной CMS).

Далее рассмотрим каждый из этих способов.

С помощью robots.txt

Robots.txt — текстовый файл, который поисковые краулеры посещают в первую очередь. Здесь для них прописываются указания — так называемые директивы.

Этот файл должен соответствовать следующим требованиям:

- название файла прописано в нижнем регистре;

- он имеет формат .txt;

- его размер не превышает 500 КБ;

- находится в корне сайте;

- файл доступен по адресу URL сайта/robots.txt, а при его запросе сервер отправляет в ответ код 200 ОК.

В robots.txt прописываются такие директивы:

- User-agent. Показывает, для каких именно роботов предназначены директивы.

- Disallow. Указывает роботу на то, что некоторое действие (например, индексация) запрещено.

- Allow. Напротив, разрешает совершать действие.

- Sitemap. Указывает на прямой URL-адрес карты сайта.

- Clean-param. Помогает роботу Яндекса правильно определять страницу для индексации.

Имейте в виду: поскольку информация в файле robots.txt — это скорее указания или рекомендации, нежели строгие правила, некоторые системы могут их игнорировать. В таком случае в индекс попадут все страницы вашего сайта.

Полный запрет сайта на индексацию в robots.txt

Вы можете запретить индексировать сайт как всем роботам поисковой системы, так и отдельно взятым. Например, чтобы закрыть весь сайт от робота Яндекса, который сканирует изображения, нужно прописать в файле следующее:

User-agent: YandexImages Disallow: /

Чтобы закрыть для всех роботов:

User-agent: * Disallow: /

Чтобы закрыть для всех, кроме указанного:

User-agent: * Disallow: / User-agent: Yandex Allow: /

В данном случае, как видите, индексация доступна для роботов Яндекса.

Запрет на индексацию отдельных страниц и разделов сайта

Для запрета на индексацию одной страницы достаточно прописать ее URL-адрес (домен не указывается) в директиве файла:

User-agent: * Disallow: /registration.html

Чтобы закрыть раздел или категорию:

User-agent: * Disallow: /category/

Чтобы закрыть все, кроме указанной категории:

User-agent: * Disallow: / Allow: /category

Чтобы закрыть все категории, кроме указанной подкатегории:

User-agent: * Disallow: /uslugi Allow: /uslugi/main

В качестве подкатегории здесь выступает «main».

Запрет на индексацию прочих данных

Чтобы скрыть директории, в файле нужно указать:

User-agent: * Disallow: /portfolio/

Чтобы скрыть всю директорию, за исключением указанного файла:

User-agent: * Disallow: /portfolio/ Allow: avatar.png

Чтобы скрыть UTM-метки:

User-agent: * Disallow: *utm=

Чтобы скрыть скриптовые файлы, нужно указать следующее:

User-agent: * Disallow: /scripts/*.ajax

По такому же принципу скрываются файлы определенного формата:

User-agent: * Disallow: /*.png

Вместо .png подставьте любой другой формат.

Через HTML-код

Запретить индексировать страницу можно также с помощью метатегов в блоке <head> в HTML-коде.

Атрибут «content» здесь может содержать следующие значения:

- index. Разрешено индексировать все содержимое страницы;

- noindex. Весь контент страницы, кроме ссылок, закрыт от индексации;

- follow. Разрешено индексировать ссылки;

- nofollow. Разрешено сканировать контент, но ссылки при этом закрыты от индексации;

- all. Все содержимое страницы подлежит индексации.

Открывать и закрывать страницу и ее контент можно для краулеров определенной ПС. Для этого в атрибуте «name» нужно указать название робота:

- yandex — обозначает роботов Яндекса:

- googlebot — аналогично для Google.

Помимо прочего, существует метатег Meta Refresh. Как правило, Google не индексирует страницы, в коде которых он прописан. Однако использовать его именно с этой целью не рекомендуется.

Так выглядит фрагмент кода, запрещающий индексировать страницу:

<html>

<head>

<meta name="robots" content="noindex, nofollow" />

</head>

<body>...</body>

</html>Чтобы запретить индексировать страницу краулерам Google, нужно ввести:

<meta name="googlebot" content="noindex, nofollow"/>

Чтобы сделать то же самое в Яндексе:

<meta name="yandex" content="none"/>

На уровне сервера

В некоторых случаях поисковики игнорируют запреты и продолжают индексировать все данные. Чтобы этого не происходило, рекомендуем попробовать ограничить возможность посещения страницы для отдельных краулеров на уровне сервера. Для этого в файл .htaccess в корневой папке сайта нужно добавить специальный код.Yandex» search_bot

На WordPress

В процессе создания сайта на готовой CMS нужно закрывать его от индексации. Здесь мы разберем, как сделать это в популярной CMS WordPress.

Закрываем весь сайт

Закрыть весь сайт от краулеров можно в панели администратора: «Настройки» => «Чтение». Выберите пункт «Попросить поисковые системы не индексировать сайт». Далее система сама отредактирует файл robots.txt нужным образом.

Закрытие сайта от индексации через панель администратора в WordPress

Закрываем отдельные страницы с помощью плагина Yoast SEO

Чтобы закрыть от индексации как весь сайт, так и его отдельные страницы или файлы, установите плагин Yoast SEO.

Для запрета на индексацию вам нужно:

- Открыть страницу для редактирования и пролистать ее вниз до окна плагина.

- Настроить режим индексации на вкладке «Дополнительно».

Закрытие от индексации с помощью плагина Yoast SEO

Настройка режима индексации

Запретить индексацию сайта на WordPress можно также через файл robots.txt. Отметим, что в этом случае требуется особый подход к редактированию данного файла, так как необходимо закрыть различные служебные элементы: страницы рассылок, панели администратора, шаблоны и т.д. Если этого не сделать, в поисковой выдаче могут появиться нежелательные материалы, что негативно скажется на ранжировании всего сайта.

Как узнать, закрыт ли сайт от индексации

Есть несколько способов, которыми вы можете воспользоваться, чтобы проверить, закрыт ли ваш сайт или его отдельная страница от индексации или нет. Ниже рассмотрим самые простые и удобные из них.

В Яндекс.Вебмастере

Для проверки вам нужно пройти верификацию в Яндексе, зайти в Вебмастер, в правом верхнем углу найти кнопку «Инструменты», нажать и выбрать «Проверка ответа сервера».

Проверка возможности индексации страницы в Яндекс.Вебмастере

В специальное поле на открывшейся странице вставляем URL интересующей страницы. Если страница закрыта от индексации, то появится соответствующее уведомление.

Так выглядит уведомление о запрете на индексацию страницы

Таким образом можно проверить корректность работы файла robots.txt или плагина для CMS.

В Google Search Console

Зайдите в Google Search Console, выберите «Проверка URL» и вставьте адрес вашего сайта или отдельной страницы.

Проверка возможности индексации в Google Search Console

С помощью поискового оператора

Введите в поисковую строку следующее: site:https:// + URL интересующего сайта/страницы. В результатах вы увидите количество проиндексированных страниц и так поймете, индексируется ли сайт поисковой системой или нет.

Проверка индексации сайта в Яндексе с помощью специального оператора

Проверка индексации отдельной страницы

С помощью такого же оператора проверить индексацию можно и в Google.

С помощью плагинов для браузера

Мы рекомендуем использовать RDS Bar. Он позволяет увидеть множество SEO-показателей сайта, в том числе статус индексации страницы в основных поисковых системах.

Плагин RDS Bar

Итак, теперь вы знаете, когда сайт или его отдельные страницы/элементы нужно закрывать от индексации, как именно это можно сделать и как проводить проверку, и можете смело применять новые знания на практике.

Как полностью скрыть сайт от индексации?

Про то, как закрыть от индексации отдельную страницу и для чего это нужно мы уже писали. Но могут возникнуть случаи, когда от индексации надо закрыть весь сайт или зеркало, что проблематичнее. Существует несколько способов. О них мы сегодня и расскажем.

Существует несколько способов закрыть сайт от индексации.

Запрет в файле robots.txt

Файл robots.txt отвечает за индексацию сайта поисковыми роботами. Найти его можно в корневой папке сайта. Если же его не существует, то его необходимо создать в любом текстовом редакторе и перенести в нужную директорию. В файле должны находиться всего лишь две строчки:

User-agent: *

Disallow: /

Остальные правила должны быть удалены.

Этот метод самый простой для скрытия сайта от индексации.

С помощью мета-тега robots

Прописав в шаблоне страниц сайта следующее правило <meta name=»robots» content=»noindex, nofollow»/> или <meta name=»robots» content=»none»/> в теге <head>, вы запретите его индексацию.

Как закрыть зеркало сайта от индексации

Зеркало — точная копия сайта, доступная по другому домену. Т.е. два разных домена настроены на одну и ту же папку с сайтом. Цели создания зеркал могут быть разные, но в любом случае мы получаем полную копию сайта, которую рекомендуется закрыть от индексации.

Сделать это стандартными способами невозможно, т.к. по адресам domen1.ru/robots.txt и domen2.ru/robots.txt открывается один и тот же файл robots.txt с одинаковым содержанием. В таком случае необходимо провести специальные настройки на сервере, которые позволят одному из доменов отдавать запрещающий robots.txt.

#104

Февраль’19

1177

21

#94

Декабрь’18

2972

28

#60

Февраль’18

3667

19

Настройка индексирования. Какие страницы закрывать от поисковых роботов и как это лучше делать

Статья из блога АРТИЗАН-ТИМ.

Каким бы продуманным не был сайт, он всегда будет иметь страницы, нежелательные для индексации. Обработка таких документов поисковыми роботами снижает эффект SEO-оптимизации и может ухудшать позиции сайта в выдаче. В профессиональном лексиконе оптимизаторов за такими страницами закрепилось название «мусорные». На наш взгляд этот термин не совсем корректный, и вносит путаницу в понимание ситуации.

Мусорными страницами уместнее называть документы, не представляющие ценности ни для пользователей, ни для поисковых систем. Когда речь идет о таком контенте, нет смысла утруждаться с закрытием, поскольку его всегда легче просто удалить. Но часто ситуация не столь однозначна: страница может быть полезной с т.з. пользовательского опыта и в то же время нежелательной для индексации. Называть подобный документ «мусорным» — неправильно.

Такое бывает, например, когда разные по содержанию страницы создают для поисковиков иллюзию дублированного контента. Попав в индекс такой «псевдодубль» может привести к сложностям с ранжированием. Также некоторые страницы закрывают от индексации с целью рационализации краулингового бюджета. Количество документов, которые поисковики способны просканировать на сайте, ограниченно определенным лимитом. Чтобы ресурсы краулеров тратились исключительно на важный контент, и он быстрее попадал в индекс, устанавливают запрет на обход неприоритетных страниц.

Как закрыть страницы от индексации: три базовых способа

Добавление метатега Robots

Наличие атрибута noindex в html-коде документа сигнализирует поисковым системам, что страница не рекомендована к индексации, и ее необходимо изъять из результатов выдачи. В начале html-документа в блоке <head> прописывают метатег:

Эта директива воспринимается краулерами обеих систем — страница будет исключена из поиска как в Google, так и в «Яндексе» даже если на нее проставлены ссылки с других документов.

Варианты использования метатега Robots

Закрытие в robots.txt

Закрыть от индексации отдельные страницы или полностью весь сайт (когда это нужно — мы поговорим ниже) можно через служебный файл robots.txt. Прописав в нем одну из директив, поисковым системам будет задан рекомендуемый формат индексации сайта. Вот несколько основных примеров использования robots.txt

Запрет индексирования сайта всеми поисковыми системами:

User-agent: *

Disallow: /

Закрытие обхода для одного поисковика (в нашем случае «Яндекса»):

User-agent: Yandex

Disallow: /

Запрет индексации сайта всеми поисковыми системами, кроме одной:

User-agent: *

Disallow: /

User-agent: Yandex

Allow: /

Закрытие от индексации конкретной страницы:

User-agent: *

Disallow: / #частичный или полный URL закрываемой страницы

Отдельно отметим, что закрытие страниц через метатег Robots и файл robots.txt — это лишь рекомендации для поисковых систем. Оба этих способа не дают стопроцентных гарантий, что указанные документы не будут отправлены в индекс.

Настройка HTTP-заголовка X-Robots-Tag

Указать поисковикам условия индексирования конкретных страниц можно через настройку HTTP-заголовка X-Robots-Tag для определенного URL на сервере вашего сайта.

Заголовок X-Robots-Tag запрещает индексирование страницы

Что убирать из индекса?

Рассмотрев три основных способа настройки индексации, теперь поговорим о том, что конкретно нужно закрывать, чтобы оптимизировать краулинг сайта.

Документы PDF, DOC, XLS

На многих сайтах помимо основного контента присутствуют файлы с расширением PDF, DOC, XLS. Как правило, это всевозможные договора, инструкции, прайс-листы и другие документы, представляющие потенциальную ценность для пользователя, но в то же время способные размывать релевантность страницы из-за попадания в индекс большого объема второстепенного контента. В некоторых случаях такой документ может ранжироваться лучше основной страницы, занимая в поиске более высокие позиции. Именно поэтому все объекты с расширением PDF, DOC, XLS целесообразно убирать из индекса. Удобнее всего это делать в robots.txt.

Страницы с версиями для печати

Страницы с текстом, отформатированным под печать — еще один полезный пользовательский атрибут, который в то же время не всегда однозначно воспринимается поисковиками. Такие документы часто распознаются краулерами как дублированный контент, оказывая негативный эффект для продвижения. Он может выражаться во взаимном ослаблении позиций страниц и нежелательном перераспределении ссылочного веса с основного документа на второстепенный. Иногда поисковые алгоритмы считают такие дубли более релевантными, и вместо основной страницы в выдаче отображают версию для печати, поэтому их уместно закрывать от индексации.

Страницы пагинации

Нужно ли закрывать от роботов страницы пагинации? Данный вопрос становится камнем преткновения для многих оптимизаторов в первую очередь из-за диаметрально противоположных мнений на этот счет. Постраничный вывод контента на страницах листинга однозначно нужен, поскольку это важный элемент внутренней оптимизации. Но в необработанном состоянии страницы пагинации могут восприниматься как дублированный контент со всеми вытекающими последствиями для ранжирования.

Первый подход к решению этой проблемы — настройка метатега Robots. С помощью noindex, follow из индекса исключают все страницы пагинации кроме первой, но не запрещают краулерам переходить по ссылкам внутри них. Второй вариант обработки не предусматривает закрытия страниц. Вместо этого настраивают атрибуты rel=”canonical”, rel=”prev” и rel=”next”. Опыт показывает, что оба этих подхода имеют право на жизнь, хотя в своей практике мы чаще используем первый вариант.

Страницы служебного пользования

Технические страницы, предназначенные для административного использования, также целесообразно закрывать от индексации. Например, это может быть форма авторизации для входа в админку или другие служебные страницы. Удобнее всего это делать через директиву в robots.txt. Документы, к которым необходимо ограничить доступ, можно указывать списком, прописывая каждый с новой строки.

Директива в robots.txt на запрет индексации всеми поисковиками нескольких страниц

Формы и элементы для зарегистрированных пользователей

Речь идет об элементах, которые ориентированы на уже существующих клиентов, но не представляют ценности для остальных пользователей. К ним относят: страницы регистрации, формы заявок, корзину, личный кабинет и т.д. Индексацию таких элементов целесообразно ограничить как минимум из соображений оптимизации краулингового бюджета. На сайтах электронной коммерции отдельное внимание уделяют закрытию страниц, содержащих персональные данные клиентов.

Закрытие сайта во время технических работ

Создавая сайт с нуля или проводя его глобальную реорганизацию, например перенося на новую CMS, желательно разворачивать проект на тестовом сервере и закрывать его от сканирования всеми поисковыми системами в robots.txt. Это уменьшит риск попадания в индекс ненужных документов и другого тестового мусора, который в дальнейшем сможет навредить поисковому продвижению сайта.

Заключение

Настройка индексирования отдельных страниц — важный компонент поисковой оптимизации. Вне зависимости от технических особенностей каждый сайт имеет документы, нежелательные для попадания в индекс. Какой контент лучше скрывать от роботов и как это делать в каждом конкретном случае — мы подробно рассказали выше. Придерживаясь этих рекомендаций, вы оптимизируете ресурсы поисковых краулеров, обеспечите быстрые и эффективные обходы приоритетных страниц, и что самое важное — обезопаситесь от возможных проблем с ранжированием.

Читайте по теме:

Как оптимизировать страницы категорий онлайн-магазинов?

SEO-оптимизация главной страницы интернет-магазина. Подробное руководство

Файл robots.txt: полное руководство | SEO-портал

Стандарт robots.txt отличается оригинальным синтаксисом. Существуют общие для всех роботов директивы (правила), а также директивы, понятные только роботам определенных поисковых систем.

Стандартные директивы

Директивами для robots.txt называются правила, состоящие из названия и значения (параметра), идущего после знака двоеточия. Например:

# Директива User-agent со значением Yandex: User-agent: Yandex

Регистр символов в названиях директив не учитывается.

Для большинства директив стандарта в качестве значения применяется URL-префикс (часть URL-адреса). Например:

User-agent: Yandex # URL-префикс в качестве значения: Disallow: /admin/

Регистр символов учитывается роботами при обработке URL-префиксов.

Директива User-agent

Правило User-agent указывает, для каких роботов составлены следующие под ним инструкции.

Значения User-agent

В качестве значения директивы User-agent указывается конкретный тип робота или символ *. Например:

# Последовательность инструкций для робота YandexBot: User-agent: YandexBot Disallow: /

Основные типы роботов, указываемые в User-agent:

- Yandex

- Подразумевает всех роботов Яндекса.

- YandexBot

- Основной индексирующий робот Яндекса

- YandexImages

- Робот Яндекса, индексирующий изображения.

- YandexMedia

- Робот Яндекса, индексирующий видео и другие мультимедийные данные.

- Подразумевает всех роботов Google.

- Googlebot

- Основной индексирующий робот Google.

- Googlebot-Image

- Робот Google, индексирующий изображения.

Регистр символов в значениях директивы User-agent не учитывается.

Обработка User-agent

Чтобы указать, что нижеперечисленные инструкции составлены для всех типов роботов, в качестве значения директивы User-agent применяется символ * (звездочка). Например:

# Последовательность инструкций для всех роботов: User-agent: * Disallow: /

Перед каждым последующим набором правил для определённых роботов, которые начинаются с директивы User-agent, следует вставлять пустую строку.

User-agent: * Disallow: / User-agent: Yandex Allow: /

При этом нельзя допускать наличия пустых строк между инструкциями для конкретных роботов, идущими после User-agent:

# Нужно: User-agent: * Disallow: /administrator/ Disallow: /files/ # Нельзя: User-agent: * Disallow: /administrator/ Disallow: /files/

Обязательно следует помнить, что при указании инструкций для конкретного робота, остальные инструкции будут им игнорироваться:

# Инструкции для робота YandexImages: User-agent: YandexImages Disallow: / Allow: /images/ # Инструкции для всех роботов Яндекса, кроме YandexImages User-agent: Yandex Disallow: /images/ # Инструкции для всех роботов, кроме роботов Яндекса User-agent: * Disallow:

Директива Disallow

Правило Disallow применяется для составления исключающих инструкций (запретов) для роботов. В качестве значения директивы указывается URL-префикс. Первый символ / (косая черта) задает начало относительного URL-адреса. Например:

# Запрет сканирования всего сайта: User-agent: * Disallow: / # Запрет сканирования конкретной директории: User-agent: * Disallow: /images/ # Запрет сканирования всех URL-адресов, начинающихся с /images: User-agent: * Disallow: /images

Применение директивы Disallow без значения равносильно отсутствию правила:

# Разрешение сканирования всего сайта: User-agent: * Disallow:

Директива Allow

Правило Allow разрешает доступ и применяется для добавления исключений по отношению к правилам Disallow. Например:

# Запрет сканирования директории, кроме одной её поддиректории: User-agent: * Disallow: /images/ # запрет сканирования директории Allow: /images/icons/ # добавление исключения из правила Disallow для поддиректории

При равных значениях приоритет имеет директива Allow:

User-agent: * Disallow: /images/ # запрет доступа Allow: /images/ # отмена запрета

Директива Sitemap

Добавить ссылку на файл Sitemap в можно с помощью одноименной директивы.

В качестве значения директивы Sitemap в указывается прямой (с указанием протокола) URL-адрес карты сайта:

User-agent: * Disallow: # Директив Sitemap может быть несколько: Sitemap: https://seoportal.net/sitemap-1.xml Sitemap: https://seoportal.net/sitemap-2.xml

Директива Sitemap является межсекционной и может размещаться в любом месте robots.txt. Удобнее всего размещать её в конце файла, отделяя пустой строкой.

Следует учитывать, что robots.txt является общедоступным, и благодаря директиве Sitemap злоумышленники могут получить доступ к новым страницам раньше поисковых роботов, что может повлечь за собой воровство контента.

Использование директивы Sitemap в robots.txt может повлечь воровство контента сайта.

Регулярные выражения

В robots.txt могут применяться специальные регулярные выражения в URL-префиксах с помощью символов * и $.

Символ /

Символ / (косая черта) является разделителем URL-префиксов, отражая степень вложенности страниц. Важно понимать, что URL-префикс с символом / на конце и аналогичный префикс, но без косой черты, поисковые роботы могут воспринимать как разные страницы:

# разные запреты: Disallow: /catalog/ # запрет для вложенных URL (/catalog/1), но не для /catalog Disallow: /catalog # запрет для /catalog и всех URL, начинающихся с /catalog, в том числе: # /catalog1 # /catalog1 # /catalog1/2

Символ *

Символ * (звездочка) предполагает любую последовательность символов. Он неявно приписывается к концу каждого URL-префикса директив Disallow и Allow:

User-agent: Googlebot Disallow: /catalog/ # запрет всех URL-адресов, начинающихся с "/catalog/" Disallow: /catalog/* # то же самое

Символ * может применяться в любом месте URL-префикса:

User-agent: Googlebot Disallow: /*catalog/ # запрещает все URL-адреса, содержащие "/catalog/": # /1catalog/ # /necatalog/1 # images/catalog/1 # /catalog/page.htm # и др. # но не /catalog

Символ $

Символ $ (знак доллара) применяется для отмены неявного символа * в окончаниях URL-префиксов:

User-agent: Google Disallow: /*catalog/$ # запрещает все URL-адреса, заканчивающиеся символами "catalog/": # /1/catalog/ # но не: # /necatalog/1 # /necatalog # /catalog

Символ $ (доллар) не отменяет явный символ * в окончаниях URL-префиксов:

User-agent: Googlebot Disallow: /catalog/* # запрет всех URL-адресов, начинающихся с "/catalog/" Disallow: /catalog/*$ # то же самое # Но: Disallow: /catalog/ # запрет всех URL-адресов, начинающихся с "/catalog/" Disallow: /catalog/$ # запрет только URL-адреса "/catalog/"

Директивы Яндекса

Роботы Яндекса способны понимать три специальных директивы:

- Host (устарела),

- Crawl-delay,

- Clean-param.

Директива Host

Директива Host является устаревшей и в настоящее время не учитывается. Вместо неё необходимо настраивать редирект на страницы главного зеркала.

Директива Crawl-delay

Если сервер сильно нагружен и не успевает отрабатывать запросы на загрузку, воспользуйтесь директивой Crawl-delay. Она позволяет задать поисковому роботу минимальный период времени (в секундах) между окончанием загрузки одной страницы и началом загрузки следующей.

Яндекс.Помощь

Правило Crawl-delay следует размещать в группу правил, которая начинается с директивы User-Agent, но после стандартных для всех роботов директив Disallow и Allow:

User-agent: * Disallow: Crawl-delay: 1 # задержка между посещениями страниц 1 секунда

В качестве значений Crawl-delay могут использоваться дробные числа:

User-agent: * Disallow: Crawl-delay: 2.5 # задержка между посещениями страниц 2.5 секунд

Директива Clean-param

Директива Clean-param помогает роботу Яндекса верно определить страницу для индексации, URL-адрес которой может содержать различные параметры, не влияющие на смысловое содержание страницы.

Если адреса страниц сайта содержат динамические параметры, которые не влияют на их содержимое (например: идентификаторы сессий, пользователей, рефереров и т. п.), вы можете описать их с помощью директивы Clean-param.

Яндекс.Помощь

В качестве значения правила Clean-param указывается параметр и URL-префикс адресов, для которых не следует учитывать данный параметр. Параметр и URL-префикс должны быть разделены пробелом:

User-agent: * Disallow: # Указывает на отсутствие значимости параметра id в URL-адресе с index.htm # (например, в адресе seoportal.net/index.htm?id=1 параметр id не станет учитываться, # а в индекс, вероятно, попадёт страница с URL-адресом seoportal.net/index.htm): Clean-param: id index.htm

Для указания 2-х и более незначительных параметров в одном правиле Clean-param применяется символ &:

User-agent: * Disallow: # Указывает на отсутствие значимости параметров id и num в URL-адресе с index.htm Clean-param: id&num index.htm

Директива Clean-param может быть указана в любом месте robots.txt. Все указанные правила Clean-param будут учтены роботом Яндекса:

User-agent: * Allow: / # Для разных страниц с одинаковыми параметрами в URL-адресах: Clean-param: id index Clean-param: id admin

Все о файле «robots.txt» по-русски — как составить robots.txt

Файл robots.txt

Все поисковые роботы при заходе на сайт в первую очередь ищут файл robots.txt. Если вы – вебмастер, вы должны знать назначение и синтаксис robots.txt.

Файл robots.txt – это текстовый файл, находящийся в корневой директории сайта, в котором записываются специальные инструкции для поисковых роботов. Эти инструкции могут запрещать к индексации некоторые разделы или страницы на сайте, указывать на правильное «зеркалирование» домена, рекомендовать поисковому роботу соблюдать определенный временной интервал между скачиванием документов с сервера и т.д.

Создание robots.txt

Файл с указанным расширением – простой текстовый документ. Он создается с помощью обычного блокнота, программ Notepad или Sublime, а также любого другого редактора текстов. Важно, что в его названии должен быть нижний регистр букв – robots.txt.

Также существует ограничение по количеству символов и, соответственно, размеру. Например, в Google максимальный вес установлен как 500 кб, а у Yandex – 32 кб. В случае их превышения корректность работы может быть нарушена.

Создается документ в кодировке UTF-8, и его действие распространяется на протоколы HTTP, HTTPS, FTP.

При написании содержимого файла запрещается использование кириллицы. Если есть необходимость применения кириллических доменов, необходимо прибегать к помощи Punycode. Кодировка адресов отдельных страниц должна происходить в соответствии с кодировкой структуры сайта, которая была применена.

После того как файл создан, его следует запустить в корневой каталог. При этом используется FTP-клиент, проверяется возможность доступа по ссылке https://site.com./robots.txt и полнота отображения данных.

Важно помнить, что для каждого поддомена сайта оформляется свой файл с ограничениями.

Описание robots.txt

Чтобы правильно написать robots.txt, предлагаем вам изучить разделы этого сайта. Здесь собрана самая полезная информация о синтаксисе robots.txt, о формате robots.txt, примеры использования, а также описание основных поисковых роботов Рунета.

- Как работать с robots.txt — узнайте, что вы можете сделать, чтобы управлять роботами, которые посещают ваш веб-сайт.

- Роботы Рунета — разделы по роботам поисковых систем, популярных на просторах Рунета.

- Частые ошибки в robots.txt — список наиболее частых ошибок, допускаемых при написании файла robots.txt.

- ЧаВо по веб-роботам — часто задаваемые вопросы о роботах от пользователей, авторов и разработчиков.

- Ссылки по теме — аналог оригинального раздела «WWW Robots Related Sites», но дополненый и расширенный, в основном по русскоязычной тематике.

Где размещать файл robots.txt

Робот просто запрашивает на вашем сайте URL «/robots.txt», сайт в данном случае – это определенный хост на определенном порту.

На сайте может быть только один файл «/robots.txt». Например, не следует помещать файл robots.txt в пользовательские поддиректории – все равно роботы не будут их там искать. Если вы хотите иметь возможность создавать файлы robots.txt в поддиректориях, то вам нужен способ программно собирать их в один файл robots.txt, расположенный в корне сайта. Вместо этого можно использовать Мета-тег Robots.

Не забывайте, что URL-ы чувствительны к регистру, и название файла «/robots.txt» должно быть написано полностью в нижнем регистре.

Как видите, файл robots.txt нужно класть исключительно в корень сайта.

Что писать в файл robots.txt

В файл robots.txt обычно пишут нечто вроде:

User-agent: *

Disallow: /cgi-bin/

Disallow: /tmp/

Disallow: /~joe/

В этом примере запрещена индексация трех директорий.

Затметьте, что каждая директория указана на отдельной строке – нельзя написать «Disallow: /cgi-bin/ /tmp/». Нельзя также разбивать одну инструкцию Disallow или User-agent на несколько строк, т.к. перенос строки используется для отделения инструкций друг от друга.

Регулярные выражения и символы подстановки так же нельзя использовать. «Звездочка» (*) в инструкции User-agent означает «любой робот». Инструкции вида «Disallow: *.gif» или «User-agent: Ya*» не поддерживаются.

Конкретные инструкции в robots.txt зависят от вашего сайта и того, что вы захотите закрыть от индексации. Вот несколько примеров:

Запретить весь сайт для индексации всеми роботами

User-agent: *

Disallow: /

Разрешить всем роботам индексировать весь сайт

User-agent: *

Disallow:

Или можете просто создать пустой файл «/robots.txt».

Закрыть от индексации только несколько каталогов

User-agent: *

Disallow: /cgi-bin/

Disallow: /tmp/

Disallow: /private/

Запретить индексацию сайта только для одного робота

User-agent: BadBot

Disallow: /

Разрешить индексацию сайта одному роботу и запретить всем остальным

User-agent: Yandex

Disallow:

User-agent: *

Disallow: /

Запретить к индексации все файлы кроме одного

Это довольно непросто, т.к. не существует инструкции “Allow”. Вместо этого можно переместить все файлы кроме того, который вы хотите разрешить к индексации в поддиректорию и запретить ее индексацию:

User-agent: *

Disallow: /docs/

Либо вы можете запретить все запрещенные к индексации файлы:

User-agent: *

Disallow: /private.html

Disallow: /foo.html

Disallow: /bar.html

Инфографика

Проверка

Оценить правильность созданного документа robots.txt можно с помощью специальных проверочных ресурсов:

- Анализ robots.txt. – при работе с Yandex.

- robots.txt Tester – для Google.

Важно помнить, что неправильно созданный или прописанный документ может являться угрозой для посещаемости и ранжирования сайта.

О сайте

Этот сайт — некоммерческий проект. Значительная часть материалов — это переводы www.robotstxt.org, другая часть — оригинальные статьи. Мы не хотим ограничиваться только robots.txt, поэтому в некоторых статьях описаны альтернативные методы «ограничения» роботов.

Robots.txt Введение и руководство | Центр поиска Google

Файл robots.txt сообщает сканерам поисковых систем, к каким URL-адресам сканер может получить доступ на вашем сайте.

Это используется в основном для того, чтобы избежать перегрузки вашего сайта запросами; это не

механизм для защиты веб-страницы от Google . Чтобы веб-страница не попала в Google, вы

должен блокировать индексацию с помощью noindex

или защитите страницу паролем.

Что такое роботы.txt используется для?

Файл robots.txt используется в первую очередь для управления трафиком сканеров на ваш сайт, а также

обычно , чтобы сохранить файл вне Google, в зависимости от типа файла:

| Влияние robots.txt на разные типы файлов | |

|---|---|

| Интернет-страница | Вы можете использовать файл robots.txt для веб-страниц (HTML, PDF или другие Не используйте файл robots.txt как средство, чтобы скрыть свои веб-страницы от поиска Google. Если другие страницы указывают на вашу страницу с описательным текстом, Google все равно может проиндексировать Если ваша веб-страница заблокирована файлом robots.txt , ее URL-адрес все еще может |

| Медиа-файл | Используйте файл robots.txt для управления трафиком сканирования, а также для предотвращения изображений, видео и |

| Файл ресурсов | Вы можете использовать файл robots.txt, чтобы заблокировать файлы ресурсов, такие как неважное изображение, сценарий, или файлы стилей, , если вы считаете, что страницы, загруженные без этих ресурсов, не будут существенно повлияет убыток . Однако если их отсутствие ресурсы затрудняют понимание страницы поисковым роботом Google, вам следует не блокировать их, иначе Google не будет хорошо анализировать страницы, зависящие от эти ресурсы. |

Поймите ограничения роботов.txt файл

Прежде чем создавать или редактировать файл robots.txt, вы должны знать ограничения этой блокировки URL.

метод. В зависимости от ваших целей и ситуации вы можете рассмотреть другие механизмы

убедитесь, что ваши URL-адреса не могут быть найдены в Интернете.

- Директивы robots.txt могут поддерживаться не всеми поисковыми системами.

Инструкции в файлах robots.txt не могут принудить сканер к вашему сайту; работает

гусеницу подчиняться им.Хотя робот Googlebot и другие уважаемые веб-сканеры подчиняются

инструкции в файле robots.txt, другие сканеры не могут. Поэтому, если вы хотите сохранить

информация защищена от веб-сканеров, лучше использовать другие методы блокировки, такие как

защита паролем личных файлов на вашем сервере. - Разные сканеры по-разному интерпретируют синтаксис

Несмотря на то, что уважаемые поисковые роботы следуют директивам в файле robots.txt, каждый поисковый робот

могут интерпретировать директивы по-разному.Вы должны знать

правильный синтаксис для адресации

разные поисковые роботы, так как некоторые могут не понимать определенные инструкции. - Роботизированная страница может

по-прежнему будет индексироваться, если на него ссылаются с других сайтов

Хотя Google не будет сканировать и индексировать контент, заблокированный файлом robots.txt, мы все же можем

найти и проиндексировать запрещенный URL, если на него есть ссылки из других мест в Интернете. Как результат,

URL-адрес и, возможно, другая общедоступная информация, например текст привязки

в ссылках на страницу все еще может отображаться в результатах поиска Google.Чтобы правильно предотвратить ваш URL

от появления в результатах поиска Google,

защитить паролем файлы на вашем сервере,

используйте метатегnoindexили заголовок ответа,

или удалите страницу полностью.

Важно : объединение нескольких директив сканирования и индексирования может вызвать

некоторые директивы для противодействия другим директивам. Узнайте, как

совместить сканирование с директивами индексирования и обслуживания.

Создайте файл robots.txt файл

Если вы решили, что он вам нужен, узнайте, как

создайте файл robots.txt.

Как Google интерпретирует спецификацию robots.txt | Центр поиска

Автоматизированная система Google

краулеры поддерживают

Протокол исключения роботов (REP).

Это означает, что перед сканированием сайта сканеры Google загружают и анализируют

Файл robots.txt для извлечения информации о том, какие части сайта можно сканировать.REP

неприменимо к сканерам Google, которые контролируются пользователями (например, фид

подписок) или поисковые роботы, которые используются для повышения безопасности пользователей (например, вредоносное ПО

анализ).

На этой странице описывается интерпретация REP в Google. Для оригинала

проект стандарта, проверьте

IETF Data Tracker.

Если вы новичок в robots.txt, начните с нашего

введение в robots.txt. Вы также можете найти

советы по созданию файла robots.txt

и обширный список

часто задаваемые вопросы и ответы на них.

Что такое файл robots.txt

Если вы не хотите, чтобы сканеры получали доступ к разделам вашего сайта, вы можете создать файл robots.txt.

с соответствующими правилами. Файл robots.txt — это простой текстовый файл, содержащий правила, в отношении которых

сканеры могут получить доступ к каким частям сайта.

Местоположение файла и срок действия

Вы должны поместить файл robots.txt в каталог верхнего уровня сайта на поддерживаемом

протокол. В случае поиска Google поддерживаемые протоколы: HTTP,

HTTPS и FTP.По HTTP и HTTPS поисковые роботы получают файл robots.txt с помощью HTTP

безусловный запрос GET ; на FTP сканеры используют стандартный

RETR (RETRIEVE) команда с использованием анонимного входа в систему.

Правила, перечисленные в файле robots.txt, применяются только к хосту, протоколу и номеру порта.

где размещен файл robots.txt.

URL-адрес файла robots.txt (как и другие URL-адреса) чувствителен к регистру.

Примеры действительных роботов.txt URL

| Robots.txt Примеры URL | |

|---|---|

http://example.com/robots.txt | Действителен до:

Не действует для:

Это общий случай. Это не действует для других поддоменов, протоколов или портов. |

http://www.example.com/robots.txt | Действителен до: Недействительно для:

Файл robots.txt на субдомене действителен только для этого субдомена. |

http://example.com/folder/robots.txt | Не действующий robots.txt файл. Сканеры не проверяют файлы robots.txt в подкаталогах. |

http://www.exämple.com/robots.txt | Действителен до:

Не действует для: IDN эквивалентны своим версиям punycode.Смотрите также |

ftp://example.com/robots.txt | Действителен до: Не действует для: |

http://212.96.82.21/robots.txt | Действителен до: Не действует для: Файл robots.txt с IP-адресом в качестве имени хоста действителен только для сканирования этого |

http://example.com:80/robots.txt | Действительно для:

Не действует для: Стандартные номера портов ( |

http://example.com:8181/robots.txt | Действителен до: Не действует для: Файлы robots.txt с нестандартными номерами портов действительны только для контента, созданного |

Обработка ошибок и кодов состояния HTTP

При запросе файла robots.txt код состояния HTTP ответа сервера влияет на то, как

файл robots.txt будет использоваться поисковыми роботами Google.

| Обработка ошибок и кодов состояния HTTP | |

|---|---|

2xx (успешно) | Коды состояния HTTP, которые сигнализируют об успехе, побуждают сканеры Google обрабатывать файл robots.текст файл, предоставленный сервером. |

3xx (перенаправление) | Google выполняет не менее пяти переходов переадресации, как определено Google не выполняет логические перенаправления в файлах robots.txt (фреймы, JavaScript или |

4xx (ошибки клиента) | Сканеры Google обрабатывают все ошибки Сюда входят |

5xx (ошибка сервера) | Поскольку сервер не смог дать однозначный ответ на запрос Google robots.txt, Если вам нужно временно приостановить сканирование, мы рекомендуем Если мы можем определить, что сайт неправильно настроен для возврата |

| Прочие ошибки | Файл robots.txt, который невозможно получить из-за проблем с DNS или сетью, например таймауты, недопустимые ответы, сброс или прерванные соединения и ошибки фрагментации HTTP, рассматривается как ошибка сервера. |

Кэширование

Google обычно кэширует содержимое файла robots.txt на срок до 24 часов, но может кэшировать его.

дольше в ситуациях, когда обновление кэшированной версии невозможно (например, из-за

таймауты или ошибки 5xx ). Кешированный ответ может использоваться разными сканерами.

Google может увеличивать или уменьшать время жизни кеша в зависимости от

max-age Cache-Control

Заголовки HTTP.

Формат файла

Роботы.txt должен быть

Простой текст в кодировке UTF-8

файл и строки должны быть разделены символами CR , CR / LF или

LF .

Google игнорирует недопустимые строки в файлах robots.txt, включая Unicode.

Знак порядка байтов

(BOM) в начале файла robots.txt и используйте только допустимые строки. Например, если

загруженный контент представляет собой HTML, а не правила robots.txt, Google попытается проанализировать контент

и извлекать правила, а все остальное игнорировать.

Точно так же, если кодировка файла robots.txt отличается от UTF-8, Google может игнорировать

символы, не входящие в диапазон UTF-8, потенциально могут отображать правила robots.txt

инвалид.

В настоящее время Google применяет ограничение на размер файла robots.txt, равное 500.

кибибайт (KiB). Содержание

после того, как максимальный размер файла игнорируется. Вы можете уменьшить размер файла robots.txt

файл, объединив директивы, которые могут привести к слишком большому размеру файла robots.txt файл. Для

Например, поместите исключенный материал в отдельный каталог.

Синтаксис

Допустимые строки robots.txt состоят из поля, двоеточия и значения. Пробелы необязательны, но

рекомендуется для улучшения читаемости. Пробел в начале и в конце строки равен

игнорируется. Чтобы включить комментарии, поставьте перед комментарием символ # . Держать в

Учтите, что все, что находится после символа # , будет проигнорировано.Общий формат

<поле>: <значение> <# необязательный-комментарий> .

Google поддерживает следующие поля:

-

user-agent: определяет, к какому искателю применяются правила. -

разрешить: путь URL-адреса, который можно сканировать. -

запретить: путь URL, сканирование которого невозможно. -

карта сайта: полный URL карты сайта.

Поля allow и disallow также называются директивами .

Эти директивы всегда указываются в виде

Директива : [путь] , где [путь] является необязательным. По умолчанию нет

ограничения на сканирование для указанных сканеров. Сканеры игнорируют директивы без

[путь] .

Значение [путь] , если указано, относится к корню веб-сайта, откуда

роботы.txt был получен (с использованием того же протокола, номера порта, имени хоста и домена).

Значение пути должно начинаться с / для обозначения корня, а значение —

с учетом регистра. Узнать больше о

Соответствие URL-адресов на основе значений пути.

агент пользователя

Строка пользовательского агента определяет, к каким правилам искателя применяются. Видеть

Сканеры Google и строки пользовательского агента

для получения исчерпывающего списка строк пользовательских агентов, которые вы можете использовать в своих файлах robots.txt файл.

Значение строки пользовательского агента нечувствительно к регистру.

запретить

Директива disallow указывает пути, к которым не должны обращаться сканеры.

идентифицируется строкой user-agent, с которой сгруппирована директива disallow .

Сканеры игнорируют директиву без пути.

Google не может индексировать содержание страниц, сканирование которых запрещено, но все же может

проиндексировать URL-адрес и показать его в результатах поиска без фрагмента.Узнайте, как

блочная индексация.

Значение директивы disallow чувствительно к регистру.

использование:

запретить: [путь]

разрешить

Директива allow определяет пути, к которым могут получить доступ указанные

краулеры. Если путь не указан, директива игнорируется.

Значение директивы allow чувствительно к регистру.

использование:

разрешить: [путь]

карта сайта

Google, Bing и другие основные поисковые системы поддерживают поле карты сайта в

robots.txt, как определено sitemaps.org.

Значение поля карты сайта чувствительно к регистру.

использование:

карта сайта: [absoluteURL]

Строка [absoluteURL] указывает на расположение файла карты сайта или файла индекса карты сайта.Это должен быть полный URL-адрес, включая протокол и хост, и не обязательно

В кодировке URL. URL-адрес не обязательно должен находиться на том же хосте, что и файл robots.txt. Ты можешь

укажите несколько полей карты сайта . Поле карты сайта не привязано к какому-либо конкретному

пользовательский агент, за которым могут следить все сканеры, при условии, что сканирование не запрещено.

Например:

пользовательский агент: otherbot запретить: / капуста карта сайта: https://example.com/sitemap.xml карта сайта: https://cdn.example.org/other-sitemap.xml карта сайта: https://ja.example.org/ テ ス ト - サ イ ト マ ッ プ .xml

Группировка строк и правила

Вы можете сгруппировать правила, которые применяются к нескольким пользовательским агентам, повторяя

user-agent строк для каждого поискового робота.

Например:

пользовательский агент: a запретить: / c пользовательский агент: b запретить: / d пользовательский агент: e пользовательский агент: f запретить: / г пользовательский агент: h

В этом примере есть четыре отдельные группы правил:

- Одна группа для пользовательского агента «a».

- Одна группа для пользовательского агента «b».

- Одна группа для пользовательских агентов «e» и «f».

- Одна группа для пользовательского агента «h».

Техническое описание группы см.

раздел 2.1 РЭП.

Порядок приоритета для пользовательских агентов

Для конкретного поискового робота действительна только одна группа. Сканеры Google определяют правильный

группу правил, найдя в файле robots.txt группу с наиболее конкретным пользовательским агентом

который соответствует пользовательскому агенту поискового робота.Остальные группы игнорируются. Весь несоответствующий текст

игнорируются (например, googlebot / 1.2 и googlebot * являются

эквивалент googlebot ). Порядок групп в файле robots.txt:

не имеющий отношения.

Если для определенного пользовательского агента объявлено несколько групп, все правила из

группы, применимые к конкретному пользовательскому агенту, внутренне объединяются в одну группу.

Примеры

Сопоставление

пользовательского агента полей

пользовательский агент: googlebot-news (группа 1) пользовательский агент: * (группа 2) пользовательский агент: googlebot (группа 3)

Вот как поисковые роботы выберут соответствующую группу:

| Группа отслеживаемых на гусеничном ходу | |

|---|---|

| Новости робота Googlebot | googlebot-news следует за группой 1, потому что группа 1 является наиболее специфической группой. |

| Googlebot (Интернет) | googlebot следует за группой 3. |

| Изображения робота Googlebot | googlebot-images следует за группой 2, потому что нет конкретного googlebot-images группа. |

| Googlebot News (при сканировании изображений) | При сканировании изображений за группой 1 следует googlebot-news . googlebot-news не сканирует изображения для Картинок Google, поэтому толькоследует за группой 1. |

| Другой бот (Интернет) | Другие сканеры Google следуют за группой 2. |

| Otherbot (новости) | Другие сканеры Google, которые сканируют новостной контент, но не идентифицируют себя как googlebot-news следуйте за группой 2. Даже если есть запись для связаннойпоисковый робот, он действителен только в том случае, если он специально соответствует. |

Группировка правил

Если в файле robots.txt есть несколько групп, относящихся к определенному пользовательскому агенту,

Сканеры Google внутренне объединяют группы. Например:

пользовательский агент: googlebot-news запретить: / рыба пользовательский агент: * запретить: / морковь пользовательский агент: googlebot-news запретить: / креветка

Сканеры внутренне группируют правила на основе пользовательского агента, например:

пользовательский агент: googlebot-news запретить: / рыба запретить: / креветка пользовательский агент: * запретить: / морковь

Соответствие URL на основе значений пути

Google использует значение пути в директивах allow и disallow в качестве

основа для определения того, применяется ли правило к определенному URL-адресу на сайте.Это работает

сравнение правила с компонентом пути URL-адреса, который поисковый робот пытается получить.

Не 7-битные символы ASCII в пути могут быть включены как символы UTF-8 или как экранированные с помощью процентов

Символов в кодировке UTF-8 на

RFC 3986.

Google, Bing и другие основные поисковые системы поддерживают ограниченную форму подстановочных знаков для

значения пути. Эти:

-

*обозначает 0 или более экземпляров любого допустимого символа. -

$обозначает конец URL-адреса.

| Пример совпадения пути | |

|---|---|

/ | Соответствует корневому URL-адресу и любому URL-адресу нижнего уровня. |

/ * | Эквивалент /. Завершающий подстановочный знак игнорируется. |

/ | Соответствует только корню.Любой URL нижнего уровня разрешен для сканирования. |

/ рыба | Соответствует любому пути, который начинается с Матчей:

Не соответствует:

Примечание. При сопоставлении учитывается регистр. |

/ рыба * | Эквивалент Матчей:

Не соответствует:

|

/ рыба / | Соответствует чему-либо в папке Матчей:

Не соответствует:

|

/*.php | Соответствует любому пути, который содержит Матчей:

Не соответствует:

филиппинских песо |

/*.php $ | Соответствует любому пути, который заканчивается на Матчей:

Не соответствует:

|

/fish*.php | Соответствует любому пути, который содержит Матчей:

Не совпадает: |

Порядок приоритетности правил

При сопоставлении правил robots.txt с URL-адресами сканеры используют наиболее конкретное правило на основе

длина его пути. В случае противоречивых правил, в том числе с использованием подстановочных знаков, Google использует

наименее ограничительное правило.

Следующие примеры демонстрируют, какое правило поисковые роботы Google будут применять к заданному URL-адресу.

| Примеры ситуаций | |

|---|---|

http://example.com/page | разрешить: / p запретить: / Применимое правило : |

http://example.com/folder/page | разрешить: / папка disallow: / папка Применимое правило : |

http://example.com/page.htm | разрешить: / страница запретить: /*.htm Применимое правило : |

http://example.com/page.php5 | разрешить: / страница запретить: / *.ph Применимое правило : |

http://example.com/ | разрешить: / $ запретить: / Применимое правило : |

http: // example.com / page.htm | разрешить: / $ запретить: / Применимое правило : |

Отключить индексацию поисковой системой | Webflow University

В этом видео используется старый интерфейс. Скоро выйдет обновленная версия!

Вы можете указать поисковым системам, какие страницы сканировать, а какие нет на вашем сайте, написав файл robots.txt файл. Вы можете запретить сканирование страниц, папок, всего вашего сайта. Или просто отключите индексацию своего поддомена webflow.io. Это полезно, чтобы скрыть такие страницы, как ваша страница 404, от индексации и включения в результаты поиска.

В этом уроке

Отключение индексации субдомена Webflow

Вы можете запретить Google и другим поисковым системам индексировать субдомен webflow.io, просто отключив индексирование в настройках вашего проекта.

- Перейдите в Project Settings → SEO → Indexing

- Установите Disable Subdomain Indexing на «Yes»

- Сохраните изменения и опубликуйте свой сайт

A unique robots.txt будет опубликовано только на поддомене, указав поисковым системам игнорировать домен.

Создание файла robots.txt

Файл robots.txt обычно используется для перечисления URL-адресов на сайте, которые вы не хотите, чтобы поисковые системы сканировали. Вы также можете включить карту сайта своего сайта в файл robots.txt, чтобы сообщить сканерам поисковых систем, какой контент они должны сканировать .

Как и карта сайта, файл robots.txt находится в каталоге верхнего уровня вашего домена.Webflow сгенерирует файл /robots.txt для вашего сайта, как только вы заполните его в настройках своего проекта.

- Перейдите в Project Settings → SEO → Indexing

- Добавьте robots.txt правила, которые вы хотите (см. Ниже)

- Сохраните изменения и опубликуйте свой сайт

Создайте роботов .txt для вашего сайта, добавив правила для роботов, сохранив изменения и опубликовав свой сайт.

Robots.txt rules

Вы можете использовать любое из этих правил для заполнения роботов.txt файл.

- User-agent: * означает, что этот раздел применим ко всем роботам.

- Disallow: запрещает роботу посещать сайт, страницу или папку.

Чтобы скрыть весь сайт

User-agent: *

Disallow: /

Чтобы скрыть отдельные страницы

User-agent: *

Disallow: / page-name

Чтобы скрыть всю папку страниц

User-agent: *

Disallow: / folder-name /

Чтобы включить карту сайта

Sitemap: https: // your-site.com / sitemap.xml

Полезные ресурсы

Ознакомьтесь с другими полезными правилами robots.txt

Необходимо знать

- Содержимое вашего сайта может быть проиндексировано, даже если оно не было просканировано. Это происходит, когда поисковая система знает о вашем контенте либо потому, что он был опубликован ранее, либо есть ссылка на этот контент в другом онлайн-контенте. Чтобы страница не проиндексировалась, не добавляйте ее в robots.txt. Вместо этого используйте метакод noindex.

- Кто угодно может получить доступ к robots вашего сайта.txt, чтобы они могли идентифицировать и получать доступ к вашему личному контенту.

Лучшие практики

Если вы не хотите, чтобы кто-либо мог найти определенную страницу или URL-адрес на вашем сайте, не используйте файл robots.txt, чтобы запретить сканирование URL-адреса. Вместо этого используйте любой из следующих вариантов:

Попробуйте Webflow — это бесплатно

В этом видео используется старый интерфейс. Скоро выйдет обновленная версия!

Файл Robots.txt [Примеры 2021] — Moz

Что такое robots.txt файл?

Robots.txt — это текстовый файл, который веб-мастера создают, чтобы проинструктировать веб-роботов (обычно роботов поисковых систем), как сканировать страницы на своем веб-сайте. Файл robots.txt является частью протокола исключения роботов (REP), группы веб-стандартов, которые регулируют, как роботы сканируют Интернет, получают доступ и индексируют контент, а также предоставляют этот контент пользователям. REP также включает в себя такие директивы, как мета-роботы, а также инструкции для страницы, подкаталога или сайта о том, как поисковые системы должны обрабатывать ссылки (например, «следовать» или «nofollow»).

На практике файлы robots.txt показывают, могут ли определенные пользовательские агенты (программное обеспечение для веб-сканирования) сканировать части веб-сайта. Эти инструкции сканирования определяются как «запрещающие» или «разрешающие» поведение определенных (или всех) пользовательских агентов.

Базовый формат:

User-agent: [user-agent name] Disallow: [URL-строка не должна сканироваться]

Вместе эти две строки считаются полным файлом robots.txt, хотя один файл robots может содержат несколько строк пользовательских агентов и директив (т.е., запрещает, разрешает, задержки сканирования и т. д.).

В файле robots.txt каждый набор директив пользовательского агента отображается как дискретный набор , разделенных разрывом строки:

В файле robots.txt с несколькими директивами пользовательского агента, каждая из которых запрещает или разрешает правило только применяется к агентам-пользователям, указанным в этом конкретном наборе, разделенном разрывом строки. Если файл содержит правило, которое применяется более чем к одному пользовательскому агенту, поисковый робот будет только обратить внимание (и следовать директивам в) наиболее конкретной группе инструкций .

Вот пример:

Msnbot, discobot и Slurp вызываются специально, поэтому только пользовательские агенты будут обращать внимание на директивы в своих разделах файла robots.txt. Все остальные пользовательские агенты будут следовать директивам в группе user-agent: *.

Пример robots.txt:

Вот несколько примеров использования robots.txt для сайта www.example.com:

URL файла Robots.txt: www.example.com/robots.txt

Блокирование доступа всех поисковых роботов к содержимому

User-agent: * Disallow: /

Использование этого синтаксиса в файле robots.txt укажет всем поисковым роботам не сканировать никакие страницы www.example .com, включая домашнюю страницу.

Разрешение всем поисковым роботам доступа ко всему контенту

User-agent: * Disallow:

Использование этого синтаксиса в файле robots.txt указывает поисковым роботам сканировать все страницы на www.example.com, включая домашнюю страницу.

Блокировка определенного поискового робота из определенной папки

User-agent: Googlebot Disallow: / example-subfolder /

Этот синтаксис сообщает только поисковому роботу Google (имя агента пользователя Googlebot) не сканировать страницы, которые содержать строку URL www.example.com/example-subfolder/.

Блокирование определенного поискового робота с определенной веб-страницы

User-agent: Bingbot Disallow: /example-subfolder/blocked-page.html

Этот синтаксис сообщает только поисковому роботу Bing (имя агента пользователя Bing) избегать сканирование конкретной страницы www.example.com/example-subfolder/blocked-page.html.

Как работает robots.txt?

Поисковые системы выполняют две основные задачи:

- Сканирование Интернета для обнаружения контента;

- Индексирование этого контента, чтобы его могли обслуживать искатели, ищущие информацию.

Чтобы сканировать сайты, поисковые системы переходят по ссылкам с одного сайта на другой — в конечном итоге просматривая многие миллиарды ссылок и веб-сайтов. Такое ползание иногда называют «пауками».”

После перехода на веб-сайт, но перед его сканированием поисковый робот будет искать файл robots.txt. Если он найдет его, сканер сначала прочитает этот файл, прежде чем продолжить просмотр страницы. Поскольку файл robots.txt содержит информацию о том, как должна сканировать поисковая система, найденная там информация будет указывать на дальнейшие действия сканера на этом конкретном сайте. Если файл robots.txt содержит , а не содержат директив, запрещающих действия пользовательского агента (или если на сайте нет файла robots.txt), он продолжит сканирование другой информации на сайте.

Другой быстрый файл robots.txt, который необходимо знать:

(более подробно обсуждается ниже)

Чтобы его можно было найти, файл robots.txt должен быть помещен в каталог верхнего уровня веб-сайта.

Robots.txt чувствителен к регистру: файл должен называться «robots.txt» (не Robots.txt, robots.TXT и т. Д.).

Некоторые пользовательские агенты (роботы) могут игнорировать ваших роботов.txt файл. Это особенно характерно для более гнусных поисковых роботов, таких как вредоносные роботы или парсеры адресов электронной почты.

Файл /robots.txt является общедоступным: просто добавьте /robots.txt в конец любого корневого домена, чтобы увидеть директивы этого веб-сайта (если на этом сайте есть файл robots.txt!). Это означает, что любой может видеть, какие страницы вы хотите или не хотите сканировать, поэтому не используйте их для сокрытия личной информации пользователя.

Каждый субдомен в корневом домене использует отдельных роботов.txt файлы. Это означает, что и blog.example.com, и example.com должны иметь свои собственные файлы robots.txt (по адресу blog.example.com/robots.txt и example.com/robots.txt).

Обычно рекомендуется указывать расположение любых карт сайта, связанных с этим доменом, в нижней части файла robots.txt. Вот пример:

Выявление критических предупреждений robots.txt с помощью Moz Pro

Функция сканирования сайта Moz Pro проверяет ваш сайт на наличие проблем и выделяет срочные ошибки, которые могут помешать вам появиться в Google.Воспользуйтесь 30-дневной бесплатной пробной версией и посмотрите, чего вы можете достичь:

Начать бесплатную пробную версию

Технический синтаксис robots.txt

Синтаксис Robots.txt можно рассматривать как «язык» файлов robots.txt . Есть пять общих терминов, которые вы, вероятно, встретите в файле robots. К ним относятся:

User-agent: Конкретный поисковый робот, которому вы даете инструкции для сканирования (обычно это поисковая система). Список большинства пользовательских агентов можно найти здесь.

Disallow: Команда, используемая для указания агенту пользователя не сканировать определенный URL. Для каждого URL разрешена только одна строка «Disallow:».

Разрешить (применимо только для робота Googlebot): команда, сообщающая роботу Googlebot, что он может получить доступ к странице или подпапке, даже если его родительская страница или подпапка могут быть запрещены.

Crawl-delay: Сколько секунд сканер должен ждать перед загрузкой и сканированием содержимого страницы.Обратите внимание, что робот Googlebot не подтверждает эту команду, но скорость сканирования можно установить в консоли поиска Google.

Карта сайта: Используется для вызова местоположения любых XML-файлов Sitemap, связанных с этим URL. Обратите внимание, что эта команда поддерживается только Google, Ask, Bing и Yahoo.

Сопоставление с шаблоном

Когда дело доходит до фактических URL-адресов, которые нужно заблокировать или разрешить, файлы robots.txt могут стать довольно сложными, поскольку они позволяют использовать сопоставление с образцом для охвата диапазона возможных вариантов URL.И Google, и Bing соблюдают два регулярных выражения, которые можно использовать для идентификации страниц или подпапок, которые SEO хочет исключить. Эти два символа — звездочка (*) и знак доллара ($).

- * — это подстановочный знак, который представляет любую последовательность символов.

- $ соответствует концу URL-адреса

Google предлагает здесь большой список возможных синтаксисов и примеров сопоставления с образцом.

Где находится файл robots.txt на сайте?

Когда бы они ни заходили на сайт, поисковые системы и другие роботы, сканирующие Интернет (например, сканер Facebook, Facebot), знают, что нужно искать роботов.txt файл. Но они будут искать этот файл только в в одном конкретном месте : в основном каталоге (обычно в корневом домене или на домашней странице). Если пользовательский агент посещает www.example.com/robots.txt, а не находит там файла robots, он будет считать, что на сайте его нет, и продолжит сканирование всего на странице (и, возможно, даже на всем сайте. ). Даже если страница robots.txt действительно существует, существует, скажем, по адресу example.com/index/robots.txt или www.example.com/homepage/robots.txt, он не будет обнаружен пользовательскими агентами, и поэтому сайт будет обрабатываться так, как если бы на нем вообще не было файла robots.

Чтобы гарантировать, что ваш файл robots.txt найден, всегда включайте его в свой основной каталог или корневой домен.

Зачем нужен robots.txt?

Файлы Robots.txt управляют доступом поискового робота к определенным областям вашего сайта. Хотя это может быть очень опасным, если вы случайно запретите роботу Google сканировать весь ваш сайт (!!), в некоторых ситуациях файл robots.txt может быть очень кстати.

Некоторые распространенные варианты использования включают:

- Предотвращение появления дублированного контента в результатах поиска (обратите внимание, что мета-роботы часто являются лучшим выбором для этого)

- Сохранение конфиденциальности целых разделов веб-сайта (например, промежуточного сайта вашей группы инженеров)

- Предотвращение показа страниц с результатами внутреннего поиска в общедоступной поисковой выдаче

- Указание местоположения карты (карт) сайта

- Запрет поисковым системам индексировать определенные файлы на вашем веб-сайте (изображения, PDF-файлы и т. Д.))

- Указание задержки сканирования для предотвращения перегрузки ваших серверов, когда сканеры загружают сразу несколько частей контента

Если на вашем сайте нет областей, к которым вы хотите контролировать доступ агента пользователя, вы не можете вообще нужен файл robots.txt.

Проверка наличия файла robots.txt

Не уверены, есть ли у вас файл robots.txt? Просто введите свой корневой домен, а затем добавьте /robots.txt в конец URL-адреса. Например, файл роботов Moz находится по адресу moz.ru / robots.txt.

Если страница .txt не отображается, значит, у вас нет (активной) страницы robots.txt.

Как создать файл robots.txt

Если вы обнаружили, что у вас нет файла robots.txt или вы хотите изменить свой, создание файла — простой процесс. В этой статье от Google рассматривается процесс создания файла robots.txt, и этот инструмент позволяет вам проверить, правильно ли настроен ваш файл.

Хотите попрактиковаться в создании файлов роботов? В этом сообщении блога рассматриваются некоторые интерактивные примеры.

Лучшие методы SEO

Убедитесь, что вы не блокируете какой-либо контент или разделы своего веб-сайта, которые нужно просканировать.